CHAPVIDMR: 자연어 쿼리를 이용한 챕터 기반 비디오 순간 검색

Video Moment Retrieval (VMR)은 쿼리와 비디오의 특정 순간을 연결하는 기술입니다. 본 논문에서는 YouTube 비디오의 챕터 정보를 활용하여 단일 쿼리에 여러 비디오 순간을 연결하는 새로운 데이터셋인 ChapVidMR (Chapter-based Video Moment Retrieval)을 제안합니다. ChapVidMR은 챕터 이름과 메타데이터를 기반으로 GPT4를 사용하여 생성된 10.8K개의 사용자 쿼리로 구성됩니다. 이 데이터셋을 사용하여 두 가지 VMR 작업, 즉 챕터 분류 기반 VMR과 세분화 기반 VMR에 대한 벤치마크를 제공합니다. 실험 결과, 챕터 분류 작업에서는 Sentence-BERT가, 세분화 작업에서는 UniVTG가 가장 높은 성능을 보였습니다. 논문 제목: CHAPVIDMR: Chapter-based Video Moment Retrieval using Natural Language Queries

논문 요약: CHAPVIDMR: Chapter-based Video Moment Retrieval using Natural Language Queries

- 논문 링크: https://doi.org/10.1145/3702250.3702282

- 저자: Uday Agarwal, Yogesh Kumar, Abu Shahid, Prajwal Gatti, Manish Gupta, Anand Mishra (IIT Jodhpur, University of Bristol, Microsoft India)

- 발표 시기: 2024년 12월 (ICVGIP 2024)

- 주요 키워드: Video Moment Retrieval, CHAPVIDMR, VMR, chapter-based retrieval, Multimodal

1. 연구 배경 및 문제 정의

- 문제 정의:

비디오 모먼트 검색(VMR)은 자연어 쿼리를 비디오 내의 관련 순간과 연결하는 기술입니다. 기존 VMR 연구는 주로 단일 쿼리를 단일 비디오 순간과 연결하는 데 초점을 맞추었으나, 실제 사용자 쿼리는 종종 여러 비디오 순간(세그먼트)에 걸쳐 답변을 필요로 합니다. 이러한 다중 순간 검색은 충분히 연구되지 않았습니다. - 기존 접근 방식:

기존 VMR 데이터셋(DiDeMo, ActivityNet Captions 등)은 대부분 단일 쿼리와 단일 비디오 순간을 짝지으며, 모먼트가 비디오 시작 부분에 편향되는 경향이 있습니다. 또한, 기존의 one-stage 및 two-stage VMR 접근 방식들은 다중 세그먼트 검색의 복잡성을 완전히 다루지 못했습니다. Detection Transformer (DETR) 기반 접근 방식은 VMR에 적용되었지만, 학습 시 느린 수렴이라는 단점을 가집니다.

2. 주요 기여 및 제안 방법

- 논문의 주요 기여:

- YouTube 비디오 챕터를 활용하여 여러 챕터 이름과 YouTube 메타데이터에 연결된 사용자 쿼리를 생성하는 새로운 데이터셋인 ChapVidMR을 제안했습니다.

- ChapVidMR을 사용하여 멀티모달 feature를 활용한 챕터 분류 기반 VMR 및 세그먼트 기반 VMR task에 대한 baseline 솔루션을 제공했습니다.

- Sentence-BERT와 UniVTG가 각각 두 task에 대해 최고의 성능을 보임을 입증했습니다.

- 제안 방법:

논문은 YouTube 비디오의 챕터 정보를 활용하여 다중 순간 검색을 수행하는 ChapVidMR 데이터셋을 제안합니다.- 데이터셋 구축: YouTube 및 VidChapters-7M에서 비디오를 수집하고, GPT-4를 사용하여 비디오당 5개의 사용자 쿼리를 생성했습니다. 비디오 제목, 설명, 카테고리, 챕터별 메타데이터(자막, 시각 캡션, 챕터 이름, 대표 이미지)를 GPT-4에 제공하여 여러 챕터를 필요로 하는 자연스러운 쿼리를 생성하도록 유도했습니다. 세그먼트 기반 검색을 위해 챕터 경계를 더욱 세분화하는 과정도 포함되었습니다.

- 두 가지 VMR Task 정의:

- 챕터 분류 기반 VMR: 텍스트 쿼리가 주어졌을 때, 비디오와 관련된 챕터 중 쿼리에 가장 관련성이 높은 챕터를 분류하고 순위를 매깁니다. 텍스트(자막), 오디오, 시각(캡션, 비디오) 모달리티의 최신 feature representation 기술을 활용합니다.

- 세그먼트 기반 VMR: 비디오를 여러 세그먼트로 분할하고, 쿼리에 가장 적합할 가능성이 있는 세그먼트를 식별하여 반환합니다. 챕터 경계를 세분화하여 더 정확한 경계를 반환하도록 합니다.

3. 실험 결과

- 데이터셋:

ChapVidMR 데이터셋은 총 2,313개의 비디오와 10,779개의 쿼리로 구성됩니다 (학습 세트 8,627개, 테스트 세트 2,152개). 평균 비디오 길이는 322.8초, 평균 쿼리 길이는 17.7단어입니다. 비디오는 교육, 스포츠, 과학/기술 등 다양한 카테고리에 속합니다. 데이터셋 품질은 수동 평가를 통해 쿼리 자연스러움(3.12/4) 및 ground truth 챕터 답변 충분성(3.27/4)에서 우수한 점수를 받았습니다. 평가 지표로는 챕터 분류 VMR에 대해 Average IoU, Average Precision, Average Recall을, 세그먼트 기반 VMR에 대해 Recall@1 및 mAP (다양한 IoU 임계값)를 사용했습니다. - 주요 결과:

- 챕터 분류 기반 VMR:

- **Sentence-BERT와 mPLUG-Owl (자막 및 시각 캡션 활용)**의 통합이 가장 높은 성능을 달성했습니다 (평균 IoU 43.5%, 평균 Precision 53.7%, 평균 Recall 53.3%).

- ImageBind 및 LanguageBind 모델도 시각 캡션과 결합될 때 성능이 향상되었습니다. 특히 텍스트 청크를 사용할 때는 Max Score 집계 방식이 가장 좋은 결과를 보였습니다.

- 세그먼트 기반 VMR:

- UniVTG가 Moment-DETR 및 QD-DETR에 비해 두 task(챕터 분류 및 세그먼테이션) 모두에서 일관되게 가장 높은 성능을 달성했습니다 (예: R1@0.5 26.8%, mAP@0.5 11.7%). 이는 UniVTG가 복잡한 비디오 세그먼트를 미세하게 분석하고 해석하는 능력이 뛰어남을 시사합니다.

- 챕터 분류 기반 VMR:

4. 개인적인 생각 및 응용 가능성

- 장점:

기존 VMR 연구의 한계인 '단일 순간 검색'을 넘어 '다중 순간 검색'이라는 실제 사용자 요구를 반영한 새로운 데이터셋(ChapVidMR)을 제안한 점이 인상 깊습니다. YouTube 챕터 정보를 활용하여 비디오를 구조화하고, GPT-4를 통해 자연어 쿼리를 대량 생성한 데이터셋 구축 파이프라인이 체계적이고 효율적입니다. 텍스트, 오디오, 시각 등 다양한 모달리티를 활용하여 검색 성능을 높이려는 시도가 실제 환경에서의 복잡성을 잘 반영하며, 두 가지 현실적인 VMR task를 정의하고 벤치마크를 제공하여 향후 연구의 기반을 마련했습니다. - 단점/한계:

GPT-4에 의존한 쿼리 생성 과정에서 편향이 도입될 수 있다는 점은 한계로 지적될 수 있으며, 이에 대한 추가 연구가 필요합니다. 또한, DETR 기반 모델의 느린 수렴 문제는 대규모 비디오 데이터셋 처리 시 여전히 해결해야 할 과제입니다. 데이터셋의 비디오 수가 다른 대규모 VMR 데이터셋에 비해 상대적으로 적어, 더 광범위한 일반화 가능성을 위해서는 확장이 필요할 수 있습니다. - 응용 가능성:

본 연구는 YouTube와 같은 비디오 플랫폼에서 사용자가 특정 정보를 더 효율적으로 찾을 수 있도록 돕는 고급 검색 기능에 직접 적용될 수 있습니다. 교육 콘텐츠, 강의 비디오 등에서 특정 주제나 개념을 포함하는 챕터를 빠르게 찾아주는 데 활용될 수 있으며, 미디어 제작 및 편집 과정에서 특정 장면이나 대화가 포함된 비디오 세그먼트를 자동으로 식별하는 데 기여할 수 있습니다. 궁극적으로 긴 형식의 비디오 콘텐츠를 소비하는 사용자 경험을 향상시키고, 콘텐츠 관리 시스템의 효율성을 높일 수 있습니다.

Agarwal, Uday, et al. "CHAPVIDMR: Chapter-based Video Moment Retrieval using Natural Language Queries." Proceedings of the Fifteenth Indian Conference on Computer Vision Graphics and Image Processing. 2024.

CHAPVIDMR: Chapter-based Video Moment Retrieval using Natural Language Queries

Uday Agarwal*<br>IIT Jodhpur<br>Jodhpur, IN<br>agarwaluday@iitj.ac.in

Yogesh Kumar*<br>IIT Jodhpur<br>Jodhpur, IN<br>kumar.204@iitj.ac.in

Abu Shahid*<br>IIT Jodhpur<br>Jodhpur, IN<br>shahid.3@iitj.ac.in

Prajwal Gatti <br>University of Bristol<br>Bristol, UK<br>prajwalgatti126@gmail.com

Manish Gupta<br>MicrosoftIndia<br>Hyderabad, IN<br>gmanish@microsoft.com

Anand Mishra<br>CSE<br>Indian Institute of Technology<br>Jodhpur<br>Jodhpur, IN<br>mishra@iitj.ac.in

Query : 촬영 중 마이크를 바람 소리로부터 보호하고 오디오 왜곡을 방지하려면 무엇을 사용해야 하나요?

Input Video:

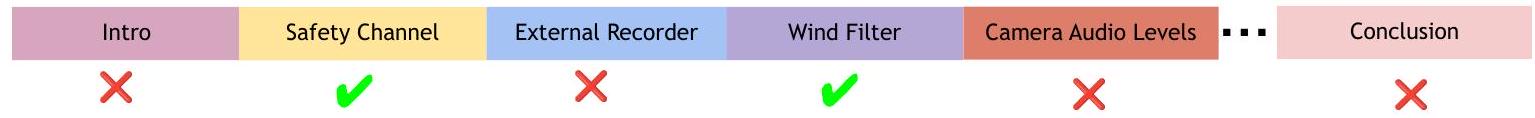

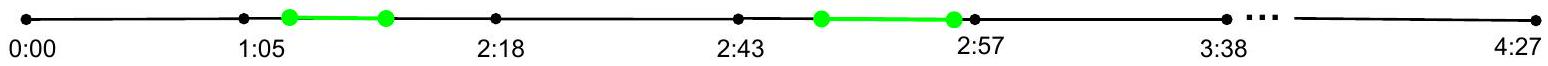

Task 1 : Chapter Classification-based Moment Retrieval

Task 2 : Segmentation-based Moment Retrieval

Figure 1: 제안하는 CHAPVIDMR 데이터셋 및 task의 예시. 그림의 상단은 디지털 카메라의 기술적 리뷰를 다루는 비디오 샘플을 보여주며, 이 비디오는 챕터로 분할되어 있고, 전체 비디오는 하나의 쿼리와 연결되어 있다. 그림의 하단은 제안된 데이터셋을 통해 수행 가능한 두 가지 task를 강조한다. Task 1: Chapter Classification-based retrieval task에서는 모델이 비디오와 관련된 챕터 중 **쿼리에 가장 관련성이 높은 챕터(녹색 체크 표시로 강조)**를 분류한다. Task 2: Segmentation-based retrieval task에서는 입력 비디오가 여러 segment로 나뉘며, **쿼리에 따라 가장 높은 순위의 segment가 원하는 순간(녹색 선으로 표시)**으로 검색된다.

Abstract

Video Moment Retrieval (VMR)은 쿼리를 비디오 내의 관련 순간(moment)과 연결하는 task이다. 최근에는 쿼리를 단일 순간과 연결하는 VMR task에 대한 연구가 진행되었지만, 쿼리를 여러 순간과 연결해야 하는 해당 task는 충분히 연구되지 않았다.

본 논문에서는 주로 YouTube 비디오의 챕터(즉, 비디오 세그먼트)를 활용하여 VMR task를 수행하는 것을 목표로 한다. YouTube 챕터는 콘텐츠 제작자가 주석을 달아 의미 있는 비디오 분할을 제공한다. 이러한 주석이 달린 분할된 영역은 사용자가 관심 있는 긴 비디오의 특정 세그먼트로 이동하는 데 도움을 준다.

우리는 ChapVidMR (Chapter-based Video Moment Retrieval) 데이터셋을 제시한다. 이 데이터셋은 YouTube API를 사용하여 비디오에서 추출한 여러 챕터 이름 및 기타 메타데이터를 활용하여 GPT4로 생성된 10.8K개의 사용자 쿼리를 포함한다.

나아가, 우리는 제안된 데이터셋을 두 가지 VMR task에 대해 벤치마크한다:

- 챕터 분류 기반 VMR (chapter classification-based VMR)

- 세그먼트 기반 VMR (segmentation-based VMR)

챕터 분류 기반 VMR task에서는 모델이 비디오와 관련된 챕터 중 쿼리에 가장 적합한 챕터를 분류한다. 우리는 최신 feature representation 기술을 사용하여 텍스트(자막), 오디오, 시각(캡션, 비디오) modality를 활용하여 챕터를 표현하고, 각 modality에 대한 철저한 ablation 실험을 수행한다.

세그먼트 기반 VMR에서는 비디오가 다양한 세그먼트로 분할되고, 쿼리에 가장 적합할 가능성이 있는 세그먼트가 식별되어 반환된다. 우리는 세그먼트 task에 대한 최신 방법들을 사용하여 데이터셋을 벤치마크한다.

우리는 챕터 분류 기반 VMR task의 경우 자막과 시각 캡션을 사용한 Sentence-BERT가 가장 좋은 결과를 보였고, 세그먼트 기반 VMR의 경우 UniVTG가 가장 정확하다는 것을 발견했다. 우리는 코드와 데이터를 공개적으로 제공한다.

This work is licensed under a Creative Commons Attribution International 4.0 License.

ICVGIP 2024, December 13-15, 2024, Bengaluru, India © 2024 Copyright held by the owner/author(s). ACM ISBN 979-8-4007-1075-9/24/12 https://doi.org/10.1145/3702250.3702282

CCS Concepts

- Computing methodologies Neural networks; Computer vision tasks; Visual content-based indexing and retrieval; Information systems Multimedia and multimodal retrieval.

Keywords

video moment retrieval, CHAPVIDMR, VMR, chapter-based retrieval

ACM Reference Format:

Uday Agarwal, Yogesh Kumar, Abu Shahid, Prajwal Gatti, Manish Gupta, and Anand Mishra. 2024. CHAPVIDMR: Chapter-based Video Moment Retrieval using Natural Language Queries. In Indian Conference on Computer Vision Graphics and Image Processing (ICVGIP 2024), December 13-15, 2024, Bengaluru, India. ACM, New York, NY, USA, 9 pages. https://doi.org/10.1145/ 3702250.3702282

1 Introduction

비디오 콘텐츠 분석 분야에서 [12,13,16-18], 방대한 비디오 자료에서 특정 세그먼트를 검색하고 추출하는 능력은 점점 더 중요해지고 있다. 이러한 기능은 콘텐츠 관리, 교육 자원 관리, 미디어 제작을 포함한 다양한 애플리케이션에 필수적이다. 이러한 비디오 모먼트 검색(Video Moment Retrieval, VMR) task의 필요성은 방대한 양의 비디오 콘텐츠와 관련 정보를 효율적으로 탐색하고 추출해야 하는 요구에 의해 촉진된다. 비디오 데이터의 양이 기하급수적으로 증가함에 따라, 수동 검색 및 탐색의 전통적인 방법은 비실용적이고 시간이 많이 소요된다. 본 연구는 YouTube 비디오의 "챕터"를 활용하여 이 문제에 대한 다른 접근 방식을 소개한다. YouTube 비디오의 챕터는 비디오 소유자가 주석을 달아놓은 미리 정의된 세그먼트로, 비디오 내에서 특정 콘텐츠를 더 쉽게 찾을 수 있게 해준다. 이러한 주석은 시청 경험을 향상시킬 뿐만 아니라 비디오를 구조화된 방식으로 분할하여 자동화된 프로세스에 매우 유용하다. 챕터의 사용은 비디오 내에 자연스러운 인덱스를 생성하여, 모먼트 검색 task를 잠재적으로 단순화하고 검색 결과의 정확도를 향상시킨다.

우리는 사용자들이 비디오의 특정 세그먼트, 특히 챕터로 정의된 부분에 대해 질문할 가능성이 더 높다고 가정한다. 이러한 아이디어는 챕터의 구조화된 특성에 기반하며, 챕터는 콘텐츠를 명확한 섹션으로 구성하여 사용자가 비디오의 특정 주제나 장면을 더 쉽게 찾고 참조할 수 있도록 한다. 챕터 구조는 서면 콘텐츠의 구성을 모방하여 시청자가 긴 형식의 비디오를 더 쉽고 정확하게 탐색할 수 있도록 한다. 이 가설은 사용자 행동에 대한 초기 관찰과 챕터 주석을 구현한 콘텐츠 제작자의 피드백에 의해 뒷받침된다. 이러한 챕터에 초점을 맞춤으로써, 우리는 사용자가 비디오 콘텐츠에서 정보를 검색하는 일반적인 방식과 우리의 검색 방법을 일치시키고자 한다. 또한, 챕터 정보를 활용하면 VMR task의 계산 복잡성을 줄일 수 있는데, 이는 비디오 콘텐츠 내에 미리 정의된 의미론적 경계를 제공하기 때문이다.

본 논문에서는 챕터 주석을 활용하도록 특별히 설계된 Chapter-based VMR (ChapVidMR) 데이터셋을 소개한다. 이 데이터셋은 여러 비디오 챕터의 이름과 YouTube API에서 얻은 기타 메타데이터를 기반으로 하는 사용자 쿼리로 구성된다. 이 접근 방식을 통해 우리는 종종 비디오의 여러 세그먼트에 걸쳐 있는 사용자 정보 요구의 다면적인 특성을 포착할 수 있다. 챕터 기반 메타데이터의 포함은 각 쿼리에 풍부한 컨텍스트를 제공하여 컨텍스트 인식 검색 모델을 가능하게 한다. CHAPVIDMR의 독특한 측면은 단일 비디오 세그먼트를 검색하는 전통적인 task를 넘어선다는 것이다. 대신, 사용자 쿼리에 대한 포괄적인 답변을 함께 제공하는 여러 관련 챕터를 식별하는 데 중점을 둔다. 이러한 다중 챕터 검색 패러다임은 기존 VMR task에서 상당한 변화를 나타내며, 실제 정보 탐색 행동의 복잡성을 다룬다. 이 접근 방식은 사용자가 정보를 찾는 방식을 모방하여, 더 효과적인 비디오 검색 시스템을 개발하는 데 귀중한 자원이 된다. 다중 모먼트 검색은 자연스러운 쿼리를 가능하게 할 뿐만 아니라 사용자가 쿼리에 대한 더 포괄적이고 컨텍스트적으로 관련성 있는 답변을 찾는 데 도움이 된다. ChapVidMR을 만들기 위해 우리는 다양한 소스에서 비디오를 선택하고 GPT4 [19]를 사용하여 비디오의 여러 챕터와 관련된 쿼리를 생성했다. 선택 과정은 다양한 주제와 비디오 스타일을 보장하여 데이터셋의 다양한 도메인에 대한 적용 가능성을 향상시켰다. GPT4를 활용함으로써, 우리는 실제 사용자 질문의 가변성을 시뮬레이션하여 언어적으로 다양하고 컨텍스트적으로 관련성 있는 많은 쿼리를 생성할 수 있었다. 이 과정은 쿼리가 자연스럽고 실제 사용자 문의를 대표하도록 보장했다. 쿼리는 실제 정보 요구의 복잡한 특성을 반영하여 다른 챕터의 정보를 결합해야 했다. 데이터셋의 이러한 복잡성은 다중 부분 쿼리를 이해하고 처리할 수 있는 더 정교한 검색 알고리즘의 개발을 장려하여 잠재적으로 더 강력하고 다재다능한 VMR 시스템으로 이어진다.

ChapVidMR을 기반으로, 우리는 챕터 분류 기반 VMR과 세그먼트 기반 VMR의 두 가지 task에 대해 벤치마크를 수행했다. 챕터 분류 task에서 모델은 비디오와 관련된 챕터 중 쿼리에 가장 관련성이 높은 챕터를 분류한다. 우리가 제안하는 솔루션은 각 챕터를 나타내기 위해 텍스트, 오디오, 비디오 데이터를 포함한 state-of-the-art 멀티모달 feature [7, 20, 29]를 활용한다. 이러한 feature의 통합은 모델이 다른 감각 입력을 통해 각 챕터의 관련성을 평가할 수 있도록 하여 분류의 정확도를 향상시키기 때문에 중요하다. 이는 오디오 신호나 시각적 요소가 콘텐츠의 쿼리 관련성에 대한 중요한 지표인 시나리오에서 특히 분명하다. 우리의 결과는 이 접근 방식이 특히 자막과 시각적 캡션을 활용할 때 정확하다는 것을 보여준다. 반면에, 세그먼트 기반 VMR [13, 16, 18]은 먼저 비디오를 여러 세그먼트로 나눈 다음 사용자 쿼리를 가장 잘 다루는 세그먼트를 결정하는 것을 포함한다. 이 task는 쿼리 요구 사항에 따라 비디오 콘텐츠를 세밀하게 분할하는 모델의 능력을 테스트한다.

요약하면, 우리의 주요 기여는 다음과 같다. (1) 우리는 YouTube 비디오 챕터를 활용하여 여러 챕터 이름과 YouTube 메타데이터에 연결된 사용자 쿼리를 생성하는 ChapVidMR 데이터셋을 소개한다. (2) ChapVidMR을 사용하여 멀티모달 feature를 활용한 챕터 분류 기반 VMR 및 세그먼트 기반 VMR task에 대한 baseline 솔루션을 제공한다. (3) 우리는 SentenceBERT와 UniVTG가 각각 두 task에 대해 최고의 결과를 가져온다는 것을 발견했다. 우리는 코드와 데이터셋을 공개적으로 이용 가능하게 한다.

2 Related Work

Video Moment Retrieval (VMR) 시스템 [6, 8, 13, 15, 16, 18]은 텍스트 설명을 기반으로 비디오 내의 시간적 세그먼트를 찾아낸다. 기존 VMR 시스템이 채택하는 두 가지 주요 전략은 one-stage 접근 방식과 two-stage 접근 방식이다. two-stage 접근 방식 [5, 8, 21, 22, 26-28]은 잠재적인 후보 모멘트 목록을 생성한 후, 다양한 점수에 따라 순위를 매기는 과정을 포함한다. 이러한 접근 방식은 일반적으로 광범위한 모멘트 목록을 텍스트 쿼리와 가장 일치할 가능성이 높은 모멘트로 좁히기 위한 필터링 메커니즘을 사용하여 효율성과 정밀도를 우선시한다. 이후, 더 정교한 알고리즘이 각 후보 모멘트의 관련성을 평가하여 검색의 전반적인 정확도를 향상시킨다. one-stage 접근 방식 [13-15, 18]은 전체 비디오를 직접 처리하고 지역화된 시간적 세그먼트의 시작 및 종료 타임스탬프를 반환한다. 이 방법은 예비 선택 단계를 건너뛰고, 강력한 모델을 사용하여 비디오 콘텐츠를 한 번에 파싱하고 이해하며, 이는 종종 더 빠른 응답 시간을 가져오지만 계산 집약적이라는 단점이 있다. 본 연구에서는 텍스트 쿼리에 가장 잘 맞는 여러(두 개 이상) 세그먼트를 검색하는, 아직 충분히 연구되지 않은 task에 중점을 두었다.

Video Moment Retrieval (VMR) 분야에서는 DiDeMo [8], ActivityNet Captions [10], CharadesSTA [6], TVR [15] 등 여러 데이터셋이 제안되었다. 이러한 데이터셋은 일반적으로 단일 쿼리와 비디오를 짝지으며, 모멘트가 비디오 전체보다 시작 부분에 더 자주 태그되는 시간적 편향을 보이는 경우가 많다. 이러한 한계는 실제 비디오 쿼리 시나리오의 다양성과 복잡성을 완전히 재현하지 못할 수 있다. 이에 대응하여, CHAPVIDMR 데이터셋은 YouTube 챕터에서 파생된 각 비디오에 대해 여러 모멘트와 쿼리를 포함함으로써 VMR 연구의 범위와 유용성을 향상시키도록 설계되었다. 이러한 설계 선택은 짧은 정보 클립부터 긴 내러티브 세션에 이르기까지 더 역동적이고 다양한 사용 사례를 반영하며, 데이터셋이 비디오 플랫폼에서의 일반적인 사용자 경험을 대표하도록 보장한다. ChapVidMR의 각 비디오는 VMR 시스템 개발을 위한 보다 포괄적인 리소스로서, 여러 주제 요소를 인식하고 연관시키는 데 필요한 미묘한 상호 작용을 지원한다. 이러한 한계를 해결하기 위해 우리는 YouTube 챕터를 활용하여 비디오당 여러 모멘트와 해당 쿼리를 수집하는 ChapVidMR 데이터셋을 소개한다. 이 접근 방식은 더 현실적인 비디오 콘텐츠와의 사용자 상호 작용을 모방하여 더 넓은 범위의 검색 task를 가능하게 한다. ChapVidMR에는 평균 길이가 322.8초인 비디오가 포함되어 있으며, 비디오당 여러 쿼리를 지원하고 각 쿼리는 평균 17.7단어이다. 이러한 설정은 VMR task를 위한 더 풍부한 데이터셋을 제공하여, 상세한 쿼리 생성과 비디오 콘텐츠의 견고한 세그먼테이션 및 분류를 가능하게 한다. 이를 통해 CHAPVIDMR은 VMR 시스템이 다양하고 복잡한 비디오 컨텍스트를 얼마나 효과적으로 처리할 수 있는지에 대한 보다 세분화된 조사를 용이하게 한다. 또한, Fig. 3에 설명된 프레임워크는 CHAPVIDMR의 확장성을 보장하여 비디오 및 쿼리 수를 늘리는 것을 용이하게 한다. 이러한 확장성은 다양한 비디오 길이와 복잡성에 적응할 수 있는 견고한 VMR 모델을 개발하는 데 중요하다.

**Detection Transformer (DETR)**와 Transformer 기반 사전학습 [1, 4, 11]의 등장은 Transformer encoder-decoder 아키텍처를 사용하고 객체 탐지를 직접적인 집합 예측 파이프라인으로 간주하는 모델로서, 모멘트 검색 task를 동일한 관점에서 볼 수 있게 했다 [13]. 이는 앵커 생성 및 non-maximum suppression의 필요성을 제거하여 쿼리와 가장 관련성이 높은 비디오 내 시간적 세그먼트를 지역화하는 파이프라인을 단순화한다. 이러한 간소화는 검색 프로세스의 복잡성을 줄일 뿐만 아니라, 세그먼트와 쿼리의 관련성에 직접적으로 초점을 맞춰 정밀도를 향상시킨다. 또한, DETR 프레임워크는 end-to-end 학습을 가능하게 하여 모델의 학습을 모멘트 검색 task의 특정 뉘앙스와 더욱 일치시킨다. 이러한 개선에도 불구하고, DETR을 비디오 모멘트 검색에 통합하는 것은 특히 방대한 양의 비디오 데이터와 다양한 범위의 쿼리를 처리하는 데 어려움을 제기한다. 이후 이미지 [2, 3, 9]와 비디오 [11, 18, 23] 두 도메인 모두에서 다운스트림 task를 위한 DETR 기반 접근 방식의 적용이 증가했다. 이러한 증가는 DETR이 다양한 미디어 형식과 추출 task에 적응할 수 있는 다재다능한 능력을 가지고 있음을 나타내며, 초기 객체 탐지 범위를 넘어선 유용성을 입증한다. 성공에도 불구하고, DETR 기반 접근 방식은 학습 시간 동안 느린 수렴이라는 단점을 가지고 있다. 이 문제는 시간적 역학 및 컨텍스트 다양성이 최적의 성능을 달성하기 위해 광범위한 학습 반복을 요구하는 복잡한 비디오 데이터셋에서 특히 두드러진다. 본 연구에서는 state-of-the-art DETR 기반 접근 방식을 실험하고, 챕터 분류 기반 VMR 및 경계 세그먼테이션 기반 VMR task에서의 성능 결과를 보고한다.

3 ChapVidMR: Chapter-based VMR Dataset

우리는 다양한 도메인에 걸쳐 비디오 세그먼트-쿼리 쌍을 모아놓은 데이터셋인 CHAPVIDMR을 소개한다. 이 데이터셋은 VidChapters-7M 데이터셋 [24]과 YouTube의 비디오를 활용하여 구축되었다. ChapVidMR은 챕터 정보를 활용하는 비디오를 사용하여 구성되었으며, 쿼리에 가장 관련성이 높은 챕터를 분류하는 데 중점을 둔다. 우리는 ChapVidMR을 사용하여 두 가지 task의 벤치마크를 수행한다: Chapter-based Classification retrieval과 Boundary Segmentation based retrieval.

Table 1은 CHAPVIDMR의 크기를 기존 moment retrieval 데이터셋과 비교하여 보여주며, ChapVidMR의 쿼리와 비디오가 모두 더 길다는 점을 강조한다. 또한, 우리 데이터셋은 일반적으로 비디오당 여러 챕터 또는 세그먼트를 포함하고 구조화된 챕터 정보를 활용하여, 단일 시간 세그먼트만으로는 쿼리를 충분히 해결할 수 없는 보다 현실적인 시나리오를 제공한다.

3.1 ChapVidMR Dataset Analysis

우리는 VidChapters-7M [24]과 YouTube에서 2,500개의 비디오를 수집하고, GPT4를 사용하여 비디오당 5개의 쿼리를 생성하도록 prompt를 구성했다.

| Dataset | Multi-moments | Chapter used | #Videos | #Queries | Avg. video len (sec) | Avg. query len (words) |

|---|---|---|---|---|---|---|

| DiDeMo [8] | 10.6 K | 41.2 K | 29.3 | 8.0 | ||

| ActivityNet Captions [10] | 15.0 K | 72.0 K | 117.6 | 14.8 | ||

| CharadesSTA [6] | 6.7 K | 16.1 K | 30.6 | 7.2 | ||

| TVR [15] | 21.8 K | 109 K | 76.2 | 13.4 | ||

| VidChapter-7M [24] | 817 K | - | 1380.0 | - | ||

| QV Highlights [13] | 10.2 K | 10.3 K | 150.0 | 11.3 | ||

| ChapVidMR (ours) | 2.3 K | 10.8 K | 322.8 | 17.7 |

Table 1: CHAPVIDMR과 다른 비디오 moment retrieval 데이터셋들의 비교. 우리 데이터셋은 쿼리 생성 및 multi-moment retrieval을 위해 chapter 정보를 활용한다. 제안된 데이터셋은 기존 moment retrieval 데이터셋보다 평균 비디오 길이가 길며, 쿼리 길이도 더 길다.

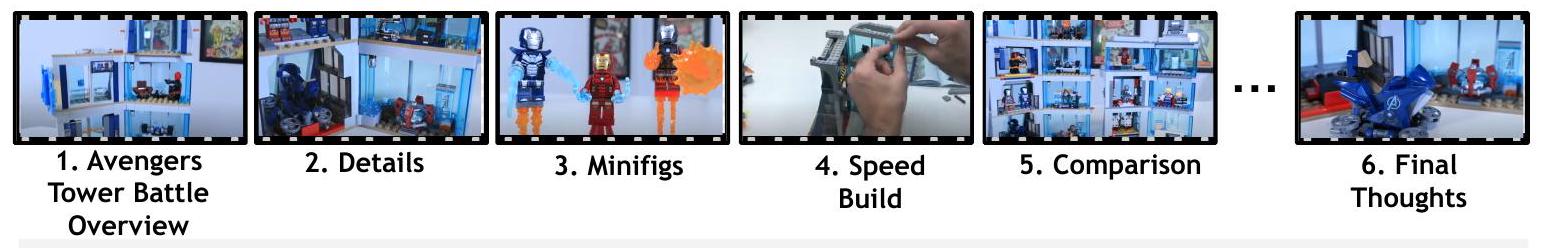

Query 1 [chapters ] : LEGO Avengers Tower 세트에 포함된 Infinity Gauntlet은 Red Skull의 로켓 런처와 디자인 및 플레이 가능성 측면에서 어떻게 비교되나요?

Query 2 [chapters ]: 가격 차이를 고려할 때, 어떤 Avengers Tower 세트가 기능과 미니피겨 측면에서 더 나은 가성비를 제공하나요?

Query 3 [chapters( )]: 새로운 LEGO Avengers Tower를 만드는 것이 다른 유사한 세트와 비교하여 어떤 점에서 재미있는 경험을 제공하나요?

Query 1 [chapters (2,5)]: Victor Jet Speed S12의 공기역학적 특징과 무게를 고려할 때, 어떤 유형의 배드민턴 선수에게 가장 적합할까요?

Query 1 [chapters (2,5)]: Victor Jet Speed S12의 공기역학적 특징과 무게를 고려할 때, 어떤 유형의 배드민턴 선수에게 가장 적합할까요?

Query 2 [chapters 3,7)]: Victor Jet Speed S12를 구매하지 않기로 결정하는 데 영향을 미칠 수 있는 단점은 무엇인가요? Query 3 [chapters ( )]: Volant Rogue S1 라켓은 평가 지표를 기준으로 Victor Jet Speed S12와 비교하여 다용도성 및 전반적인 플레이 측면에서 어떤가요?

Figure 2: ChapVidMR 데이터셋에서 쿼리 생성에 사용된 쿼리 및 해당 ground truth chapter (괄호 안)의 시각화.

Large Language Model은 오류가 발생하기 쉬우므로, 존재하지 않는 chapter를 반환하거나 손상된 응답을 반환할 수 있다. 추가적인 데이터 정제 후, 최종적으로 2,313개의 비디오가 남았다. 이 비디오들로부터 총 10,779개의 쿼리를 얻었으며, 이 중 8,627개(80%)는 학습 세트에, 2,152개(20%)는 테스트 세트에 포함된다. 데이터셋 통계에 대한 자세한 요약은 Table 2에 제시되어 있다. Fig. 2는 데이터셋의 몇 가지 샘플을 보여준다. 비디오는 교육, 인물 및 블로그, 스포츠, 뉴스 및 정치, HowTo 및 스타일, 과학 및 기술, 엔터테인먼트, 영화 및 애니메이션 등 다양한 카테고리에 속한다. chapter의 평균 길이는 46.8초로, 평균 비디오 길이의 14.8%에 해당한다.

우리는 또한 데이터셋 품질에 대한 수동 평가를 수행했다. 세 명의 annotator가 100개의 샘플을 평가했다. 각 annotator는 두 가지 기준에 따라 100개의 모든 쿼리를 평가하도록 요청받았다: (1) 쿼리가 자연스러운가? (2) ground truth chapter가 쿼리에 충분히 답변하는가? 각 기준에 대해 annotator는 0-4점의 Likert 척도로 점수를 보고하도록 요청받았다. 두 기준에 대한 평균 점수는 각각 3.12점과 3.27점으로 나타났다. 이러한 결과는 우리가 제안한 데이터셋의 우수한 품질을 나타낸다.

| Splits | Max | Min | ||||

|---|---|---|---|---|---|---|

| 。 | Full Dataset | 326.2 | 296 | 146.6 | 600 | 34 |

| Train Set | 326.2 | 296 | 146.5 | 600 | 34 | |

| Test Set | 326.3 | 361 | 209.8 | 563 | 55 | |

| Full Dataset | 17.9 | 18 | 3.5 | 41 | 7 | |

| Train Set | 17.9 | 18 | 3.5 | 41 | 7 | |

| Test Set | 17.6 | 18 | 2.6 | 22 | 11 |

Table 2: 제안된 ChapVidMR 데이터셋의 통계로, 비디오 길이(초) 및 쿼리 길이(단어)로 측정되었다. 평균 길이; 중앙값 길이; 표준 편차

3.2 Dataset Curation Pipeline

이 섹션에서는 Fig. 3에 나타난 바와 같이, 후보 비디오 수집 및 구성 챕터와 관련 메타데이터 추출 처리를 포함하여 데이터셋을 큐레이션하는 데 사용된 파이프라인을 설명한다.

비디오 큐레이션 (Video Curation): 우리는 YouTube 및 VidChapters7M 데이터셋 [24]에서 비디오를 수집하고 다음 제약 조건을 따른다: (i) 비디오 길이는 10분을 초과하지 않아야 한다; (ii) 비디오는 최소 3개 이상의 사용자 생성 챕터를 포함해야 한다; (iii) Gaming 및 Music 카테고리에 속하는 비디오는 제외한다. 이러한 비디오는 사용자가 자연스럽게 검색할 만한 정보를 포함하지 않는 경우가 많기 때문이다; (iv) 비디오는 최소 300회 이상의 조회수를 기록해야 한다. 이러한 조건을 부과함으로써 노이즈로 간주될 수 있는 비디오(예: 봇이 생성한 비디오, 품질이 낮거나 오해의 소지가 있는 메타데이터를 가진 비디오, 안전하지 않은 비디오)를 충분히 필터링할 수 있음을 확인했다. 다음으로, 우리는 챕터 시간 경계를 기준으로 후보 비디오를 클립으로 분할한다.

메타데이터 생성 (Generating Metadata): 비디오가 구성 챕터로 분할되면, 우리는 **사용 가능한 메타데이터(자막, 설명)**를 추출하고, 추가적으로 mPLUG-Owl [25]을 사용하여 각 비디오의 각 챕터에 대한 visual caption을 생성한다. Visual caption은 비디오의 내용과 맥락에 대한 추가적인 이해를 제공한다.

쿼리 생성 (Generating Queries): 우리는 Fig. 3에 자세히 설명된 바와 같이 GPT4 (visual variant) [19]를 사용하여 사용자 친화적인 쿼리를 생성한다. 이를 위해, 우리는 GPT4에게 효과적이고 완전한 답변을 위해 여러 챕터를 필요로 하는 쿼리를 생성하도록 prompt한다. GPT4가 자연스러운 쿼리를 생성하도록 유도하기 위해, 우리는 다음 맥락적 데이터를 제공한다: YouTube 비디오의 제목, 설명, 카테고리. 또한, 자막, visual caption, 챕터 이름을 포함하는 챕터별 메타데이터가 제공된다. 우리는 **챕터의 대표 이미지(중간 프레임)**를 GPT4에 제공하여 이러한 풍부한 텍스트 맥락을 보완하고, GPT4가 시각적 도메인을 활용할 수 있도록 한다. GPT4로부터 좋은 응답을 보장하기 위해, 우리는 Table 3에 나타난 바와 같이 prompt의 일부로 일련의 규칙을 코딩하였다.

더 세분화된 경계 생성 (Generating Finer Boundaries): 세그먼트 기반 검색(segment-based retrieval) task를 위해, 우리는 챕터 경계를 더욱 세분화하였다. 우리는 쿼리와 그에 연결된 챕터 자막(타임스탬프에 따라 번호가 매겨짐)을 GPT4에 전달한다. GPT4는 쿼리에 답변하기 위한 가장 적절한 문장을 선택하는 task를 수행한다. 마지막으로, 우리는 챕터 경계 내에서 선택된 문장을 기반으로 더 세분화된 경계의 타임스탬프를 결정한다.

4 Benchmarking ChapVidmR using State-of-The-Art Approaches

4.1 Tasks enabled by ChapVidmR

Chapter Classification 기반 VMR Task: 이 task의 목표는 Fig. 4 (왼쪽)에 나타난 것처럼 텍스트 쿼리가 주어졌을 때 여러 chapter를 추출하는 것이다. 검색된 chapter들은 관련성에 따라 순위가 매겨지며, 주어진 쿼리에 효과적으로 답변하는 데 필요한 상위 chapter들이 결과로 보고된다. 기존의 VMR 방법들은 주어진 텍스트와 가장 관련성이 높은 비디오 세그먼트의 시작 및 종료 타임스탬프를 반환한다. 그러나 chapter는 타임스탬프로 특징지어지는 세그먼트에 비해 더 많은 맥락 정보를 제공한다. 이는 chapter가 일반적으로 비디오 내의 자연스러운 내용 분할을 기반으로 생성되기 때문에 더 직관적이고 정보가 풍부하기 때문이다. chapter의 제목은 즉각적인 맥락을 제공하여 시청자가 비디오 세그먼트의 내용을 한눈에 이해하고, 긴 비디오에서 정보를 검색할 필요 없이 관련 chapter로 직접 이동할 수 있도록 한다.

Boundary Segmentation 기반 VMR Task: Fig. 4 (오른쪽)에 나타난 Moment Retrieval task [13, 16, 18]와 유사하게, 우리는 Finer Boundary segmentation task에 대해 데이터셋을 벤치마킹한다. 이 task에서는 비디오와 텍스트 쿼리가 주어졌을 때, 모델이 비디오를 여러 부분으로 분할하고 쿼리에 답하는 가장 적절한 세그먼트를 반환한다. 이 task를 위해 우리는 chapter 경계를 더욱 세분화하여 chapter 내에서 더 정확한 경계를 반환하도록 했다 (자세한 내용은 Section 3.2 참조).

4.2 Benchmarking

Chapter Classification 기반 VMR 방법: 우리는 주어진 쿼리에 답하기 위해 필요한 여러 상위 세그먼트를 분류하고 검색하기 위해 LanguageBind [29], ImageBind [7], UniVTG [16], 그리고 **SentenceBERT [20]**를 실험한다. 우리의 실험 설정은 먼저 비디오를 주어진 챕터로 분할한 다음, 각 챕터의 시각, 언어, 오디오 양식(modality)에 대한 임베딩을 추출하는 것을 포함한다.

**ImageBind [7]**는 모든 조합의 쌍 데이터 대신 이미지-쌍 데이터만으로도 조인트 임베딩 공간을 효과적으로 학습하여 다른 양식들을 바인딩하고, 교차-모달 검색, 교차-모달 감지, 생성 등과 같은 새로운 emergent 애플리케이션을 가능하게 한다는 것을 보여주는 접근 방식이다.

**LanguageBind [29]**는 비디오-언어 사전학습을 오디오를 포함한 여러 양식으로 확장하는 멀티모달 사전학습 프레임워크이다. 언어를 바인딩의 기준으로 삼아 모든 양식들이 통합된 임베딩 공간으로 매핑되며, 이를 통해 효과적인 의미 정렬이 가능해진다. ImageBind가 이미지를 중간 매개체로 사용하는 반면, LanguageBind는 이러한 요구 사항을 완전히 없애고 모든 양식을 언어 공간에 직접 정렬하여 다운스트림 task에서 추가 양식에 대한 적용 가능성을 높인다.

**Sentence-BERT [20]**는 잘 알려진 BERT [4] 모델의 수정 버전으로, siamese 및 triplet 네트워크 구조를 사용하여 코사인 유사도를 통해 효율적이고 정확하게 비교할 수 있는 텍스트 쿼리를 도출한다. 이는 BERT의 출력에 풀링(pooling) 연산을 추가하는데, 구체적으로 세 가지 풀링 실험이 시도된다:

- CLS-token의 출력 사용,

- 모든 출력 벡터의 평균 취하기,

- 출력 벡터에 대한 max-over-time 계산. 기본 설정은 평균(mean)이다. Sentence-BERT의 경우, 자막과 시각 캡션의 임베딩만 추출된다. 각 세그먼트의 임베딩과 쿼리 표현 간의 내적(dot product)이 계산된다. 그런 다음, 각 양식(오디오, 텍스트, 시각)에 따라 상위 두 개의 덩어리(chunk)가 검색된다.

챕터 분류 VMR을 위한 청크(Chunked) 텍스트 방법: ImageBind [7]와 LanguageBind [29]의 토크나이저는 77개 토큰(약 58단어)만 처리하여 문맥 잘림(context truncation)이 발생한다. 따라서,

Figure 3: 데이터 생성 파이프라인. 그림의 왼쪽 부분은 (i) 챕터 시각 캡션, (ii) 각 챕터의 대표 프레임, (iii) 챕터 자막의 생성을 보여준다. 우리는 비디오 캡셔너(mPLUG-Owl [25])를 사용하여 챕터별 시각 캡션을 생성하고, YouTube API를 사용하여 챕터 자막을 추출한다. 오른쪽 부분은 GPT4를 사용한 데이터 생성을 보여준다. 우리는 (i) 챕터 시각 캡션, (ii) 챕터의 대표 프레임, (iii) 챕터 자막, 그리고 (iv) 일련의 규칙을 GPT4에 입력한다. 마지막으로, GPT4는 최종 데이터셋을 구성하는 데 사용되는 쿼리와 ground truth 챕터를 반환한다.

Figure 3: 데이터 생성 파이프라인. 그림의 왼쪽 부분은 (i) 챕터 시각 캡션, (ii) 각 챕터의 대표 프레임, (iii) 챕터 자막의 생성을 보여준다. 우리는 비디오 캡셔너(mPLUG-Owl [25])를 사용하여 챕터별 시각 캡션을 생성하고, YouTube API를 사용하여 챕터 자막을 추출한다. 오른쪽 부분은 GPT4를 사용한 데이터 생성을 보여준다. 우리는 (i) 챕터 시각 캡션, (ii) 챕터의 대표 프레임, (iii) 챕터 자막, 그리고 (iv) 일련의 규칙을 GPT4에 입력한다. 마지막으로, GPT4는 최종 데이터셋을 구성하는 데 사용되는 쿼리와 ground truth 챕터를 반환한다.

| S.No. | Rule |

|---|---|

| 1 | 쿼리는 사람이 질문하는 방식처럼 자연스러워야 한다. |

| 2 | 의미 있는 쿼리를 생성할 수 있다고 생각하는 두 챕터를 선택하라. 가능하다면 하나를 생성하고, 그렇지 않으면 'NONE'을 반환하라. |

| 3 | 쿼리는 단일 문장이어야 한다. 두 개의 비디오 챕터가 개별적으로 답변할 수 있는 두 개의 독립적인 쿼리를 결합하기 위해 "and" 또는 유사한 접속사를 사용하지 마라. |

| 4 | 쿼리는 사람이 작성하는 방식처럼 자연스러워야 하며, 쿼리는 세부 사항, 세분성, 그리고 어떤 챕터에 초점을 맞추는지에 따라 다를 수 있다. |

| 5 | 이 캡션들은 API를 사용하여 생성되었으며, 노이즈가 있을 수 있다. 따라서, 이를 해석할 때 주의하라. |

| 6 | 확신할 수 없는 것은 가정하지 마라. |

| 7 | 챕터 주석에 제공된 시각 캡션 및 비디오 프레임을 통해 제공되는 시각적 문맥을 사용하여 쿼리를 생성하라. 자막과 챕터 이름은 당신의 문맥을 위한 것이며, 쿼리를 묻거나 답하는 사용자는 그것들에 접근할 수 없다. |

| 8 | 질문을 구성할 때 도입부 및 마무리 챕터를 사용하지 마라. |

Table 3: 쿼리 생성을 위해 GPT에 제공된 규칙.

| Method | Modalities | Avg IoU | Avg Precision | Avg Recall |

|---|---|---|---|---|

| Random Baseline | - | 25.5 | 35.4 | 31.1 |

| ImageBind [7] | Audio | 25.3 | 35.6 | 33.4 |

| ImageBind [7] | Video | 35.9 | 47.0 | 44.7 |

| ImageBind [7] + mPLUG-Owl [25] | Subtitles + Visual Captions | 27.2 | 36.2 | 37.5 |

| LanguageBind [29] | Audio | 26.7 | 36.1 | 35.5 |

| LanguageBind [29] | Video | 35.9 | 47.0 | 44.7 |

| LanguageBind [29] + mPLUG-Owl [25] | Subtitles + Visual Captions | 36.0 | 46.7 | 45.7 |

| Sentence-BERT [20] + mPLUG-Owl [25] | Subtitles + Visual Captions | 43.5 | 53.7 | 53.3 |

Table 4: 챕터 분류 VMR 결과. 챕터가 자막과 시각 캡션으로 보강될 때, Sentence-BERT는 다른 방법들에 비해 가장 좋은 결과를 산출한다.

우리는 먼저 챕터 텍스트를 각각 30단어씩의 **청크(chunk)**로 나눈다. 그런 다음, 자막만 사용한 경우, 시각 캡션만 사용한 경우, 그리고 자막과 시각 캡션을 함께 연결한 경우를 사용하여 실험을 수행한다. 우리는 다음 세 가지 방식으로 일관된 청크들에 대한 집계(aggregate)로서 챕터별 점수를 계산한다. (1) 평균 점수(Mean Score): 먼저 각 30단어 문자열의 임베딩을 추출하고, 이들 각각과 쿼리의 내적을 계산한다. 그런 다음, 이 점수들의 평균을 챕터 점수로 계산한다. (2) 평균 풀링(Mean Pool): 단일 챕터의 모든 청크 임베딩을 평균 풀링한 다음, 쿼리와 내적을 계산한다. (3) 최대 점수(Max Score): 각 청크 임베딩과 쿼리 임베딩의 내적 점수를 계산하고, 최대 점수를 챕터 점수로 선택한다.

Figure 4: 방법론 설명. 그림의 왼쪽 부분은 분류 기반 모먼트 검색 과정을 보여준다. 각 비디오 챕터는 양식별로 세 개의 인코더에 의해 처리된다. 챕터와 텍스트 쿼리 간의 유사도는 내적을 사용하여 계산된다. 챕터는 유사도 점수를 기반으로 순위가 매겨지고 검색된다. 이미지의 오른쪽 부분은 세그먼트 기반 검색 프레임워크를 보여준다. 여기서는 비디오와 텍스트 쿼리 모두 비디오 모먼트 세그먼테이션 모델에 입력된다. 상위 순위의 세그먼트 영역은 출력 세그먼트로 검색된다.

Figure 4: 방법론 설명. 그림의 왼쪽 부분은 분류 기반 모먼트 검색 과정을 보여준다. 각 비디오 챕터는 양식별로 세 개의 인코더에 의해 처리된다. 챕터와 텍스트 쿼리 간의 유사도는 내적을 사용하여 계산된다. 챕터는 유사도 점수를 기반으로 순위가 매겨지고 검색된다. 이미지의 오른쪽 부분은 세그먼트 기반 검색 프레임워크를 보여준다. 여기서는 비디오와 텍스트 쿼리 모두 비디오 모먼트 세그먼테이션 모델에 입력된다. 상위 순위의 세그먼트 영역은 출력 세그먼트로 검색된다.

세그먼테이션 기반 VMR 방법: 우리는 더 정교한 경계 세그먼테이션 검색 task를 위해 다음 방법들을 사용한다: Moment-DETR [13], QD-DETR [18], 그리고 UniVTG [16].

**Moment-DETR [13]**은 VMR을 위한 Transformer encoder-decoder 모델이다. 이 모델은 검색을 집합 예측(set prediction) task로 취급하며, 비디오 및 쿼리 표현을 처리하여 관련 비디오 모먼트 좌표와 saliency 점수를 예측한다. 이 모델은 인간의 사전 지식 없이 작동하며, ASR 캡션을 사용한 약한 지도 학습(weakly supervised pretraining)으로 강화되어 관련 비디오 하이라이트를 식별하는 데 있어 전통적인 방법들을 능가한다.

**QD-DETR [18]**은 Moment-DETR를 확장하여 cross-attention layer를 사용하여 텍스트 쿼리 문맥을 비디오 표현에 통합하고, 정확한 매칭을 위해 부정적인 비디오-쿼리 쌍으로 학습하여 쿼리 활용도를 향상시킨다. 또한, 특정 비디오-쿼리 쌍에 맞춰 saliency 점수를 조정하는 입력-적응형 saliency 예측기를 특징으로 한다. 이 접근 방식은 적응형 saliency 및 명시적인 쿼리 통합 메커니즘이 부족한 Moment-DETR에 비해 더 쿼리 반응적인 솔루션을 제공한다.

**UniVTG [16]**는 모먼트 검색을 포함한 다양한 Video Temporal Grounding (VTG) task를 처리하도록 설계된 통합 프레임워크이다. 이 모델은 광범위한 VTG task와 레이블을 응집력 있는 공식으로 재검토하고 표준화한다. 이러한 표준화는 정제된 데이터 주석 접근 방식을 통해 확장 가능한 pseudo-supervision 생성을 용이하게 한다. UniVTG는 다양한 VTG [16] task에서 잘 수행될 뿐만 아니라, 모먼트 검색과 같은 task-specific 기능을 향상시키는 다재다능한 grounding 모델을 사용한다.

5 Experiments and Results

5.1 Implementation Details and Metrics

Chapter-based retrieval task를 위해 우리는 ImageBind [7], LanguageBind [29], 그리고 Sentence-BERT [20]를 사용하여 실험을 진행했다. ImageBind의 경우, 공식적으로 공개된 huge variant 모델을 활용했다. LanguageBind의 경우, 각 modality의 representation은 공개된 모델의 fully fine-tuned 버전인 video, audio, text encoder를 사용하여 추출했다. 텍스트 modality의 경우, 768차원 12개 layer를 가진 OpenCLIP의 text encoder가 사용되었다. Sentence-BERT를 사용하여 실험할 때는 HuggingFace에서 사전학습된 모델을 사용했다. 특히, 문장/단락을 768차원 벡터 공간으로 투영하는 DistilBert TAS-B variant를 사용했다.

Finer boundary segmentation을 위해서는 **사전학습된 가중치를 가진 모델의 공식 구현(QD-DETR [18], Moment-DETR [13])**을 사용했다. 우리는 256GB RAM이 장착된 서버에서 단일 Nvidia A6000 GPU를 사용하여 segmentation을 수행했다.

Classification-based retrieval을 위해서는 동일한 서버 구성을 사용했지만, GPU는 사용하지 않았다. Chapter classification VMR의 경우, Average Intersection over Union (IoU), Average Precision, Average Recall을 보고한다. 여기서 IoU는 True Positive (TP)를 True Positive (TP), False Negative (FN), False Positive (FP)의 합으로 나눈 비율로 정의된다. Recall과 Precision은 표준 정의를 사용한다. Segmentation-based VMR의 경우, [13]에 따라 Recall@1과 다양한 IoU 임계값에서의 mAP를 사용한다.

5.2 Results and Observations

Chapter Classification VMR 방법의 성능: Table 4는 다양한 modality 조합을 활용하여 chapter classification VMR task에 적용된 방법들의 결과를 요약한다. Random Baseline 방법은 모든 metric에서 가장 낮은 성능을 보였다. ImageBind [7] 및 LanguageBind [29] 모델을 활용한 방법들은 비디오 단독 사용 시 유사한 성능을 보였으며, 둘 다 평균 precision과 recall이 각각 약 47%와 44.7%를 달성했다. 이러한 방법들이 시각적 caption을 제공하는 **mPLUG-Owl [25]**과 결합되었을 때, 특히 LanguageBind [29]와 mPLUG-Owl [25]의 조합에서 성능 metric이 눈에 띄게 향상되었다.

| Input Representation | Avg IoU | Avg Precision | Avg Recall | ||||

|---|---|---|---|---|---|---|---|

| I-Bind | L-Bind | I-Bind | L-Bind | I-Bind | L-Bind | ||

| Mean Score | Subtitles | 34.9 | 33.1 | 46.4 | 43.7 | 43.2 | 42.1 |

| Visual Captions | 29.1 | 29.7 | 39.2 | 39.6 | 37.7 | 38.2 | |

| Subtitles + Visual Captions | 37.8 | 34.9 | 46.4 | 45.0 | 49.1 | 45.4 | |

| Mean Pool | Subtitles | 34.9 | 33.1 | 46.4 | 43.7 | 43.2 | 42.1 |

| Visual Captions | 29.1 | 29.7 | 39.2 | 39.6 | 37.7 | 38.2 | |

| Subtitles + Visual Captions | 37.8 | 34.9 | 46.4 | 45.0 | 49.1 | 45.4 | |

| Max Score | Subtitles | 39.8 | 37.3 | 49.1 | 46.0 | 50.3 | 48.7 |

| Visual Captions | 29.4 | 29.4 | 39.7 | 39.3 | 38.0 | 38.0 | |

| Subtitles + Visual Captions | 41.4 | 41.4 | 50.6 | 46.6 | 52.5 | 49.0 |

Table 5: LanguageBind (L-Bind) 및 ImageBind (I-Bind)에 대한 chunked text를 사용한 Chapter Classification VMR 결과. 세 가지 평가 방법(Mean Score, Mean Pool, Max Score)에 걸쳐 제시되었다.

| Method | Chapter Classification VMR | Boundary Segmentation VMR | |||||

|---|---|---|---|---|---|---|---|

| Avg Precision | Avg Recall | Avg IoU | R1@0.5 | R1@0.7 | mAP@0.5 | mAP@0.75 | |

| Moment-DETR [13] | 37.8 | 37.4 | 29.0 | 19.0 | 15.0 | 6.0 | 3.3 |

| QD-DETR [18] | 37.0 | 36.3 | 27.6 | 24.0 | 21.0 | 8.0 | 3.7 |

| UniVTG [16] | 40.4 | 38.9 | 30.1 | 26.8 | 23.3 | 11.7 | 5.3 |

Table 6: Chapter Classification 기반 VMR 및 Segmentation 기반 VMR task에서 Moment-DETR, QD-DETR, UniVTG의 비교 성능. Metric에는 chapter classification을 위한 Average Precision, Recall, Intersection over Union (IoU)과 boundary segmentation을 위한 R1@0.5, R1@0.7, mAP@0.5, mAP@0.75가 포함된다.

시각적 caption의 포함은 중요한 contextual anchor를 제공하여, 모델이 비디오 내에서 관련 chapter를 더 정확하게 사용하는 능력을 향상시키는 것으로 보인다. 텍스트와 이미지 이해 모듈 간의 이러한 융합은 검색 성능을 향상시키며, 복잡한 VMR task에서 멀티모달 접근 방식의 잠재력을 보여준다. 그러나 가장 효과적인 방법은 Sentence-BERT와 mPLUG-Owl [25]의 통합이었으며, 이는 성능을 크게 향상시켜 **가장 높은 평균 IoU, precision, recall 비율(각각 43.5%, 53.7%, 53.3%)**을 달성했다.

Chapter Classification VMR을 위한 Chunked Text 방법의 성능: Table 5는 chapter classification VMR task에서 LanguageBind (L-Bind) [29]와 ImageBind (I-Bind) [7]의 성능을 비교하며, 자막, 시각적 caption 또는 둘 다를 사용한다. 세 가지 실험(Mean Score, Mean Pool, Max Score)에 걸쳐, 자막과 시각적 caption의 조합이 두 프레임워크 모두에서 가장 높은 성능을 보였으며, ImageBind [7]가 LanguageBind [29]보다 약간 더 나은 성능을 보였다. 특히 시각적 caption의 추가는 자막의 텍스트 기반 입력을 보완하는 강력한 contextual data layer를 제공하여, 비디오 chapter의 식별 및 검색을 향상시키는 것으로 보인다. Max Score 실험은 특히 자막과 시각적 caption을 모두 사용할 때 가장 좋은 결과를 보여준다.

Segmentation VMR 방법의 성능: Table 6에 제시된 분류 기반 및 segmentation 기반 검색을 위한 segmentation 방법들의 비교 분석은 UniVTG가 두 task 모두에서 일관되게 가장 높은 성능을 달성함을 나타낸다. UniVTG는 precision, recall, IoU 점수에서 선두를 달리며, 특히 더 엄격한 IoU 임계값에서 더 높은 mAP 및 recall metric으로 Boundary Segmentation task에서 탁월한 성능을 보인다. 이러한 우수한 성능은 모델이 복잡한 비디오 segment를 미세하게 분석하고 해석하여, 쿼리의 미묘한 요구 사항에 맞춰 응답하는 능력에 기인한다. Moment-DETR와 QD-DETR는 유사한 성능을 보이지만, QD-DETR는 Boundary Segmentation에서 Moment-DETR를 약간 능가하지만 Chapter Classification에서는 평균 precision과 recall에서 뒤처진다.

6 Ethics Statement

우리의 데이터셋 큐레이션은 GPT-4에 의존하는데, 이는 GPT-4의 사전학습 데이터로부터 편향을 도입하여 질문 생성 및 인간의 기대치와의 정렬에 영향을 미칠 수 있다. 이러한 편향은 고정관념이나 잘못된 표현을 전파할 수 있다. 우리는 연구 목표와의 정렬을 보장하기 위해 출력을 비판적으로 평가했지만, 이러한 위험을 완전히 이해하고 완화하기 위해서는 추가적인 연구가 필요하다.

7 Conclusion

우리는 YouTube 비디오 챕터를 활용하여 multi-moment 사용자 쿼리를 생성하는 ChapVidMR 데이터셋을 소개했다. 이 데이터셋은 여러 챕터 이름과 YouTube API에서 추출한 메타데이터를 기반으로 한 쿼리로 구성되었다. 우리는 두 가지 주요 VMR task를 탐구했다: **챕터 분류 기반(chapter classification-based)**과 세그멘테이션 기반(segmentation-based). 챕터 분류 task의 경우, 멀티모달 feature를 사용하여 쿼리를 관련 챕터에 매핑했다. 반대로, 세그멘테이션 기반 VMR task는 비디오를 세그먼트로 분할한 다음 가장 관련성 높은 세그먼트를 찾는 것을 포함했다. 전반적으로, 이 데이터셋과 방법론은 챕터를 구조화된 비디오 세그먼트로 사용하여 비디오 모먼트 검색(video moment retrieval)을 위한 baseline 솔루션을 구축했다.

감사의 글 (Acknowledgment): 본 연구는 Microsoft Academic Partnership Grant (MAPG) 2023의 지원을 받았다. Yogesh Kumar는 인도 정부의 UGC fellowship 지원을 받았다.