GPT-2: Language Models are Unsupervised Multitask Learners

GPT-2는 대규모의 다양한 웹페이지 데이터셋인 WebText로 학습될 때, 별도의 명시적인 지도 학습 없이도 질의응답, 기계 번역, 요약과 같은 다양한 자연어 처리(NLP) 작업을 수행할 수 있음을 보여주는 1.5B 파라미터의 Transformer 기반 언어 모델입니다. 이 모델은 zero-shot 설정, 즉 특정 작업을 위한 미세 조정(fine-tuning) 없이도 여러 NLP 벤치마크에서 기존 최고 성능을 달성했으며, 이는 대용량 언어 모델이 자연적으로 발생하는 텍스트 데이터로부터 암시적으로 여러 작업을 학습할 수 있는 잠재력을 시사합니다. 논문 제목: Language Models are Unsupervised Multitask Learners

논문 요약: GPT-2: Language Models are Unsupervised Multitask Learners

- 논문 링크: OpenAI Blog (2019)

- 저자: Alec Radford, Jeffrey Wu, Rewon Child, David Luan, Dario Amodei, Ilya Sutskever 외 OpenAI 연구진

- 발표 시기: 2019년, OpenAI Blog

- 주요 키워드: Language Model, Zero-shot Learning, NLP, Transformer, Unsupervised Learning, Multitask Learning

1. 연구 배경 및 문제 정의

- 문제 정의:

기존 자연어 처리(NLP) 시스템은 특정 태스크에 대한 대규모 지도 학습 데이터셋으로 훈련되어 "협소한 전문가"에 불과하며, 데이터 분포나 태스크 명세의 미세한 변화에 취약하다. 각 태스크마다 수동으로 학습 데이터를 생성하고 레이블링할 필요 없이 다양한 태스크를 수행할 수 있는 "더 일반적인 시스템"을 구축하는 것이 목표이다. 기존 멀티태스크 학습 접근 방식은 여전히 명시적인 (데이터셋, 목적) 쌍이 필요하며, 이를 확장하는 데 한계가 있다. - 기존 접근 방식:

대부분의 NLP 태스크는 태스크별 데이터셋에 대한 지도 학습(supervised learning)으로 접근했다. 최근에는 사전 학습(pre-training)과 지도 미세 조정(supervised fine-tuning)의 조합이 널리 사용되었으나, 여전히 태스크 수행을 위해 지도 학습이 필수적이었다. 일부 연구에서는 언어 모델이 특정 태스크를 수행할 가능성을 보여주었지만, 이는 제한적이거나 명시적인 지도 없이 학습하기 어려웠다.

2. 주요 기여 및 제안 방법

- 논문의 주요 기여:

- 대규모의 다양한 웹 데이터셋(WebText)으로 학습된 언어 모델이 명시적인 지도 학습이나 아키텍처 수정 없이도 다양한 NLP 태스크를 "zero-shot" 설정에서 수행할 수 있음을 입증했다.

- 모델 용량(capacity) 증가가 태스크 전반에 걸쳐 zero-shot 성능 향상에 필수적임을 보여주었다.

- 새로운 고품질의 대규모 웹 스크랩 데이터셋인 WebText를 구축하여 언어 모델 학습에 활용했다.

- 테스트된 8개 언어 모델링 데이터셋 중 7개에서 zero-shot으로 기존 최고 성능(state-of-the-art)을 달성했다.

- 제안 방법:

논문은 언어 모델링을 비지도 멀티태스크 학습의 핵심으로 제안한다. 즉, 를 모델링하기 위해 태스크, 입력, 출력을 모두 심볼 시퀀스로 표현하여 언어 모델이 이를 예측하도록 학습한다.- 모델 아키텍처: OpenAI GPT 모델의 Transformer 기반 아키텍처를 따르며, 몇 가지 수정 사항이 있다.

- Layer normalization을 각 하위 블록의 입력으로 이동 (pre-activation residual network와 유사).

- 최종 self-attention 블록 뒤에 추가 layer normalization 추가.

- residual layer의 가중치를 (N은 residual layer 수) 계수로 스케일링하는 수정된 초기화 방식 사용.

- 어휘(vocabulary) 크기를 50,257개로 확장.

- 컨텍스트 크기를 512에서 1024 토큰으로 증가.

- 더 큰 배치 크기(512) 사용.

- 1.5B 파라미터의 GPT-2를 포함하여 4가지 모델 크기(117M, 345M, 762M, 1542M)를 학습 및 벤치마크.

- 학습 데이터셋: Reddit에서 최소 3 karma를 받은 외부 링크를 스크랩하여 구축한 40GB 규모의 고품질 텍스트 데이터셋인 WebText를 사용했다. 데이터셋에서 위키피디아 문서는 제거되었다.

- 입력 표현: 바이트 페어 인코딩(BPE)을 바이트 시퀀스에 직접 적용하여 모든 유니코드 문자열을 모델링할 수 있도록 했다. 이는 문자 레벨과 단어 레벨 언어 모델링의 장점을 결합하며, 전처리나 토큰화 아티팩트 없이 평가가 가능하다.

- 모델 아키텍처: OpenAI GPT 모델의 Transformer 기반 아키텍처를 따르며, 몇 가지 수정 사항이 있다.

3. 실험 결과

- 데이터셋:

- 학습: WebText (40GB, 800만 개 이상 문서)

- 평가 (언어 모델링): LAMBADA, Children's Book Test (CBT-CN, CBT-NE), WikiText2, Penn Treebank (PTB), enwik8, text8, WikiText103, One Billion Word Benchmark (1BW).

- 평가 (태스크): Conversation Question Answering (CoQA), CNN/Daily Mail (요약), WMT-14 (번역), Natural Questions (질의응답), Winograd Schema Challenge (상식 추론).

- 주요 결과:

- 언어 모델링: zero-shot 설정에서 8개 데이터셋 중 7개에서 SOTA 성능 달성 (예: PTB, WikiText-2, LAMBADA, CBT에서 큰 폭 개선). 1BW에서는 여전히 낮은 성능을 보였는데, 이는 데이터셋의 파괴적인 전처리 때문으로 분석된다.

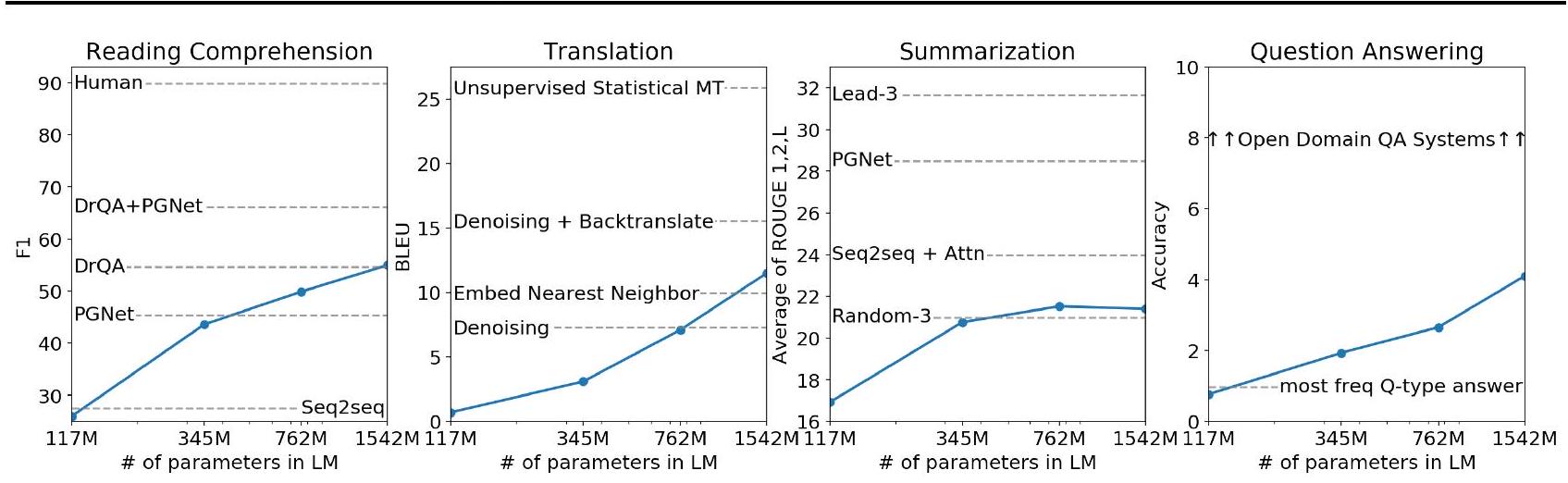

- 독해 (CoQA): zero-shot 설정에서 55 F1 점수를 달성하여, 127,000개 이상의 학습 예시를 사용한 4개 baseline 시스템 중 3개의 성능과 같거나 능가했다.

- 요약 (CNN/Daily Mail): "TL; DR:" 힌트를 주었을 때 요약과 유사한 텍스트를 생성했으나, ROUGE 지표에서는 기존 신경망 baseline보다 낮고 임의의 3개 문장을 선택하는 것보다 약간 나은 수준이었다.

- 번역 (WMT-14): 영어-프랑스어 5 BLEU, 프랑스어-영어 11.5 BLEU를 기록했다. WebText에 비영어 데이터가 거의 없음에도 불구하고 일부 비지도 기계 번역 baseline을 능가하는 놀라운 성능을 보였다.

- 질의응답 (Natural Questions): 질문의 4.1%에 대해 정답을 맞혔으며, 모델의 확신도가 높은 질문에서는 63.1%의 정확도를 보였다. 그러나 SOTA 개방형 질의응답 시스템에는 크게 못 미쳤다.

- 상식 추론 (Winograd Schema Challenge): SOTA 정확도를 7% 향상시켜 70.70%를 달성했다.

- 일반화 vs. 암기: WebText 학습 데이터와 평가 데이터셋 간의 8-gram 중복률은 평균 3.2%로 작았으며, 대부분의 데이터셋은 자체 학습/테스트 분할 간에 더 큰 중복을 보였다. GPT-2는 WebText에 대해 여전히 underfit 상태임을 시사했다.

4. 개인적인 생각 및 응용 가능성

- 장점:

- 대규모 비지도 사전 학습만으로도 다양한 NLP 태스크에서 놀라운 zero-shot 성능을 보여주며, "일반적인 AI"의 가능성을 제시했다.

- 모델 용량과 데이터 다양성/품질의 중요성을 강력하게 입증했다.

- 자연어 프롬프트("TL; DR:")를 통해 태스크별 동작을 유도할 수 있다는 점이 인상 깊다.

- 레이블링된 데이터가 부족한 저자원 언어나 특정 도메인에서 유용하게 활용될 수 있는 잠재력을 보여주었다.

- 단점/한계:

- zero-shot 성능이 인상적임에도 불구하고, 실제 응용을 위한 SOTA 지도 학습 모델에는 여전히 미치지 못하는 경우가 많다 (특히 요약, 번역 등).

- WebText에 대해 여전히 underfit 상태라는 점은 더 큰 모델이나 더 많은 데이터가 필요할 수 있음을 시사한다.

- 데이터 중복이 성능에 미치는 영향에 대한 더 심층적인 분석과 더 나은 중복 제거 기술의 필요성이 제기되었다.

- 단방향 언어 모델(GPT-2)이 양방향 표현을 사용하는 BERT와 같은 모델의 효율성을 극복할 수 있을지는 미지수이다.

- 응용 가능성:

- 다양한 NLP 태스크를 위한 강력한 기반 모델(Foundation Model)로 활용되어, 태스크별 데이터 수집 및 레이블링 비용을 크게 절감할 수 있다.

- 더욱 일관성 있고 유창하며 맥락에 맞는 텍스트 생성 능력으로 챗봇, 콘텐츠 생성, 스토리텔링 등 다양한 생성형 AI 애플리케이션에 적용될 수 있다.

- zero-shot 학습 능력은 새로운 태스크나 도메인에 대한 빠른 적응을 가능하게 하여, AI 시스템의 유연성과 확장성을 높일 수 있다.

Radford, Alec, et al. "Language models are unsupervised multitask learners." OpenAI blog 1.8 (2019): 9.

Language Models are Unsupervised Multitask Learners

Alec Radford * 1 Jeffrey Wu * 1 Rewon Child David Luan Dario Amodei ** 1 Ilya Sutskever ** 1

Abstract

질문 응답, 기계 번역, 독해, 요약과 같은 자연어 처리 task는 일반적으로 task-specific 데이터셋에 대한 supervised learning으로 접근한다. 우리는 WebText라는 수백만 개의 웹페이지로 구성된 새로운 데이터셋으로 학습했을 때, 언어 모델이 명시적인 supervision 없이도 이러한 task들을 학습하기 시작함을 보여준다.

문서와 질문이 주어졌을 때, 언어 모델이 생성한 답변은 CoQA 데이터셋에서 55 F1 점수를 달성했으며, 이는 127,000개 이상의 학습 예시를 사용하지 않고도 4개의 baseline 시스템 중 3개의 성능과 일치하거나 능가하는 수준이다.

언어 모델의 용량(capacity)은 zero-shot task transfer의 성공에 필수적이며, 용량을 증가시키면 task 전반에 걸쳐 log-linear 방식으로 성능이 향상된다.

우리의 가장 큰 모델인 GPT-2는 1.5B 파라미터 Transformer로, zero-shot 설정에서 테스트된 8개 언어 모델링 데이터셋 중 7개에서 state-of-the-art 결과를 달성했지만, 여전히 WebText에 underfit되어 있다. 모델에서 생성된 샘플들은 이러한 개선 사항을 반영하며 일관성 있는 텍스트 단락을 포함한다.

이러한 발견은 자연적으로 발생하는 시연(demonstration)으로부터 task를 학습하는 언어 처리 시스템을 구축하는 유망한 방향을 제시한다.

1. Introduction

머신러닝 시스템은 이제 대규모 데이터셋, 고용량 모델, 그리고 supervised learning의 조합을 사용하여 학습된 task에서 (기대치만큼) 뛰어난 성능을 보인다 (Krizhevsky et al., 2012) (Sutskever et al., 2014) (Amodei et al., 2016). 그러나 이러한 시스템은 데이터 분포의 미세한 변화 (Recht et al., 2018) 및 task 명세 (Kirkpatrick et al., 2017)에 취약하고 민감하다. 현재 시스템은 유능한 제너럴리스트라기보다는 협소한 전문가로 더 잘 특징지어진다. 우리는 궁극적으로 각 task마다 수동으로 학습 데이터셋을 생성하고 레이블링할 필요 없이 다양한 task를 수행할 수 있는 더 일반적인 시스템으로 나아가고자 한다.

ML 시스템을 구축하는 지배적인 접근 방식은 다음과 같다:

- 원하는 task에 대한 올바른 동작을 보여주는 학습 예시 데이터셋을 수집한다.

- 이러한 동작을 모방하도록 시스템을 학습시킨다.

- 독립적이고 동일하게 분포된(IID) held-out 예시에 대해 성능을 테스트한다.

이러한 방식은 협소한 전문가를 만드는 데는 잘 작동했다. 그러나 captioning 모델 (Lake et al., 2017), 독해 시스템 (Jia & Liang, 2017), 이미지 분류기 (Alcorn et al., 2018)가 다양한 입력에 대해 종종 불규칙한 동작을 보이는 것은 이러한 접근 방식의 몇 가지 단점을 부각시킨다.

우리의 의심은 단일 도메인 데이터셋에 대한 단일 task 학습의 보편성이 현재 시스템에서 관찰되는 일반화 능력 부족의 주요 원인이라는 것이다. 현재 아키텍처로 강건한 시스템을 향한 진전은 광범위한 도메인과 task에 대한 학습 및 성능 측정을 요구할 가능성이 높다. 최근에는 이를 연구하기 위해 GLUE (Wang et al., 2018) 및 decaNLP (McCann et al., 2018)와 같은 여러 벤치마크가 제안되었다.

Multitask learning (Caruana, 1997)은 일반적인 성능을 향상시키는 유망한 프레임워크이다. 그러나 NLP에서의 multitask training은 아직 초기 단계이다. 최근 연구들은 미미한 성능 향상을 보고하며 (Yogatama et al., 2019), 현재까지 가장 야심 찬 두 가지 노력은 각각 총 10개와 17개의 (데이터셋, 목적) 쌍으로 학습되었다 (McCann et al., 2018) (Bowman et al., 2018). 메타 학습 관점에서 각 (데이터셋, 목적) 쌍은 데이터셋 및 목적 분포에서 샘플링된 단일 학습 예시이다. 현재 ML 시스템은 잘 일반화되는 함수를 유도하기 위해 수백에서 수천 개의 예시가 필요하다. 이는 multitask training이 현재 접근 방식으로 그 약속을 실현하기 위해 동일한 수의 효과적인 학습 쌍이 필요할 수 있음을 시사한다. 현재 기술로 무작정(brute force) 목표에 도달하기 위해 필요한 정도로 데이터셋 생성 및 목적 설계를 계속 확장하는 것은 매우 어려울 것이다. 이는 multitask learning을 수행하기 위한 추가적인 설정을 탐색하도록 동기를 부여한다.

현재 언어 task에서 가장 좋은 성능을 보이는 시스템은

Figure 1. 많은 NLP task에서 모델 크기의 함수로서 WebText LM의 zero-shot task 성능. Reading Comprehension 결과는 CoQA (Reddy et al., 2018)에 대한 것이고, translation은 WMT-14 Fr-En (Artetxe et al., 2017)에 대한 것이며, summarization은 CNN 및 Daily Mail (See et al., 2017)에 대한 것이고, Question Answering은 Natural Questions (Kwiatkowski et al., 2019)에 대한 것이다. Section 3에는 각 결과에 대한 자세한 설명이 포함되어 있다.

사전 학습(pre-training)과 supervised finetuning의 조합을 활용한다. 이 접근 방식은 **더 유연한 형태의 전이(transfer)**를 향한 오랜 역사를 가지고 있다. 첫째, 단어 벡터가 학습되어 task-specific 아키텍처의 입력으로 사용되었고 (Mikolov et al., 2013) (Collobert et al., 2011), 그 다음에는 순환 네트워크의 문맥적 표현이 전이되었으며 (Dai & Le, 2015) (Peters et al., 2018), 최근 연구에서는 task-specific 아키텍처가 더 이상 필요하지 않고 많은 self-attention 블록을 전이하는 것으로 충분하다고 제안한다 (Radford et al., 2018) (Devlin et al., 2018).

이러한 방법들은 task를 수행하기 위해 여전히 supervised training을 필요로 한다. 최소한의 supervised 데이터만 있거나 전혀 없는 경우, 또 다른 연구 분야에서는 language model이 특정 task를 수행할 수 있는 가능성을 보여주었다. 예를 들어, 상식 추론(commonsense reasoning) (Schwartz et al., 2017) 및 감성 분석(sentiment analysis) (Radford et al., 2017)과 같은 task가 있다. 본 논문에서는 이 두 가지 연구 분야를 연결하고 더 일반적인 전이 방법의 추세를 이어간다. 우리는 language model이 zero-shot 설정에서, 즉 어떠한 파라미터나 아키텍처 수정 없이도, 다운스트림 task를 수행할 수 있음을 보여준다. 우리는 이 접근 방식이 language model이 zero-shot 설정에서 광범위한 task를 수행할 수 있는 능력을 강조함으로써 잠재력을 보여준다는 것을 입증한다. 우리는 task에 따라 유망하고, 경쟁력 있으며, state of the art 결과를 달성한다.

2. Approach

우리 접근 방식의 핵심은 language modeling이다. Language modeling은 일반적으로 일련의 예시들()로부터 비지도 분포 추정(unsupervised distribution estimation)으로 구성되며, 각 예시는 가변 길이의 심볼 시퀀스()로 이루어져 있다. 언어는 자연스러운 순차적 순서를 가지므로, 심볼들의 결합 확률(joint probabilities)을 조건부 확률의 곱으로 분해하는 것이 일반적이다 (Jelinek & Mercer, 1980; Bengio et al., 2003):

이러한 접근 방식은 뿐만 아니라 형태의 모든 조건부 확률에 대한 추정 및 샘플링을 다루기 쉽게(tractable) 만든다. 최근 몇 년 동안, Transformer (Vaswani et al., 2017)와 같은 self-attention 아키텍처를 통해 이러한 조건부 확률을 계산할 수 있는 모델의 표현력(expressiveness)이 크게 향상되었다.

단일 task를 수행하는 학습은 확률론적 프레임워크 내에서 조건부 분포 를 추정하는 것으로 표현될 수 있다. 일반적인 시스템은 동일한 입력에 대해서도 여러 다른 task를 수행할 수 있어야 하므로, 입력뿐만 아니라 수행할 task에도 조건을 부여해야 한다. 즉, 를 모델링해야 한다. 이는 multitask 및 meta-learning 설정에서 다양하게 공식화되어 왔다. Task conditioning은 종종 Kaiser et al. (2017)의 task-specific encoder 및 decoder와 같이 아키텍처 수준에서 구현되거나, MAML (Finn et al., 2017)의 inner 및 outer loop optimization 프레임워크와 같이 알고리즘 수준에서 구현된다. 그러나 McCann et al. (2018)에서 예시된 바와 같이, 언어는 task, 입력, 출력을 모두 심볼 시퀀스로 지정하는 유연한 방법을 제공한다. 예를 들어, 번역 학습 예시는 (translate to french, english text, french text)와 같은 시퀀스로 작성될 수 있다. 마찬가지로, 독해 학습 예시는 (answer the question, document, question, answer)로 작성될 수 있다. McCann et al. (2018)은 MQAN이라는 단일 모델을 훈련하여 이러한 형식의 예시에서 다양한 task를 추론하고 수행하는 것이 가능함을 입증했다.

Language modeling은 원칙적으로 예측될 출력이 어떤 심볼인지에 대한 명시적인 지도(explicit supervision) 없이도 McCann et al. (2018)의 task들을 학습할 수 있다. 지도 학습 objective는 비지도 학습 objective와 동일하지만, 시퀀스의 부분집합에 대해서만 평가되므로, 비지도 학습 objective의 전역 최솟값은 지도 학습 objective의 전역 최솟값과 동일하다. 이 다소 장난감 같은(toy) 설정에서는 (Sutskever et al., 2015)에서 논의된 밀도 추정(density estimation)의 원칙적인 학습 objective에 대한 우려가 회피된다. 대신 문제는 실제로 비지도 학습 objective를 수렴하도록 최적화할 수 있는지 여부가 된다. 예비 실험을 통해 충분히 큰 language model이 이러한 toy-ish 설정에서 multitask learning을 수행할 수 있지만, 명시적으로 지도된 접근 방식보다 학습 속도가 훨씬 느리다는 것이 확인되었다.

위에서 설명한 잘 정의된(well-posed) 설정에서 "야생의 언어(language in the wild)"의 복잡성으로 나아가는 것은 큰 진전이지만, Weston (2016)은 대화(dialog)의 맥락에서 자연어로부터 직접 학습할 수 있는 시스템을 개발할 필요성을 주장하며 개념 증명(proof of concept)을 제시했다. 이는 교사의 출력을 순방향 예측(forward prediction)함으로써 보상 신호 없이 QA task를 학습하는 방식이었다. 대화는 매력적인 접근 방식이지만, 우리는 그것이 지나치게 제한적이라고 우려한다. 인터넷에는 상호작용적인 통신 없이도 수동적으로 이용 가능한 방대한 양의 정보가 있다. 우리의 추측은 충분한 용량을 가진 language model이 자연어 시퀀스에 나타난 task들을 더 잘 예측하기 위해, 그 획득 방법에 관계없이, 추론하고 수행하는 방법을 학습하기 시작할 것이라는 것이다. 만약 language model이 이를 수행할 수 있다면, 이는 사실상 비지도 multitask learning을 수행하는 것이 된다. 우리는 다양한 task에 대한 language model의 zero-shot 성능을 분석함으로써 이것이 사실인지 여부를 테스트한다.

2.1. Training Dataset

대부분의 기존 연구는 뉴스 기사(Jozefowicz et al., 2016), 위키피디아(Merity et al., 2016), 또는 소설책(Kiros et al., 2015)과 같이 단일 도메인의 텍스트로 언어 모델을 학습시켰다. 우리의 접근 방식은 가능한 한 다양한 도메인과 맥락에서 자연어 task 시연(demonstration)을 수집하기 위해 가능한 한 크고 다양한 데이터셋을 구축하는 것을 목표로 한다.

다양하고 거의 무제한적인 텍스트의 유망한 출처는 Common Crawl과 같은 웹 스크랩 데이터이다. 이러한 아카이브는 현재 언어 모델링 데이터셋보다 수십 배 더 크지만, 데이터 품질 문제가 심각하다. Trinh & Le (2018)는 상식 추론 연구에서 Common Crawl을 사용했지만, "내용이 대부분 이해하기 어려운" 문서가 많다고 언급했다. 우리는 초기 실험에서 Common Crawl을 사용했을 때도 유사한 데이터 문제를 관찰했다.

"I'm not the cleverest man in the world, but like they say in French: Je ne suis pas un imbecile [I'm not a fool].

In a now-deleted post from Aug. 16, Soheil Eid, Tory candidate in the riding of Joliette, wrote in French: "Mentez mentez, il en restera toujours quelque chose," which translates as, "Lie lie and something will always remain." "I hate the word 'perfume,"' Burr says. 'It's somewhat better in French: 'parfum.'

If listened carefully at , a conversation can be heard between two guys in French: "-Comment on fait pour aller de l'autre coté? -Quel autre coté?", which means "- How do you get to the other side? - What side?".

If this sounds like a bit of a stretch, consider this question in French: As-tu aller au cinéma?, or Did you go to the movies?, which literally translates as Have-you to go to movies/theater? "Brevet Sans Garantie Du Gouvernement", translated to English: "Patented without government warranty".

Table 1. WebText 학습 세트 전반에서 발견된 영어-프랑스어 및 프랑스어-영어 번역의 자연 발생적 시연 예시.

Trinh & Le (2018)의 최고 결과는 Common Crawl의 작은 하위 샘플을 사용하여 달성되었는데, 이 샘플에는 대상 데이터셋인 Winograd Schema Challenge와 가장 유사한 문서만 포함되어 있었다. 이는 특정 task에서 성능을 향상시키기 위한 실용적인 접근 방식이지만, 우리는 수행할 task에 대한 가정을 미리 설정하는 것을 피하고자 한다.

대신, 우리는 문서 품질을 강조하는 새로운 웹 스크랩 데이터셋을 만들었다. 이를 위해 우리는 사람이 직접 큐레이션/필터링한 웹 페이지만 스크랩했다. 전체 웹 스크랩을 수동으로 필터링하는 것은 엄청나게 비쌀 것이므로, 시작점으로 소셜 미디어 플랫폼인 Reddit에서 최소 3 karma를 받은 모든 외부 링크를 스크랩했다. 이는 다른 사용자들이 해당 링크를 흥미롭거나, 교육적이거나, 단순히 재미있다고 생각했는지에 대한 휴리스틱 지표로 볼 수 있다.

그 결과로 생성된 데이터셋인 WebText는 이 4,500만 개의 링크 중 텍스트 하위 집합을 포함한다. HTML 응답에서 텍스트를 추출하기 위해 우리는 Dragnet (Peters & Lecocq, 2013)과 Newspaper 콘텐츠 추출기를 조합하여 사용한다. 본 논문에서 제시된 모든 결과는 2017년 12월 이후 생성된 링크를 포함하지 않으며, 중복 제거 및 일부 휴리스틱 기반 클리닝 후 총 40GB의 텍스트에 해당하는 800만 개 이상의 문서를 포함하는 WebText의 예비 버전을 사용한다. 우리는 WebText에서 모든 위키피디아 문서를 제거했는데, 이는 위키피디아는 다른 데이터셋의 일반적인 데이터 소스이며 테스트 평가 task와의 훈련 데이터 중복으로 인해 분석을 복잡하게 만들 수 있기 때문이다.

2.2. Input Representation

일반적인 Language Model(LM)은 모든 문자열의 확률을 계산(및 생성)할 수 있어야 한다. 현재 대규모 LM들은 소문자 변환, 토큰화, out-of-vocabulary 토큰 처리와 같은 전처리 단계를 포함하며, 이는 모델링 가능한 문자열의 공간을 제한한다. Gillick et al. (2015)의 연구에서 예시된 바와 같이, UTF-8 바이트 시퀀스로 유니코드 문자열을 처리하는 방식은 이러한 요구사항을 우아하게 충족시키지만, 현재의 바이트 레벨 LM은 One Billion Word Benchmark (Al-Rfou et al., 2018)와 같은 대규모 데이터셋에서 단어 레벨 LM에 비해 경쟁력이 떨어진다. 우리는 WebText에서 표준 바이트 레벨 LM을 학습시키려는 시도에서도 유사한 성능 격차를 관찰했다.

Byte Pair Encoding (BPE) (Sennrich et al., 2015)는 문자 레벨과 단어 레벨 언어 모델링 사이의 실용적인 중간 지점으로, **자주 등장하는 심볼 시퀀스에는 단어 레벨 입력을, 드물게 등장하는 심볼 시퀀스에는 문자 레벨 입력을 효과적으로 보간(interpolate)**한다. 이름과는 달리, 참조 BPE 구현체들은 종종 바이트 시퀀스가 아닌 유니코드 코드 포인트에서 작동한다. 이러한 구현체들은 모든 유니코드 문자열을 모델링하기 위해 유니코드 심볼의 전체 공간을 포함해야 한다. 이는 어떤 다중 심볼 토큰이 추가되기 전에도 130,000개가 넘는 기본 어휘(base vocabulary)를 초래한다. 이는 BPE에서 흔히 사용되는 32,000에서 64,000개의 토큰 어휘에 비해 엄청나게 큰 규모이다. 대조적으로, 바이트 레벨 BPE는 256개의 기본 어휘만 필요하다. 그러나 바이트 시퀀스에 BPE를 직접 적용하면 BPE가 토큰 어휘를 구축하기 위해 탐욕적인 빈도 기반 휴리스틱을 사용하기 때문에 최적화되지 않은 병합(merge)이 발생한다. 우리는 BPE가 "dog", "dog!", "dog?"와 같이 다양한 형태로 나타나는 "dog"와 같은 일반적인 단어의 여러 버전을 포함하는 것을 관찰했다. 이는 제한된 어휘 슬롯과 모델 용량의 비최적적인 할당으로 이어진다. 이를 피하기 위해, 우리는 BPE가 어떤 바이트 시퀀스에서도 문자 카테고리를 넘어 병합하는 것을 방지한다. 우리는 공백(space)에 대한 예외를 추가했는데, 이는 압축 효율성을 크게 향상시키면서도 여러 어휘 토큰에 걸쳐 단어의 단편화(fragmentation)를 최소화한다.

이러한 입력 표현은 단어 레벨 LM의 경험적 이점과 바이트 레벨 접근 방식의 일반성을 결합할 수 있게 한다. 우리의 접근 방식은 모든 유니코드 문자열에 확률을 할당할 수 있기 때문에, 전처리, 토큰화, 어휘 크기에 관계없이 모든 데이터셋에서 LM을 평가할 수 있다.

2.3. Model

우리는 LM을 위해 Transformer (Vaswani et al., 2017) 기반 아키텍처를 사용한다. 이 모델은 OpenAI GPT 모델 (Radford et al., 2018)의 세부 사항을 대부분 따르며, 몇 가지 수정 사항이 있다.

| Parameters | Layers | |

|---|---|---|

| 117 M | 12 | 768 |

| 345 M | 24 | 1024 |

| 762 M | 36 | 1280 |

| 1542 M | 48 | 1600 |

Table 2. 4가지 모델 크기에 대한 아키텍처 하이퍼파라미터.

**Layer normalization (Ba et al., 2016)**은 각 하위 블록의 입력으로 이동되었으며, 이는 **pre-activation residual network (He et al., 2016)**와 유사하다. 또한 최종 self-attention 블록 뒤에 추가적인 layer normalization이 추가되었다. 모델 깊이에 따른 residual path의 누적을 고려한 수정된 초기화 방식이 사용된다. 우리는 residual layer의 가중치를 초기화 시 계수로 스케일링하는데, 여기서 은 residual layer의 수이다. 어휘(vocabulary)는 50,257개로 확장되었다. 또한 context size를 512에서 1024 토큰으로 늘렸고, 더 큰 batch size인 512가 사용된다.

3. Experiments

우리는 로그-균등 간격으로 분포된 크기를 가진 4개의 Language Model(LM)을 학습시키고 벤치마크하였다. 아키텍처는 Table 2에 요약되어 있다. 가장 작은 모델은 오리지널 GPT와 동일하며, 두 번째로 작은 모델은 BERT (Devlin et al., 2018)의 가장 큰 모델과 동일하다. 우리의 가장 큰 모델은 GPT-2라고 부르며, GPT보다 파라미터 수가 10배 이상 많다. 각 모델의 learning rate는 WebText의 5% held-out 샘플에서 최적의 perplexity를 얻기 위해 수동으로 튜닝되었다. 모든 모델은 여전히 WebText에 대해 underfit 상태이며, 학습 시간을 더 늘리면 held-out perplexity가 개선될 여지가 있다.

3.1. Language Modeling

zero-shot task transfer를 위한 초기 단계로, 우리는 WebText LM이 학습된 주요 task인 language modeling에서 zero-shot domain transfer를 어떻게 수행하는지 이해하는 데 관심을 가졌다. 우리 모델은 바이트(byte) 수준에서 작동하며 손실이 발생하는 전처리(pre-processing)나 토큰화(tokenization)를 요구하지 않으므로, 어떤 language model 벤치마크에서도 평가할 수 있다. language modeling 데이터셋의 결과는 일반적으로 정규화된 예측 단위(canonical prediction unit), 즉 문자, 바이트 또는 단어당 평균 negative log probability의 스케일링되거나 지수화된 값으로 보고된다. 우리는 WebText LM에 따라 데이터셋의 log-probability를 계산하고 정규화된 단위의 수로 나누어 동일한 값을 평가한다. 이러한 데이터셋 중 상당수에서 WebText LM은 분포에서 크게 벗어난(out-of-distribution) 상태로 테스트될 것이며, 다음과 같은 요소들을 예측해야 한다:

- 공격적으로 표준화된 텍스트

- 분리된 구두점 및 축약어와 같은 토큰화 아티팩트

- 뒤섞인 문장

- 심지어 WebText에서는 극히 드문(400억 바이트 중 26번만 발생)

<UNK>문자열.

우리는 이러한 토큰화/전처리 아티팩트를 최대한 제거하는 가역적인(invertible) de-tokenizer를 사용하여 Table 3에 주요 결과를 보고한다. 이 de-tokenizer는 가역적이므로, 우리는 여전히 데이터셋의 log probability를 계산할 수 있으며, 이는 간단한 형태의 domain adaptation으로 볼 수 있다. 이 de-tokenizer를 사용했을 때 GPT-2의 perplexity가 2.5에서 5까지 향상되는 것을 관찰했다.

Language Models are Unsupervised Multitask Learners

| LAMBADA (PPL) | LAMBADA (ACC) | CBT-CN (ACC) | CBT-NE (ACC) | WikiText2 (PPL) | PTB (PPL) | enwik8 (BPB) | text8 (BPC) | WikiText103 (PPL) | 1BW (PPL) | |

|---|---|---|---|---|---|---|---|---|---|---|

| SOTA | 99.8 | 59.23 | 85.7 | 82.3 | 39.14 | 46.54 | 0.99 | 1.08 | 18.3 | 21.8 |

| 117 M | 35.13 | 45.99 | 87.65 | 83.4 | 29.41 | 65.85 | 1.16 | 1.17 | 37.50 | 75.20 |

| 345M | 15.60 | 55.48 | 92.35 | 87.1 | 22.76 | 47.33 | 1.01 | 1.06 | 26.37 | 55.72 |

| 762 M | 10.87 | 60.12 | 93.45 | 88.0 | 19.93 | 40.31 | 0.97 | 1.02 | 22.05 | 44.575 |

| 1542 M | 8.63 | 63.24 | 93.30 | 89.05 | 18.34 | 35.76 | 0.93 | 0.98 | 17.48 | 42.16 |

Table 3. 다양한 데이터셋에 대한 zero-shot 결과. 이 결과들을 위해 어떠한 학습이나 fine-tuning도 수행되지 않았다. PTB 및 WikiText-2 결과는 (Gong et al., 2018)에서 가져왔다. CBT 결과는 (Bajgar et al., 2016)에서 가져왔다. LAMBADA 정확도 결과는 (Hoang et al., 2018)에서, LAMBADA perplexity 결과는 (Grave et al., 2016)에서 가져왔다. 다른 결과들은 (Dai et al., 2019)에서 가져왔다.

WebText LM은 도메인과 데이터셋 전반에 걸쳐 잘 전이(transfer)되며, zero-shot 설정에서 8개 데이터셋 중 7개에서 state of the art를 향상시킨다. Penn Treebank 및 WikiText-2와 같이 100만~200만 개의 학습 토큰만 있는 작은 데이터셋에서 큰 폭의 개선이 관찰되었다. **LAMBADA (Paperno et al., 2016) 및 Children's Book Test (Hill et al., 2015)**와 같이 장기 의존성(long-term dependencies)을 측정하기 위해 생성된 데이터셋에서도 큰 폭의 개선이 나타났다. 우리 모델은 One Billion Word Benchmark (Chelba et al., 2013)에서는 여전히 기존 연구보다 현저히 낮은 성능을 보인다. 이는 해당 데이터셋이 가장 큰 데이터셋이면서 동시에 가장 파괴적인 전처리(pre-processing)를 포함하고 있기 때문일 가능성이 높다. 1BW의 문장 수준 셔플링은 모든 장거리 구조를 제거한다.

3.2. Children's Book Test

Figure 2. 모델 용량(capacity)에 따른 Children's Book Test 성능. 인간 성능은 원 논문의 훨씬 낮은 추정치 대신 Bajgar et al. (2016)의 데이터를 사용하였다.

Figure 2. 모델 용량(capacity)에 따른 Children's Book Test 성능. 인간 성능은 원 논문의 훨씬 낮은 추정치 대신 Bajgar et al. (2016)의 데이터를 사용하였다.

Children's Book Test (CBT) (Hill et al., 2015)는 named entities, nouns, verbs, prepositions 등 다양한 단어 범주에 대한 LM의 성능을 평가하기 위해 만들어졌다. CBT는 평가 지표로 perplexity 대신, 생략된 단어에 대한 10가지 선택지 중 올바른 것을 예측하는 cloze test의 정확도를 보고한다. 원 논문에서 소개된 LM 접근 방식을 따라, 우리는 각 선택지와 해당 선택지에 조건화된 나머지 문장의 확률을 LM에 따라 계산하고, 가장 높은 확률을 가진 것을 예측한다. Figure 2에서 볼 수 있듯이, 모델 크기가 증가함에 따라 성능이 꾸준히 향상되며, 이 테스트에서 인간 성능과의 격차 대부분을 좁혔다. 데이터 중복 분석 결과, CBT 테스트 세트 도서 중 하나인 Rudyard Kipling의 『정글북(The Jungle Book)』이 WebText에 포함되어 있음을 확인했으므로, 우리는 유의미한 중복이 없는 validation set에 대한 결과를 보고한다. GPT-2는 일반 명사(common nouns)에서 93.3%, **고유 명사(named entities)에서 89.1%**의 새로운 state-of-the-art 결과를 달성했다. CBT에서 PTB 스타일의 토큰화 아티팩트를 제거하기 위해 de-tokenizer가 적용되었다.

3.3. LAMBADA

LAMBADA 데이터셋 [Paperno et al., 2016]은 텍스트 내 장거리 의존성(long-range dependencies)을 모델링하는 시스템의 능력을 테스트한다. 이 task는 사람이 성공적으로 예측하기 위해 최소 50개 토큰의 문맥(context)이 필요한 문장의 마지막 단어를 예측하는 것이다.

GPT-2는 이 task에서 기존 state of the art인 99.8 (Grave et al., 2016)에서 8.6 perplexity로 성능을 향상시켰으며, LM의 정확도를 19% (Dehghani et al., 2018)에서 52.66%로 증가시켰다.

GPT-2의 오류를 분석한 결과, 대부분의 예측은 문장의 유효한 연속이었지만, 문장의 마지막 단어로는 유효하지 않았다. 이는 LM이 단어가 문장의 마지막 단어여야 한다는 추가적인 유용한 제약 조건을 활용하지 못하고 있음을 시사한다.

이러한 제약을 근사적으로 적용하기 위해 stop-word filter를 추가하자 정확도는 63.24%로 더욱 증가했으며, 이 task의 전반적인 state of the art를 4% 향상시켰다.

이전 state of the art [Hoang et al., 2018]는 모델의 출력이 문맥에 나타난 단어로만 제한되는 다른 제한된 예측 설정을 사용했다. GPT-2의 경우, 정답의 19%가 문맥에 없기 때문에 이러한 제한은 도움이 되기보다는 해로웠다. 우리는 전처리되지 않은 버전의 데이터셋을 사용한다.

3.4. Winograd Schema Challenge

Figure 3. 모델 용량에 따른 Winograd Schema Challenge 성능.

Figure 3. 모델 용량에 따른 Winograd Schema Challenge 성능.

Winograd Schema Challenge (Levesque et al., 2012)는 텍스트의 모호성을 해결하는 시스템의 능력을 측정하여 상식 추론(commonsense reasoning) 수행 능력을 평가하기 위해 고안되었다. 최근 Trinh & Le (2018)는 LM을 사용하여 모호성 해결을 더 높은 확률로 예측함으로써 이 챌린지에서 상당한 진전을 보였다. 우리는 그들의 문제 정의를 따르며, Figure 3에서 전체 및 부분 채점 기법을 모두 사용하여 우리 모델의 성능을 시각화한다. GPT-2는 state of the art 정확도를 7% 향상시켜 70.70%를 달성했다. 데이터셋은 273개의 예시로 상당히 작으므로, 이 결과를 맥락화하는 데 도움이 되도록 Trichelair et al. (2018)을 참고하는 것을 권장한다.

3.5. Reading Comprehension

Conversation Question Answering (CoQA) 데이터셋 Reddy et al. (2018)은 7가지 다른 도메인의 문서와, 해당 문서에 대한 질문자와 답변자 간의 자연어 대화로 구성되어 있다. CoQA는 독해 능력뿐만 아니라, 대화 이력에 의존하는 질문(예: "왜?")에 답하는 모델의 능력을 테스트한다.

문서, 관련 대화 이력, 그리고 최종 토큰 'A:'를 조건으로 하는 GPT-2의 greedy decoding은 개발 세트에서 55 F1을 달성한다. 이는 127,000개 이상의 수동으로 수집된 질문-답변 쌍을 학습에 사용한 4개의 baseline 시스템 중 3개의 성능과 같거나 능가하는 결과이다. supervised SOTA인 BERT 기반 시스템 (Devlin et al., 2018)은 인간의 89 F1 성능에 근접하고 있다. GPT-2의 성능은 어떠한 supervised 학습 없이도 놀랍지만, 답변과 오류를 살펴보면 GPT-2는 '누가' 질문에 대해 문서에서 이름을 찾아 답변하는 것과 같은 단순한 검색 기반 휴리스틱을 자주 사용하는 경향이 있다.

| R-1 | R-2 | R-L | R-AVG | |

|---|---|---|---|---|

| Bottom-Up Sum | ||||

| Lede-3 | 40.38 | 17.66 | 36.62 | 31.55 |

| Seq2Seq + Attn | 31.33 | 11.81 | 28.83 | 23.99 |

| GPT-2 TL; DR: | 29.34 | 8.27 | 26.58 | 21.40 |

| Random-3 | 28.78 | 8.63 | 25.52 | 20.98 |

| GPT-2 no hint | 21.58 | 4.03 | 19.47 | 15.03 |

Table 4. CNN 및 Daily Mail 데이터셋에서 ROUGE F1 지표로 측정된 요약 성능. Bottom-Up Sum은 (Gehrmann et al., 2018)의 SOTA 모델이다.

3.6. Summarization

우리는 GPT-2가 CNN 및 Daily Mail 데이터셋 (Nallapati et al., 2016)에서 요약(summarization)을 수행하는 능력을 테스트했다. 요약 동작을 유도하기 위해 기사 뒤에 "TL; DR:" 텍스트를 추가하고, Top- random sampling (Fan et al., 2018) 방식으로 를 사용하여 100개의 토큰을 생성했다. 이 방식은 반복을 줄이고 greedy decoding보다 더 추상적인 요약을 유도한다. 우리는 이 100개의 토큰 중 처음 3개의 생성된 문장을 요약으로 사용했다.

정성적으로는 생성된 요약이 요약과 유사하지만, Table 14에서 보듯이, 종종 기사의 최근 내용에 집중하거나, 사고에 연루된 차량 수 또는 로고가 모자에 있었는지 셔츠에 있었는지와 같은 특정 세부 정보를 혼동하는 경향이 있었다. 일반적으로 보고되는 ROUGE 1, 2, L 지표에서 생성된 요약은 고전적인 신경망 baseline의 성능에 겨우 근접했으며, 기사에서 임의의 3개 문장을 선택하는 것보다 약간 더 나은 성능을 보였다.

task 힌트("TL; DR:")를 제거했을 때 GPT-2의 성능은 종합 지표에서 6.4점 하락했는데, 이는 자연어를 통해 language model에서 task-specific 동작을 유도할 수 있는 능력을 보여준다.

3.7. Translation

우리는 GPT-2가 한 언어에서 다른 언어로 번역하는 방법을 학습하기 시작했는지를 테스트한다. 모델이 이 task를 수행하도록 돕기 위해, 우리는 "영어 문장 = 프랑스어 문장" 형식의 예시 쌍들을 context로 제공하여 language model을 조건화한다. 그리고 마지막으로 "영어 문장 ="이라는 prompt를 준 후, greedy decoding으로 모델로부터 문장을 샘플링하고, 처음 생성된 문장을 번역 결과로 사용한다. WMT-14 영어-프랑스어 테스트 세트에서 GPT-2는 5 BLEU를 얻었는데, 이는 이전 연구의 비지도 단어 번역에서 추론된 이중 언어 사전(bilingual lexicon)을 사용한 단어별 대체(word-by-word substitution)보다 약간 낮은 성능이다.

| Question | Generated Answer | Correct | Probability |

|---|---|---|---|

| Who wrote the book the origin of species? | Charles Darwin | 83.4% | |

| Who is the founder of the ubuntu project? | Mark Shuttleworth | 82.0% | |

| Who is the quarterback for the green bay packers? | Aaron Rodgers | 81.1% | |

| Panda is a national animal of which country? | China | 76.8% | |

| Who came up with the theory of relativity? | Albert Einstein | 76.4% | |

| When was the first star wars film released? | 1977 | 71.4% | |

| What is the most common blood type in sweden? | A | 70.6% | |

| Who is regarded as the founder of psychoanalysis? | Sigmund Freud | 69.3% | |

| Who took the first steps on the moon in 1969? | Neil Armstrong | 66.8% | |

| Who is the largest supermarket chain in the uk? | Tesco | 65.3% | |

| What is the meaning of shalom in english? | peace | 64.0% | |

| Who was the author of the art of war? | Sun Tzu | 59.6% | |

| Largest state in the us by land mass? | California | 59.2% | |

| Green algae is an example of which type of reproduction? | parthenogenesis | 56.5% | |

| Vikram samvat calender is official in which country? | India | 55.6% | |

| Who is mostly responsible for writing the declaration of independence? | Thomas Jefferson | 53.3% | |

| What us state forms the western boundary of montana? | Montana | 52.3% | |

| Who plays ser davos in game of thrones? | Peter Dinklage | 52.1% | |

| Who appoints the chair of the federal reserve system? | Janet Yellen | 51.5% | |

| State the process that divides one nucleus into two genetically identical nuclei? | mitosis | 50.7% | |

| Who won the most mvp awards in the nba? | Michael Jordan | 50.2% | |

| What river is associated with the city of rome? | the Tiber | 48.6% | |

| Who is the first president to be impeached? | Andrew Johnson | 48.3% | |

| Who is the head of the department of homeland security 2017 ? | John Kelly | 47.0% | |

| What is the name given to the common currency to the european union? | Euro | 46.8% | |

| What was the emperor name in star wars? | Palpatine | 46.5% | |

| Do you have to have a gun permit to shoot at a range? | No | 46.4% | |

| Who proposed evolution in 1859 as the basis of biological development? | Charles Darwin | 45.7% | |

| Nuclear power plant that blew up in russia? | Chernobyl | 45.7% | |

| Who played john connor in the original terminator? | Arnold Schwarzenegger | 45.2% |

Table 5. Natural Questions 개발 세트에서 GPT-2가 생성한 답변 중 가장 신뢰도가 높은 30개 답변을 GPT-2가 예측한 확률에 따라 정렬한 결과. 이 질문들 중 어떤 것도 Section 4에 설명된 절차에 따라 WebText에 나타나지 않는다.

(Conneau et al., 2017b). WMT-14 프랑스어-영어 테스트 세트에서는 GPT-2가 매우 강력한 영어 language model 능력을 활용하여 훨씬 더 나은 성능을 달성했으며, 11.5 BLEU를 기록했다. 이는 (Artetxe et al., 2017) 및 (Lample et al., 2017)의 여러 비지도 기계 번역 baseline을 능가하는 수치이지만, 현재 최고의 비지도 기계 번역 접근 방식인 (Artetxe et al., 2019)의 33.5 BLEU보다는 여전히 훨씬 낮은 성능이다. 이 task에서의 성능은 우리에게 놀라웠는데, 이는 우리가 WebText에서 비영어 웹페이지를 의도적으로 필터링하여 제거했기 때문이다. 이를 확인하기 위해 WebText에 바이트 수준 언어 감지기를 실행한 결과, 프랑스어 데이터는 약 10MB만 감지되었으며, 이는 이전 비지도 기계 번역 연구에서 흔히 사용되는 단일 언어 프랑스어 코퍼스보다 약 500배 작은 규모이다.

3.8. Question Answering

Language model에 어떤 정보가 포함되어 있는지를 테스트하는 한 가지 잠재적인 방법은 factoid-style question에 대해 정답을 생성하는 빈도를 평가하는 것이다. 모든 정보가 parameter에 저장되는 neural system에서 이러한 행동을 보여준 이전 사례로는 A Neural Conversational Model(Vinyals & Le, 2015)이 있으며, 이 연구는 고품질 평가 dataset의 부재로 인해 정성적 결과만을 보고했다. 최근 소개된 Natural Questions dataset(Kwiatkowski et al., 2019)은 이를 보다 정량적으로 테스트하기에 유망한 자원이다. Translation과 유사하게, language model의 context는 예시 question-answer pair로 초기화되며, 이를 통해 모델이 해당 dataset의 short answer 스타일을 추론하는 데 도움을 받는다. GPT-2는 SQuAD와 같은 reading comprehension dataset에서 일반적으로 사용되는 exact match metric으로 평가했을 때, 질문의 4.1%에 대해 정답을 맞혔다.

비교 지점으로, 가장 작은 모델은 question type(who, what, where 등)에 따라 가장 흔한 답을 반환하는 매우 단순한 baseline의 1.0% 정확도를 넘지 못했다. GPT-2는 5.3배 더 많은 질문에 정답을 맞혀, 이러한 종류의 task에서 neural system의 성능이 저조했던 주요 요인이 model capacity였음을 시사한다. GPT-2가 생성한 답변에 부여하는 확률은 잘 calibration되어 있으며, GPT-2는 자신이 가장 확신하는 1%의 질문에서 63.1%의 정확도를 보였다. 개발 세트 질문에 대해 GPT-2가 가장 확신을 가진 30개의 답변은 Table 5에 제시되어 있다. 그럼에도 불구하고 GPT-2의 성능은 여전히 information retrieval과 extractive document question answering을 결합한 open-domain question answering system의 30~50% 범위 성능에 비해 훨씬 뒤처져 있다(Alberti et al., 2019).

| PTB | WikiText-2 | enwik8 | text8 | Wikitext-103 | 1BW | |

|---|---|---|---|---|---|---|

| Dataset train | ||||||

| WebText train |

Table 6. 테스트 세트의 8-gram이 training set과 겹치는 비율.

4. Generalization vs Memorization

최근 컴퓨터 비전 분야 연구에 따르면, 일반적인 이미지 데이터셋에는 상당량의 거의 중복되는(near-duplicate) 이미지가 포함되어 있다. 예를 들어, CIFAR-10은 학습 및 테스트 이미지 간에 3.3%의 중복이 존재한다 (Barz & Denzler, 2019). 이는 머신러닝 시스템의 일반화 성능이 과대 보고되는 결과로 이어진다. 데이터셋의 크기가 증가할수록 이러한 문제가 발생할 가능성이 높아지며, 이는 WebText에서도 유사한 현상이 발생할 수 있음을 시사한다. 따라서 학습 데이터에 테스트 데이터가 얼마나 포함되어 있는지 분석하는 것이 중요하다.

이를 연구하기 위해 우리는 WebText 학습 세트 토큰의 8-gram을 포함하는 Bloom filter를 생성했다. 재현율(recall)을 높이기 위해, 문자열은 소문자 영숫자 단어만 포함하고 단일 공백을 구분자로 사용하도록 정규화되었다. Bloom filter는 오탐율(false positive rate)이 이하로 상한이 설정되도록 구축되었다. 우리는 100만 개의 문자열을 생성하여 필터에서 발견된 것이 없음을 확인하여 낮은 오탐율을 추가로 검증했다.

이러한 Bloom filter를 통해 우리는 주어진 데이터셋에서 WebText 학습 세트에도 포함된 8-gram의 비율을 계산할 수 있다. Table 6은 일반적인 LM 벤치마크의 테스트 세트에 대한 이러한 중복 분석을 보여준다. 일반적인 LM 데이터셋의 테스트 세트는 WebText 학습 세트와 1-6%의 중복을 가지며, **평균 중복률은 3.2%**이다. 다소 놀랍게도, 많은 데이터셋은 자체 학습 분할(training split)과 더 큰 중복을 가지며, 평균 5.9%의 중복률을 보인다.

우리의 접근 방식은 재현율을 최적화하며, 중복에 대한 수동 검사 결과 많은 일반적인 구문이 나타나지만, 중복된 데이터로 인한 더 긴 일치(match)도 많이 존재한다. 이는 WebText에만 국한된 현상이 아니다. 예를 들어, 우리는 WikiText-103의 테스트 세트에 학습 데이터셋에도 있는 기사가 포함되어 있음을 발견했다. 테스트 세트에는 60개의 기사만 있으므로 최소 1.6%의 중복이 존재한다. 잠재적으로 더 우려되는 점은, 우리의 절차에 따르면 1 BW는 자체 학습 세트와 거의 13.2%의 중복을 가진다는 것이다.

Winograd Schema Challenge의 경우, WebText 학습 세트와 8-gram 중복이 있는 스키마는 10개에 불과했다. 이 중 2개는 잘못된 일치(spurious match)였다. 나머지 8개 중, 단 1개의 스키마만이 답을 알려주는 맥락에서 나타났다.

CoQA의 경우, 뉴스 도메인 문서의 약 15%가 이미 WebText에 포함되어 있으며, 모델은 이러한 문서에서 약 3 F1 더 나은 성능을 보인다. CoQA의 개발 세트 지표는 5가지 다른 도메인에 대한 평균 성능을 보고하며, 우리는 다양한 도메인에 걸친 중복으로 인해 약 0.5-1.0 F1의 성능 향상을 측정했다. 그러나 CoQA는 WebText 링크의 마감일 이후에 출시되었으므로 실제 학습 질문이나 답변은 WebText에 포함되어 있지 않다.

LAMBADA에서는 평균 중복률이 1.2%이다. GPT-2는 15% 이상의 중복이 있는 예시에서 약 2 perplexity 더 나은 성능을 보인다. 중복이 있는 모든 예시를 제외하고 지표를 재계산하면 결과는 8.6에서 8.7 perplexity로 바뀌고 정확도는 63.2%에서 62.9%로 감소한다. 전체 결과의 이러한 매우 작은 변화는 200개 예시 중 1개만이 상당한 중복을 가지기 때문일 가능성이 높다.

전반적으로, 우리의 분석은 WebText 학습 데이터와 특정 평가 데이터셋 간의 데이터 중복이 보고된 결과에 작지만 일관된 이점을 제공함을 시사한다. 그러나 Table 6에서 강조하듯이, 대부분의 데이터셋에서 우리는 표준 학습 및 테스트 세트 사이에 이미 존재하는 중복보다 훨씬 큰 중복을 발견하지 못했다.

높은 유사성을 가진 텍스트가 성능에 미치는 영향을 이해하고 정량화하는 것은 중요한 연구 질문이다. 확장 가능한 fuzzy matching과 같은 더 나은 중복 제거 기술도 이러한 질문에 더 잘 답하는 데 도움이 될 수 있다. 현재로서는 새로운 NLP 데이터셋의 학습 및 테스트 분할을 생성할 때 n-gram 중복 기반 중복 제거를 중요한 검증 단계 및 sanity check로 사용할 것을 권장한다.

WebText LM의 성능이 암기(memorization)에 기인하는지 여부를 판단하는 또 다른 잠재적인 방법은 자체 held-out 세트에서의 성능을 검사하는 것이다. Figure 4에서 보듯이, WebText의 학습 및 테스트 세트 모두에서 성능은 유사하며 모델 크기가 증가함에 따라 함께 향상된다. 이는 GPT-2조차도 여러 면에서 WebText에 대해 여전히 underfitting하고 있음을 시사한다.

GPT-2는 또한 말하는 유니콘의 발견에 대한 뉴스 기사를 작성할 수 있다. 예시는 Table 13에 제공되어 있다.

5. Related Work

이 연구의 상당 부분은 더 큰 데이터셋으로 학습된 더 큰 language model의 성능을 측정하는 데 할애되었다.

Figure 4. WebText로 학습된 LM의 성능을 모델 크기의 함수로 나타낸 그래프.

Figure 4. WebText로 학습된 LM의 성능을 모델 크기의 함수로 나타낸 그래프.

이는 1 Billion Word Benchmark에서 RNN 기반 language model의 스케일을 확장한 Jozefowicz et al. (2016)의 연구와 유사하다. Bajgar et al. (2016) 또한 표준 학습 데이터셋을 보완하기 위해 Project Gutenberg에서 훨씬 더 큰 학습 데이터셋을 생성하여 Children's Book Test의 결과를 개선한 바 있다. Hestness et al. (2017)은 모델 용량과 데이터셋 크기 모두의 함수로서 다양한 딥러닝 모델의 성능이 어떻게 변화하는지에 대한 철저한 분석을 수행했다. 우리의 실험은 task 전반에 걸쳐 훨씬 더 많은 노이즈를 포함하지만, 유사한 경향이 objective의 하위 task에서도 유지되며 1B+ 파라미터 영역까지 이어진다는 것을 시사한다.

생성 모델에서 흥미로운 학습 기능은 이전에 문서화된 바 있다. 예를 들어, Karpathy et al. (2015)는 RNN language model의 cell이 줄 너비 추적(line-width tracking) 및 **인용/주석 감지(quote/comment detection)**를 수행하는 것을 보여주었다. 우리 연구에 더 영감을 준 것은 Liu et al. (2018)의 관찰이었다. 그들은 Wikipedia 기사를 생성하도록 학습된 모델이 언어 간 이름 번역도 학습했다는 것을 발견했다.

이전 연구에서는 iWeb Corpus (Davies, 2018)와 같이 웹 페이지의 대규모 텍스트 코퍼스를 필터링하고 구축하는 대안적인 접근 방식을 탐구했다.

언어 task를 위한 사전학습(pre-training) 방법론에 대한 광범위한 연구가 진행되어 왔다. 서론에서 언급된 것 외에도, GloVe (Pennington et al., 2014)는 단어 벡터 표현 학습을 Common Crawl 전체로 확장했다. 텍스트를 위한 딥 표현 학습에 대한 영향력 있는 초기 연구는 Skip-thought Vectors (Kiros et al., 2015)였다. McCann et al. (2017)은 기계 번역 모델에서 파생된 표현의 사용을 탐구했으며, Howard & Ruder (2018)는 (Dai & Le, 2015)의 RNN 기반 fine-tuning 접근 방식을 개선했다. (Conneau et al., 2017a)는 자연어 추론 모델에 의해 학습된 표현의 전이 성능을 연구했으며, (Subramanian et al., 2018)은 대규모 멀티태스크 학습을 탐구했다. (Ramachandran et al., 2016)은 seq2seq 모델이 사전학습된 language model을 encoder 및 decoder로 초기화할 때 이점을 얻는다는 것을 입증했다. 최근 연구에서는 LM 사전학습이 chit-chat dialog 및 dialog 기반 질문 응답 시스템과 같은 어려운 생성 task를 위해 fine-tuning될 때도 유용하다는 것을 보여주었다 (Wolf et al., 2019) (Dinan et al., 2018).

6. Discussion

많은 연구가 supervised와 unsupervised pre-training 방법의 representation을 학습(Hill et al., 2016), 이해(Levy & Goldberg, 2014), 그리고 비판적으로 평가(Wieting & Kiela, 2019)하는 데 집중되어 왔다. 우리의 결과는 unsupervised task learning이 탐구할 만한 또 다른 유망한 연구 분야임을 시사한다. 이러한 발견은 pre-training 기법이 downstream NLP task에서 널리 성공한 이유를 부분적으로 설명할 수 있는데, 우리는 극한 상황에서 이러한 pre-training 기법 중 하나가 supervised 적응이나 수정 없이도 직접 task를 수행하는 법을 학습하기 시작함을 보여준다.

Reading comprehension에서 GPT-2의 성능은 zero-shot 환경에서 supervised baseline과 경쟁할 만하다. 그러나 summarization과 같은 다른 task에서는 정성적으로는 해당 task를 수행하고 있으나, 정량적 지표에 따르면 성능은 여전히 기초적인 수준에 머물러 있다. 이는 연구 결과로서는 시사적이지만, 실제 응용 측면에서 GPT-2의 zero-shot 성능은 여전히 실용화되기에는 한참 부족하다.

우리는 WebText LM의 zero-shot 성능을 많은 전형적인 NLP task에서 연구했지만, 평가할 수 있는 추가 task가 매우 많다. GPT-2의 성능이 여전히 random 수준을 넘지 못하는 실제 task도 분명히 존재한다. 심지어 우리가 평가한 question answering과 translation 같은 일반적인 task에서도, language model이 trivial baseline을 능가하기 시작하는 것은 충분한 capacity를 가질 때부터이다.

Zero-shot 성능은 GPT-2가 많은 task에서 발휘할 수 있는 잠재적 성능의 baseline을 설정하지만, fine-tuning 시의 상한선은 명확하지 않다. 일부 task에서 GPT-2의 완전한 abstractive output은 현재 많은 question answering과 reading comprehension dataset에서 state-of-the-art로 자리잡고 있는 extractive pointer network(Vinyals et al., 2015) 기반 output과 크게 다르다. GPT fine-tuning의 과거 성공을 고려할 때, 우리는 decaNLP와 GLUE와 같은 benchmark에서 fine-tuning을 연구할 계획이다. 특히 GPT-2의 추가 training data와 capacity가 BERT(Devlin et al., 2018)에서 드러난 uni-directional representation의 비효율성을 극복하기에 충분한지는 불분명하기 때문이다.

7. Conclusion

충분히 크고 다양한 데이터셋으로 학습된 대규모 언어 모델은 많은 도메인과 데이터셋에서 좋은 성능을 발휘할 수 있다. GPT-2는 테스트된 8개 언어 모델링 데이터셋 중 7개에서 zero-shot으로 state-of-the-art 성능을 달성했다. 모델이 zero-shot 설정에서 수행할 수 있는 task의 다양성은, 충분히 다양한 텍스트 코퍼스의 likelihood를 최대화하도록 학습된 고용량 모델이 명시적인 supervision 없이도 놀랍도록 많은 task를 수행하는 방법을 학습하기 시작한다는 것을 시사한다.

Acknowledgements

WebText에 텍스트를 작성하고, 링크를 공유하며, 콘텐츠에 upvote를 해준 모든 분들께 감사드립니다. GPT-2 학습에 사용된 데이터를 만드는 데 수백만 명의 사람들이 참여했습니다. 또한 Zak Stone, JS Riehl, Jonathan Hseu, Russell Power, Youlong Cheng, Noam Shazeer, Solomon Boulos, Michael Banfield, Aman Gupta, Daniel Sohn 등 학습 인프라를 지원해준 모든 Googler들에게도 감사드립니다. 마지막으로 논문 초안에 피드백을 준 Jacob Steinhardt, Sam Bowman, Geoffrey Irving, Madison May에게도 감사드립니다.

8. Appendix A: Samples

8.1. Model capacity

Figure 4에서 보여지는 WebText에 대한 더 큰 LM의 perplexity 향상을 보완하기 위해, Table 7부터 11까지는 가장 작은 WebText LM과 GPT-2가 무작위로 선택된 미학습 WebText 테스트 세트 기사에 대해 생성한 텍스트 완성(completion) 결과를 나란히 보여준다.

8.2. Text Memorization

우리는 WebText 데이터셋에 여러 번 반복되는 긴 문자열(예: 유명한 인용문이나 연설)에서 GPT-2의 일부 암기 행동을 관찰했다. 예를 들어, WebText 전체에 약 40번 등장하는 게티즈버그 연설의 첫 문장 반을 조건으로 주었을 때, GPT-2의 argmax 디코딩은 해당 연설을 그대로 복구한다. truncation 없이 샘플링했을 때도, 모델이 잠시 동안 연설을 복사하다가 비슷한 스타일로 벗어나는 것을 발견했다. 일반적으로 100-200 토큰 내에서 벗어나기 시작하며, 벗어난 후에는 다양성이 확대된다.

샘플에서 정확한 암기가 얼마나 자주 나타나는지 정량화하기 위해, 우리는 WebText 테스트 세트 기사를 조건으로 GPT-2에서 샘플을 생성하고, GPT-2 생성물의 겹침률(overlap rates)을 ground-truth 완성물의 겹침률과 비교했다. 이 분석 결과는 아래에 제시되어 있으며, GPT-2가 학습 세트의 텍스트를 held-out 기사의 baseline 겹침률보다 덜 자주 반복한다는 것을 시사한다.

Figure 5. WebText 학습 세트와의 8-gram 겹침률의 CDF. WebText 테스트 세트와 샘플(WebText 테스트 세트를 조건으로, top- truncation 랜덤 샘플링 적용) 모두에 대한 결과이다. 대부분의 샘플은 1% 미만의 겹침률을 보이며, 30% 이상의 샘플은 겹침이 전혀 없었다. 반면, 테스트 세트의 중앙값은 2.6%의 겹침률을 보였다.

Figure 5. WebText 학습 세트와의 8-gram 겹침률의 CDF. WebText 테스트 세트와 샘플(WebText 테스트 세트를 조건으로, top- truncation 랜덤 샘플링 적용) 모두에 대한 결과이다. 대부분의 샘플은 1% 미만의 겹침률을 보이며, 30% 이상의 샘플은 겹침이 전혀 없었다. 반면, 테스트 세트의 중앙값은 2.6%의 겹침률을 보였다.

8.3. Diversity

Table 12는 동일한 무작위 WebText 테스트 세트 context에 대한 여러 완성(completion) 결과를 보여주며, 표준 샘플링 설정에서 완성의 다양성을 나타낸다.

8.4. Robustness

Table 13은 이전에 언급된 말하는 유니콘 뉴스 기사를 보여준다. 우리는 모델이 분포 외(out of distribution) 컨텍스트를 처리할 수 있음을 확인했지만, 이러한 샘플의 품질은 일반적으로 더 낮다.

Context (WebText test)

Outfit 1: Typical

이 조합은 신발을 샀을 때 가장 먼저 떠올랐던 옷차림이다. Jake Grantham의 옷차림을 여름 버전으로 바꾼 것과 같다. 사실, 내 신발은 그의 Nike Racers 색상과 거의 비슷하다! 두꺼운 Harris Tweed 재킷과 데님 셔츠 대신, 나는 면 DB 재킷과 린넨 셔츠를 입었다. 이 두 직물(이 색상들로)은 여름에 필수적인 아이템인데, 어두운 색 바지와 밝은 색 바지 모두에 잘 어울리기 때문이다. 보시다시피, 어두운 청바지와 신발에 아주 잘 어울린다. 이것은 pseudo menswear/prep outfit이다.

전반적으로 이것은 매우 캐주얼한 옷차림이어서 스니커즈와 함께 매치했다. 나는 풀 울 수트에 스니커즈를 신는 것(GQ에서 많이 보여주는 것처럼)은 선호하지 않지만, 이 면 DB처럼 캐주얼한 분위기를 유지하는 것에는 분명히 열려 있다. 캐주얼한 직물은 드레스 다운된 menswear outfit에서 스니커즈를 잘 소화하는 데 핵심이다. 나는 심지어 이 스니커즈를 카키 치노 수트나 화이트 린넨 수트와 함께 입는 것도 추천한다. 다만, 타이는 매지 않거나 티셔츠나 폴로 셔츠를 입는 것이 좋다. 스니커즈에 타이를 매는 것은 다소 과할 수 있다.

Small model completion

Outfit 2: High End

이 의상은 마치 폭풍의 눈과 같았다. 이는 ASICS가 스트리트웨어(J. Crew와 같은)와 결합하는 방식과 J. Crew가 좀 더 전통적인 캐주얼 의류와 결합하는 방식의 하이브리드이다. 다시 말하지만, 앞서 언급했듯이 저예산 아이템이며, 이들은 매우 비쌀 수 있다. 캐주얼한 스니커메이커로 일하려는 경우, 이들은 분명 문제가 될 수 있지만, 더 저렴한 버전의 의상을 시도하고 싶다면 주저하지 마라!

이 버전은 매우 낮은 컷-컷 네크라인(나쁘지 않다), 약간 더 긴 다리, 그리고 전체적인 균형을 잡아주는 긴 다리가 특징이다. 내가 선호하는 색상은 블루-그레이(내 첫 번째 색상이며, 밝은 흰색에 가깝다) 또는 **블랙(내 디자인 중 가장 좋아하는 색상)**이다. 언제나 그렇듯이, 이 매장에서 내가 고른 색상들은 디자인 외에는 다른 어떤 것과도 관련이 없다. 고급스러운 느낌을 원한다면, 이 제품을 모두에게 추천한다!

Outfit 3: High Light

이것은 제가 약간의 색을 얻을 기회가 있을 때 "하이라이트" 룩이었습니다. 색상은 다음을 기반으로 한다고 생각합니다.

GPT-2 completion

나를 위해!

Outfit 2: 캐주얼 재킷

어떤 사람들은 터틀넥에 스니커즈를 신는 것에 반대할 수도 있겠지만, 나는 나 자신에게 충실하고 싶었기 때문에, 그날 내가 가장 좋아하는 색상과 더 유사한 색상의 슬림핏 터틀넥을 선택했다. 전반적으로, 너무 화려하지 않은 클래식한 터틀넥이다. 나는 신발을 이 ASICS Tiger Killshots로 바꿨는데, 그러지 말았어야 했다는 후회가 든다. 신발 자체는 매우 편안하지만, 이 스니커즈를 신으니 발이 좀 더 커 보이는 느낌을 받았다. 나는 이 신발을 데님, 치노 등 어떤 옷과도 함께 입겠지만, 단독으로 신는 것은 절대 추천하지 않을 것이다. 너무 많은 변수가 관련되어 있기 때문이다.

Outfit 3: 드레스

이것은 내가 ASICS Tiger Killshots를 신었던 마지막 의상이다. 이 버전의 ASICS는 훨씬 더 현대적이고 유선형의 버전이다. 이 신발은 내가 생각할 수 있는 가장 현대적이고 미니멀한 디자인을 가지고 있다! 검은색이 많이 들어가서 이 스니커즈는 매우 멋져 보인다. 여름에 신기에 분명 매우 편안할 것이다.

나에게는 정장과 함께 신는 것이 좋은 스니커즈를 신는 가장 쉬운 방법이다. 거의 다 왔다! 만약

Table 7. 무작위로 선택된 미공개 context (상단)와, 가장 작은 모델(왼쪽) 및 가장 큰 모델(오른쪽)에서 cherry-picking 없이 생성된 완성본(completion). Context는 768 토큰이며, 약 256 토큰 분량의 단락이 표시되어 있다. 완성본은 256 토큰이며 전체가 표시되어 있다. 생성에는 인 top- 무작위 샘플링이 사용되었다.

Context (WebText test)

스페인의 가장 훌륭한 역사적 명소 중 일부는 무슬림 통치 시대에 지어진 것으로, 여기에는 코르도바 대모스크로 지어진 **메스키타(The Mezquita)**와 역시 코르도바에 위치하며 현재는 폐허가 되었지만 여전히 방문 가능한 메디나 아자하라(Medina Azahara)(알-안달루스의 궁전인 마디나트 알-자흐라로 지어짐)가 포함된다. 또한 그라나다에는 웅장하고 온전하게 보존된 궁전인 **알함브라(Alhambra)**가 있다. 무슬림 스페인 시대에 지어져 현재까지 남아있는 두 개의 유대교 회당도 있는데, 톨레도의 **산타 마리아 라 블랑카(Santa María la Blanca)**와 구시가지에 있는 **코르도바 유대교 회당(Synagogue of Córdoba)**이다.

Reconquista and Imperial era [ edit ]

Small model completion

무슬림 스페인 시대는 다른 지역의 역사와는 매우 다르며, 오히려 광범위한 중세 역사를 가지고 있다. 스페인 제국은 기원전 9세기 후반에 존재했지만, 서기 1150년경에는 훨씬 더 번영하고 다양한 상태의 작고 세속화된 제국으로 매우 느리게 변모했다. 서기 1050년, 나폴리 황제는 적어도 부분적으로는 이 지역의 북서쪽 해안에서 서쪽 해안까지 일련의 전쟁과 침략(예: 지브롤터에서 스페인 남부까지 뻗어 있었지만 같은 날 로마군에 의해 빠르게 파괴된 다뉴브 강 유역)으로 특징지어졌으며, 나폴리 황제의 칭호를 얻었다. 그는 지난 수십 년 동안 제국을 복원하고 유지하는 데 큰 공헌을 했으며, 그중 서쪽으로의 첫 번째 공헌이었다. 그의 후계자는 1148년 교황청으로부터 권력을 잡은 페르디난트였고, 첫 번째 제국 후계자는 스웨덴의 알프레드 2세 국왕이었다. 제국은 다시 유럽 대륙에서 몇 안 되는 독립 국가 중 하나가 되었고, 이 기간 동안 영토에 2억 명 이상의 사람들이 살지는 않았지만, 사람들은 황제에게 할 말이 많았다. 1720년부터 무슬림은 스페인 인구의 절반을 차지했다.

GPT-2 completion

Reconquista(문자 그대로 “나라로의 귀환”)는 1092년과 1095년에 이베리아 반도에서 Castile과 Aragon의 통합 왕국이 수립되었고, 그 안에 무슬림 왕조가 존재하게 된 사건을 말한다. 이는 유럽에서 무슬림 지배가 “토착”으로 간주된 마지막 시기였으며, 기독교에 의해 자극되고 조직된 갈등이 유럽에서 드러난 마지막 사례였다.

스페인에서 무슬림 Moor의 통치는 특히 비무슬림들 사이에서 흔히 “Conquest of Granada”라고 불리며, 스페인을 “Granada의 스페인”이라고 부르기도 한다. 무슬림 지배의 마지막 시기는 스페인 Reconquista로 이어졌고, 이 과정에서 무슬림들은 1189년 3월 Poitiers 전투에서 Ferdinand IX의 승리와 1187년 Saladin의 예루살렘 정복과 함께 이베리아 반도에서 추방되거나 떠나도록 강요받았다.

스페인에서의 Reconquista 시기는 Moor가 북쪽으로 후퇴하면서 끝났다. 그러나 Moor의 지배가 완전히 기독교 지배로 대체된 것은 Reconquista 시대가 다시 시작된 이후였으며, Reconquista는 1229년부터 1492년까지 지속되었다.

The last Muslim state in Spain, Granada, was conquered by the

Table 8. 임의의 보지 못한 context(상단)와, 가장 작은 모델(왼쪽)과 가장 큰 모델(오른쪽)에서 생성된 non-cherry-picked completion. context 길이는 768 tokens이며, 이 중 약 256 tokens 분량의 paragraph가 표시됨. completion 길이는 256 tokens이며, 전체가 표시됨. 생성에는 의 top- random sampling이 사용됨.

Context (WebText test)

Pinky

분홍색 유령의 AI는 빨간색 유령의 행동과 반대되는 방식으로 "느끼도록" 설계되었다. Pinky는 실제로 Pac-Man의 앞에 나가려고 시도한다. 이는 Pac-Man이 이동하는 방향으로 Pac-Man의 현재 위치에서 4칸 앞을 목표 지점으로 설정함으로써 이루어진다. 한 가지 예외는 Pac-Man이 위로 이동할 때이다. 코드의 오버플로우 버그로 인해, 계산에 예상되는 위쪽 오프셋과 동일한 왼쪽 오프셋이 포함된다.

Pac-Man의 예상 위치를 활용하는 것은 플레이어가 Pinky의 내비게이션 코드를 악용할 수 있게 한다. 이는 Pac-Man과 Pinky가 서로 가까이 있을 때 가장 자주 나타났다. 예를 들어, 만약 그들이 서로를 향해 가고 있다면, 4칸 이내로 가까워지면 목표 타일은 Pinky 뒤에 놓이게 된다. Pinky가 이 상태에서 교차로를 만나면, 목표 타일에 도달하기 위해 (방향을 바꿔) 되돌아가려고 시도할 것이다.

플레이어들은 Pinky가 교차로에 접근할 때 빠르게 방향을 바꾸어 종종 **'헤드 페이크(head fake)'**라고 불리는 동작을 수행했다. Pinky가 접근할 때 목표 타일을 이동시킴으로써

Small model completion

왼쪽으로 오고 있었다면, "올바른" 방향을 얻었을 것이다.

만약 유령의 실제 위치가 Pac-Man이 있던 곳보다 멀리 떨어져 있다면, 플레이어는 유령의 움직임에 반응하지 않을 것이고, 유령은 대신 플레이어의 현재 위치로 돌아올 것이다. 이는 Pac-Man이 방향을 바꾸어 움직이지 않기 때문이다.

유령은 시작했던 곳으로 돌아가기 위해 어떤 종류의 다른 위치로 가야 할 것이며, 이는 여러 가지 방법으로 달성된다. 예를 들어 Pac-Man이 절벽에서 뛰어내렸다면, 유령은 단순히 그 위치를 떠나 사라지기 전의 지점으로 돌아올 것이다. 이러한 유령의 경로가 가능한 경우는 많지만, 가장 분명한 것은 플레이어가 게임에 갇히는 것을 피하고 싶을 때이며, 목표는 Pac-Man을 원래 시간의 만큼만 게임에 유지하는 것만큼 쉽다.

추격 (Chasing) Pac-Man의 경우, 이는 Pac-Man이 싸움에서 "따라잡는" 방식과 유사할 것이다.

유령은 적들을 통해 추격할 수 있다. 이는 Pac-Man과 그의 AI 모두에게 여러 가지 이유로 유용하다. 대부분의 Ghost 게임과 달리, 이 유령은 단순히 다음 방향으로 이동한다.

GPT-2 completion

교차로를 건너려 할 때, 팩맨은 유령들의 발사체를 피하고 안전한 집으로 돌아갈 수 있을 것이다.

Buster

노란색 유령의 AI는 Pac-Man이 safe house를 떠나는 것을 피하도록 특별히 설계되었다. 플레이어는 SPACE 바를 눌러 safe house의 문을 열고, 그 안으로 들어가 다음 방에 숨어 있는 노란색 유령을 찾아야 한다.

플레이어는 또한 Pac-Man이 이미 safe house 안에 있는 것을 유령이 본다면, 유령은 safe house를 벗어나려 시도하지 않을 것이라는 점을 유의해야 한다. 사실, 유령은 자신이 이미 safe house 안에 있지 않는 한, 애초에 밖으로 나가려 시도하지 않을 것이다.

이 두 가지 행동은 플레이어가 항상 Pac-Man (또는 Blinky)보다 먼저 safe house에 도달하려고 시도하지는 않는다는 사실에 기반한다.

플레이어는 또한 유령(또는 다른 플레이어)이 이미 safe house 안에 있고 Pac-Man이나 Blinky가 사라지자마자 나가려고 시도하는 경우에 이 글리치를 조심해야 한다. 이 시점에서 유령은 "Chase" 모드와 유사한 방식으로 safe house를 벗어나려 시도할 것이다.

Pac-Man

Pac-Man을 쫓는 몇몇 유령들이 있다. 이 유령들은 다음과 같다:

Table 9. 무작위로 선택된 미공개 context (상단)와 가장 작은 모델(좌측) 및 가장 큰 모델(우측)에서 생성된, cherry-picking되지 않은 완성된 텍스트. Context는 768 토큰이며, 약 256 토큰 분량의 단락이 표시되어 있다. 완성된 텍스트는 256 토큰이며 전체가 표시되어 있다. 생성에는 인 Top- 무작위 샘플링이 사용되었다.

Context (WebText test)

마이클 P. 골딘(Michael P. Goeldin) 상병은 1860년 11월 A 중대에 입대했을 당시 아일랜드 출신의 미숙련 노동자였다. 골딘은 전쟁에서 살아남았다. 역시 아일랜드 출신인 패트릭 오닐(Patrick O'Neal) 상병은 1854년에 처음 입대하여 오리건에서 미 육군 제3포병대 L 중대에서 복무했다. 그는 동부 해안으로 돌아와 1860년에 A 중대에 입대했다. 오닐은 1874년 뉴욕 윌렛츠 포인트(Willets Point) 국립묘지 관리자로 임명될 때까지 복무했다. 벤자민 브라운(Benjamin Browne) 상병은 뉴욕 오렌지 카운티(Orange County) 출신의 구두 수선공이었다. 1862년 8월, 그는 새로 창설된 뉴욕 제124자원병대에 입대했으며, 그해 10월 A 중대로 전입한 61명 중 한 명이었다. 브라운은 1864년 2월 브랜디 스테이션(Brandy Station)에 주둔하고 있을 때 A 중대에 재입대했다. 그는 1867년 입대 기간을 마친 후 민간인 생활로 돌아갔다.

6월 10일, 기술병 윌리엄 콜린스(William Collins)는 상병으로 진급했는데, 이는 아마도 제임스 강(James River)을 건너기 위한 전투 지휘 공백을 메우기 위함이었을 것이다. 콜린스의 복무 기록은 그가 이 진급을 얻기 위해 보여준 자질을 명확히 보여주지는 않지만, 그는 분명히 심각한 문제들을 극복했었다. 뉴욕 새킷츠 하버(Sacketts Harbor)에서 태어난 콜린스는 1853년 12월 22세의 나이로 A 중대에 입대했으며, 1858년 12월에 재입대했다. 1861년 4월 전쟁이 시작되기 불과 한 달 전, 콜린스는 "탈영"했고 3년 후에야 붙잡혔다. 1864년 3월 22일 A 중대로 복귀한 그는 재판을 받았다.

Small model completion

군사적 혐의로 기소되어 미군에서 제대했다. 그는 회사로 복귀하여 남북전쟁 중 내무부(Division of Internal Affairs)에 배정되었다.

엔지니어로서 Collins는 고향인 뉴욕에서 공학 교육을 받았다. Union College of Engineering에서 대학원 과정을 마친 후, 그는 동시에 2년간 미 육군에서 근무했다. 그곳에서 그는 Daniel Pfeiffer 대위 밑에서 일했으며, Pfeiffer 대위가 입대한 지 3년 후인 1870년 5월에 대령으로 진급했다. Collins는 제1사단에서 첫해를 마친 후 영국으로 귀국하여 육군 공병대에서 다음 2년간 복무했으며, 두 번째 해에는 복무 의무를 경험하기 시작했다. - endoftext- 모스크바, 7월 5일 (로이터) - 영국에 기반을 둔 러시아 국영 언론과 정부 소식통 및 전문가들은 모스크바가 시리아 반군의 "군사력 증강"을 경시하려 하면서도, 도널드 트럼프 대통령의 미국-멕시코 국경 장벽 건설 계획에 대한 지지를 유지하며 이를 "군사 쿠데타"라고 불렀다고 전했다. 미국 주도의 시리아 전쟁 참전 용사이자 시리아 특사인 마이클 플린(오른쪽)이 미국에 기반을 둔 시리아 정치 분석가 아흐메트 코리아트와 함께 제스처를 취하고 있다.

GPT-2 completion

그해 6월에 사형 선고를 받았음에도 불구하고, 그는 현역으로 복무했다.

제임스 J. 달(James J. Dall) 대위는 1829년 버지니아에서 혁명 중에 태어나 1836년 아버지와 함께 육군에 입대했다. 그는 1845년까지 제2 버지니아 보병대에서 복무한 후, Western Reserve Regiment로 전속되었다. 전역 후에는 제25 뉴욕 의용군 I중대(1845년 당시 약 4,500명 규모)에 재입대했다. 그의 형제 중 한 명인 제임스도 같은 여단에서 같은 중대에 같은 직책으로 복무했다. 1846년 내내 연대가 코네티컷에 머무는 동안, 달 대위는 전역 전 여러 차례 I중대에서 복무했다. 멕시코 전쟁 참전 용사였던 그는 샌안토니오에서 존 J. 설리번(John J. Sullivan) 준장의 참모로 2년간 복무했다. 1863년 반도 전역(Peninsula Campaign) 동안 그는 23명으로 구성된 중대를 지휘했으며, 54문의 중박격포 포대와 포대 소속의 포함 Pinta, 그리고 여러 척의 다른 보트들을 담당했다. 달 대위는 1865년 가을 I중대에서 현역으로 복무 중이었다. 2년 후, 그는 소위로 진급했다.

존 A. 오(John A. O') 대위

Table 10. 무작위로 선택된 미공개 context (상단)와 가장 작은 모델(좌측) 및 가장 큰 모델(우측)에서 cherry-picking 없이 생성된 completion. Context는 768 token이며, 약 256 token 분량의 단락이 표시되어 있다. Completion은 256 token이며 전체가 표시되어 있다. 생성에는 **top-k random sampling (k=40)**이 사용되었다.

Context (WebText test)

Xmonad, Xresources, and Fonts

Xresources는 정말 골치 아픈 존재일 수 있다 (적어도 나에게는 그랬다). 그래서 여기에 약간의 도움을 주고자 한다:

우선, Xmonad에서 폰트가 일반적으로 처리되는 방식은 XFT를 통해서이다. Xft는 X FreeType Interface 라이브러리이며, Xmonad/urxvt에서 실제 폰트 렌더링을 담당하는 라이브러리이다. (Xresources는 X window manager 하에서 실행되는 프로그램들에 대한 여러 리소스들을 지정한다. 개별 프로그램에 대한 설정은 Xresources에 다음과 같이 지정된다: Urxvt.background:background settins here).

어쨌든, 폰트는 Xresources에서 다음 구문을 사용하여 설정된다:

urxvt*font:xft:your font name goes here:size=the size of the font goes here,xft:fall-back font 1 goes here

이것이 Xresources를 통해 urxvt에서 폰트를 지정하는 가장 기본적인 부분이다.

Fixing /.ssh/ Permissions in Cygwin

Windows의 Cygwin에서 /.ssh/ 폴더의 권한을 0600으로 설정할 수 없었다. 이는 SSH가 키를 사용하도록 허용하는 데 필요한 권한이다. 내가 겪었던 증상은 무엇을 하든 항상 소유자와 그룹이 변경되는 것이었다.

Small model completion

경로가 /ssh/로 설정되어 있었는데, 이는 당시의 일반적인 방식이었다. 이 문제는 완전히 해결할 수 없었다. 나는 마우스로 사용자 이름을 입력하는 것만으로도 훨씬 더 효율적으로 작업할 수 있다는 것을 알게 되었고, 그룹에 대한 권한을 "0600"으로 설정하려고 시도했다. 현재 내 시스템은 그렇게 설정되어 있다.

하지만 Linux에서 Cygwin 7을 사용하면서, 그렇게 하는 것이 이제 내 시스템에서는 "불필요"하다는 것을 알게 되었다! 나는 또한 chroot라는 패키지를 설치했다. 이 패키지는 시스템 디렉토리에 설치/업그레이드할 수 있도록 해준다.

따라서 Windows 8 이상에서는 chroot 설치가 필요할 수 있으므로, 나는 여러 번 시도한 끝에 Linux에 패키지를 설치한 다음 제거하는 것이 그리 나쁘지 않다는 것을 알게 되었다. Cygwin에 대한 마지막 글을 작성했을 때, 스크립트는 그저 제 역할을 수행했다 (sudo 명령어가 나머지를 처리한다). 만약 당신이 시도한다면 변경 사항을 기록해야 할 것이다.

이것만으로도 충분히 혼란스럽지 않았다면, 내가 시도했던 것은 이렇다. 나는 그저 내 /.ssh/ 디렉토리와 chroot 스크립트로 돌아갔다. 나는 결국 권한이 부족하다는 것을 알게 되었다 (파일 시스템에서 ssh로의 심볼릭 링크를 생성하는 것을 잊었기 때문에).

GPT-2 completion

, 이 파일들을 읽기 전용으로 만들었다. 나는 단순히 ssh를 시작하고 passwd와 같이 소유자/그룹 권한을 0644로 수정하는 프로그램을 사용해 보았지만 작동하지 않았다. 이것은 짜증나는 일이었지만, 최악의 상황만큼 나쁘지는 않았고, 단지 권한을 조작해야 하는 것이 귀찮을 뿐이었다.

그래서 나는 이 작업을 역방향으로 수행하기로 결정했다:

Cygwin 디렉터리 내의 각 .ssh 폴더에 대해, 각 파일과 디렉터리의 권한을 2644로 설정한다. 그런 다음 다음 명령어로 ssh를 시작한다: ssh-add /.ssh/

처음 연결할 때, Cygwin에 있던 /.ssh 폴더의 권한은 0600으로 설정될 것이다. 그 후 다시 연결할 때마다 권한은 0644로 변경될 것이다.

Xresources용 Makefile ( /.xsessionrc에서 사용됨)

이것들은 내 /.xsessionrc에서 만들어진다:

.xprofile: .xsession-errors: color=""

예를 들어:

.xprofile: color=blue

색상이 별도의 파일에 저장되므로, /.xsession-errors의 색상은 파란색 대신 시안색으로 보일 것이다.

이것은 주로 현재로서는 색상만 할당되기 때문이다.

Table 11. 무작위로 선택된 보지 못한 context (상단)와 가장 작은 모델(왼쪽) 및 가장 큰 모델(오른쪽)에서 cherry-picking 없이 생성된 completion. Context는 768 token이며, 약 256 token 분량의 단락이 표시되어 있다. Completion은 256 token이며 전체가 표시되어 있다. 생성에는 **top-k random sampling (k=40)**이 사용되었다.

Context (WebText test)

!!! 원본 논문 참고

GPT-2 Completion 1

레시피. 저는 더 긴 버전을 만들었고, 팬을 사용하여 버터크림 프로스팅 한 층을 만들고 1/3은 프로스팅 토퍼용으로 냉장고에 넣어두었습니다. 이 케이크를 만들기 전에 이 프로스팅을 모두 준비해 두면, 계란 흰자가 믹싱 볼 바닥에 가라앉아 있는 동안 기다릴 필요가 없을 것입니다.

계란 흰자를 단단한 머랭으로 만들고 싶으신가요? 그렇다면 케이크 볼을 끓는 물이 담긴 냄비 위에 올려놓고 아주 살짝 따뜻해질 때까지 데우세요. 3~5분 이상 걸리지 않습니다. 딱 시작할 정도면 됩니다.

GPT-2 Completion 2

레시피를 가지고 있고, 그 케이크를 만들 줄 안다면, 당신의 삶은 결코 예전과 같지 않을 것이다.

나는 쿠키 부스러기나 초콜릿 칩에 관해서는 두 가지 아주 간단한 규칙을 가지고 있다. 1) 원당을 사면, 식어서 설탕이 적어도 반 티스푼 정도 뿌려질 때까지는 사용하지 않는다. 그것이 나의 규칙이다. 그리고 2) 어떤 재료를 요구하는 레시피가 있는데 내가 그것을 레시피에 사용하고 싶다면, 온라인에서 다른 것으로 대체하지 않는다. 이처럼.

나는 귀여운 새끼 고양이들이 그려진 정말 귀여운 카드를 발견했다.

GPT-2 Completion 3

레시피는 대략 동일한 양의 케이크를 만들 것이다.

초콜릿 버터밀크 케이크

버터밀크를 입히고 바삭한 다진 초콜릿을 얹은 초콜릿 케이크 덩어리에 초콜릿 소스를 뿌렸다. 간단하지만 초콜릿 케이크와는 다른 좋은 변화!

작성자: Momma Made

재료

초콜릿 버터밀크 케이크용

무염 버터 1 1/2컵 (실온)

설탕 1 1/2컵

큰 달걀 3개 + 달걀 노른자 1개

초콜릿 글레이즈용

코코아 파우더 1/3컵

슈가 파우더 1 3/4컵

세미스위트 초콜릿 6온스

GPT-2 Completion 4

레시피. 머랭 쿠키 버터 13/4컵 (부드럽게 한 것) 설탕 1컵 달걀 노른자 1개 헤비 크림 3큰술 밀가루 3 1/2-4컵 소금 한 꼬집

페퍼민트-조조 토핑 슈가 파우더 11/4컵 다진 피칸 1컵 잘게 다진 민트 잎 1/2컵 다진 생 민트 1/2컵 (약 1/2장) 페퍼민트 추출액 1작은술 바다 소금 1/4작은술 바다 소금 한 꼬집

GPT-2 Completion 5

레시피. 크리스마스 아침에 두 번 실패한 것은 형편없는 프로스팅 기술 때문이 아니었다. 그건 또 다른 성공 스토리였다. 케이크는 촉촉하고, 그냥 아름다운 케이크였다. 공기나 수분은 거의 없었지만, 모든 초콜릿과 민트가 완벽하게 어우러져 있었다.

나를 조금 움츠러들게 한 한 가지는 그 모든 재료들—달걀 노른자, 설탕, 녹인 버터, 초콜릿 칩, 녹인 초콜릿, 그리고 민트—이 케이크 반죽에 바로 섞여야 한다는 점이었는데, 이는 엄청나게 시간이 많이 걸리는 일이다. 한 친구가 반죽을 다른 볼에 넣으면 내가

GPT-2 Completion 6

레시피는 약 69인분의 맛있는 초콜릿 케이크를 만들 수 있다. 레이어가 서로 붙는 것을 방지하기 위해 8인치 원형 타르트 팬을 사용하고, 유산지를 깔아준 다음, 거기서 7인치 원형 케이크 4개를 잘라내어 층층이 쌓았다 (이 방법은 1단 초콜릿 케이크에도 잘 적용되었다). 케이크를 구울 준비가 되면 유산지를 제거하고, 오븐을 350도로 예열한 후 약 3040분간 굽는다. 윗면이 황금색이 되고 꼬치로 찔러보아 깨끗하게 나오면 완성이다.

초콜릿 버터밀크 레이어 케이크 with 페퍼민트 조

Table 12. WebText test에서 동일한 context로 GPT-2가 생성한, cherry-picking하지 않은 완성 결과. Context는 384 토큰(잘린 상태로 표시)이며, 생성된 텍스트는 128 토큰이다. 생성에는 top- random sampling ()이 사용되었다.

Context (사람이 작성): 충격적인 발견으로, 과학자들은 안데스 산맥의 외딴, 이전에 탐험되지 않았던 계곡에서 유니콘 무리가 살고 있다는 것을 발견했다. 연구자들에게 더욱 놀라웠던 것은 유니콘들이 완벽한 영어를 구사한다는 사실이었다.

GPT-2: 과학자들은 그들의 독특한 뿔을 따서 그 개체군을 Ovid's Unicorn이라고 명명했다. 이 네 개의 뿔을 가진 은백색 유니콘들은 이전에 과학계에 알려지지 않았다.

이제 거의 두 세기 만에, 이 기이한 현상을 촉발시킨 미스터리가 마침내 풀렸다.

라파스 대학교의 진화 생물학자 호르헤 페레즈 박사와 몇몇 동료들은 안데스 산맥을 탐험하던 중 다른 동물이나 사람이 없는 작은 계곡을 발견했다. 페레즈는 그 계곡에 바위와 은빛 눈으로 둘러싸인 자연 샘처럼 보이는 것이 있다는 것을 알아차렸다.

페레즈와 다른 사람들은 그 계곡으로 더 깊이 들어갔다. "우리가 한 봉우리 꼭대기에 도착했을 때, 물은 파란색으로 보였고, 위에 약간의 결정들이 있었습니다."라고 페레즈는 말했다.

페레즈와 그의 친구들은 유니콘 무리를 보고 깜짝 놀랐다. 이 생물들은 너무 가까워서 뿔을 만질 수 있을 정도로, 너무 많이 움직이지 않고도 공중에서 볼 수 있었다.

이 기이한 생물들을 조사하는 동안 과학자들은 그 생물들이 꽤 유창한 영어도 구사한다는 것을 발견했다. 페레즈는 "예를 들어, 그들이 공통된 '언어', 즉 방언이나 변증법 같은 것을 가지고 있다는 것을 알 수 있습니다."라고 말했다.

페레즈 박사는 유니콘들이 아르헨티나에서 유래했을 수도 있다고 믿는다. 그곳에서는 이 동물들이 남아메리카에 인간이 도착하기 전에 살았던 잃어버린 인종의 후손이라고 여겨졌다.

그들의 기원은 여전히 불분명하지만, 일부는 인간 문명 이전의 시대에 인간과 유니콘이 서로 만났을 때 이 생물들이 창조되었을 수도 있다고 믿는다. 페레즈에 따르면, "남아메리카에서는 그러한 사건들이 꽤 흔한 것 같습니다."

그러나 페레즈는 또한 유니콘이 실제로 잃어버린 외계 종족의 후손인지 확실히 알 수 있는 유일한 방법은 DNA를 통해서일 가능성이 높다고 지적했다. "하지만 그들은 영어를 꽤 잘 구사할 수 있는 것 같고, 저는 이것이 진화의 징후, 또는 적어도 사회 조직의 변화라고 생각합니다."라고 과학자는 말했다.

Table 13. GPT-2가 out-of-distribution context에 대해 생성한 조건부 생성 결과. 으로 생성된 10개 샘플 중 cherry-picking된 결과.

Article: 36,000년 전 현대 프랑스의 한 동굴 거친 석회암 벽에 선사시대 인류가 놀라운 선사시대 짐승들을 스케치했다. 이제 최첨단 기술의 도움으로 쇼베-퐁-다르크 동굴의 그 예술 작품들이 복제되어 세계에서 가장 큰 복제 동굴이 만들어졌다. 카베르네 뒤 퐁-다르크(Caverne du Pont-d'Arc)라는 이름의 인공 동굴은 프랑스 남부 발롱-퐁-다르크의 원래 유적지에서 몇 마일 떨어진 곳에 건설되었으며, 1,000개의 정교하게 재현된 그림과 약 450개의 뼈 및 기타 특징들을 포함하고 있다... 동굴인들은 36,000년 전 동굴의 거친 석회암 벽에 놀라운 선사시대 짐승들을 스케치했고, 이제 복제품이 만들어졌다 (사진).

GPT-2: 프랑스 남부 발롱-퐁-다르크에 있는 원래 유적지는 유네스코 세계 문화유산이며, 인간이 장식한 가장 오래되고 가장 잘 보존된 동굴이다. 복제 동굴은 프랑스 남부 발롱-퐁-다르크에 있는 원래 유적지에서 몇 마일 떨어진 곳에 건설되었다. 이 동굴에는 털코뿔소, 매머드, 큰 고양이과 동물 등 14가지 다른 종의 동물 이미지가 포함되어 있다.

Reference: 프랑스의 유명한 카베르네 뒤 퐁-다르크 동굴을 모방한 동굴, 인간이 장식한 가장 오래되고 가장 잘 보존된 동굴. 복제품에는 털코뿔소와 매머드 등 425점을 포함한 1,000점의 그림이 모두 포함되어 있다. 미세한 세부 사항은 3D 모델링 및 아나모픽 기술(종종 와이드스크린 이미지를 촬영하는 데 사용됨)을 사용하여 복사되었다. 현대 동굴에는 곰의 발자국, 뼈, 그리고 원래 동굴에 보존된 세부 사항의 복제품도 포함되어 있다.

Article: '내 잠수함을 찾으면, 네 것이다.' 러시아 석유 억만장자 로만 아브라모비치가 한때 말했다. 그리고 이 올리가르히이자 첼시 FC 구단주(그의 잠수함은 3억 파운드짜리 슈퍼요트 이클립스에 딸린 부속품 중 하나일 뿐이다. 해안에 들키지 않고 접근하는 데 완벽하다)가 수중 탐사에 돈을 쏟아붓는 유일한 부유한 사업가는 아닌 것 같다. 지구의 진정한 '마지막 개척지'라고 불리는 바다는 여전히 거의 탐험되지 않아, 억만장자들이 세계 해양의 극적인 해저 풍경과 놀라운 야생 동물을 엿볼 수 있는 선박을 사기 위해 줄을 서고 있다. 그러니 은행에 몇 백만 파운드가 남아 있고 다른 모든 사람들을 정말로 능가할 휴가 사진과 인스타그램 게시물을 원한다면, 이 중 하나를 잡고 싶을 수도 있다... 즐거운 시간: OrcaSub는 두 개의 가압된 Perspex 관측 돔에서 최적의 탐사를 위해 2000피트 아래로 당신을 데려간다. ...

GPT-2: U-Boat Worx 잠수함은 984피트(300미터)까지 잠수할 수 있으며 해저까지 잠수할 수 있다. 다이빙, 스노클링, 심지어 스노클 다이빙에도 사용할 수 있다. 이 잠수함은 스노클링 플랫폼도 갖추고 있다.

Reference: 가장 진보된 수중 해양 차량으로 제임스 본드 악당처럼 느껴보세요. 일부는 요트에서 잠수함으로 변환되고, 다른 일부는 빠른 탐사를 위해 분리됩니다. Oliver's Travels는 잠수함에서 셰프와 집사가 포함된 1박 175,000파운드의 Mile Low 패키지를 제공합니다.

Article: 아미나 알리 카심은 가장 어린 손주를 무릎에 앉히고 머리 스카프로 눈물을 닦고 있다. 태어난 지 몇 달밖에 안 된 이 아기는 공습이 시작된 밤 그녀가 필사적으로 귀를 막으려 했던 아기 소녀이다. 그녀는 예멘 비림 섬의 한 마을 모스크에서 아기가 우는 동안 폭발음을 세며 밤새 깨어 있었다고 말한다. 하지만 더 나빴을 수도 있었다. 첫 미사일이 떨어졌을 때 그들은 아직 집에 있었을 수도 있었다. "우리 이웃이 남편에게 '떠나야 해, 그들이 오고 있어.'라고 소리쳤고, 우리는 그냥 달아났어요. 집을 떠나자마자 첫 미사일이 바로 옆에 떨어졌고, 그 다음 두 번째 미사일이 집에 떨어졌어요. 모든 것이 불에 타서 재가 되었어요."라고 카심은 우리에게 말한다.

GPT-2: 예멘은 내전 중이다. 사우디아라비아가 연합군의 폭격 작전을 이끌고 있다. 두 달 넘게 예멘을 폭격하고 있다.

Reference: 아미나 알리 카심의 가족은 예멘을 떠나기 전 모스크에서 피난처를 찾았다. 그들처럼 수천 명이 배를 타고 지부티로 향하고 있다. 사우디아라비아는 후티 반군을 격퇴하기 위해 예멘을 폭격하고 있다.

| English reference | GPT-2 French translation |

|---|---|

| This re-release, titled The Next Day Extra, was presented in the form of three disks: the original album, unpublished studio sessions and remixes, plus a DVD containing the four clips that have already been unveiled. | Les nouvelles re-releases, tout en premier disc, nécessaire de l'album, un studio session et remixes, plus une DVD de l'écran de quelques clips qui ont été déjà échappés. |

| French reference <br> Un homme expliquait que le fonctionnement de la hernia fonctionnelle qu'il avait reconnait avant de faire, le fonctionnement de la hernia fonctionnelle que j'ai réussi, j'ai réussi. | GPT-2 English translation <br> This release, originally released on three discs: the original album, sessions studio inédites and remixes, a DVD containing the four clips that were released on the previous day. |

| English reference | GPT-2 French translation |

| One man explained that the free hernia surgery he'd received will allow him to work again. | Un homme expliquait que le fonctionnement de la hernia fonctionnelle qu'il avait reconnaît avant de faire, le fonctionnement de la hernia fonctionnelle que j'ai réussi, j'ai réussi. |

| French reference | GPT-2 English translation |

| Un homme a expliqué que l'opération gratuite qu'il avait subie pour soigner une hernie lui permettrait de travailler à nouveau. | A man told me that the operation gratuity he had been promised would not allow him to travel. |

| English reference | GPT-2 French translation |

| Speaking to an open government conference in London via video link, Mr Kerry said: "There is no question that the President and I and others in government have actually learned of some things that had been happening on an automatic pilot because the ability has been there, going back to World War Two and to the very difficult years of the Cold War, and then, of course, 9/11." | Le premier conference de l'édition internationale en ligne sur la vide, le ministre de l'Édition internationale a été vide, lui dit : "Il n'y a qu'une question que le président et moi et tous les autres personnes d'une administration qui a été évident par la fois, par la part de la guerre, par la part de la guer |

| French reference <br> S'exprimant lors d'une conférence intergouvernementale à Londres par liaison vidéo, M. Kerry a déclaré: ''Il est indéniable que le Président, moi-même et d'autres membres du gouvernement avons pris connaissance de certaines choses en mode pilote automatique parce que nous en avions la possibilité, dès la Seconde guerre mondiale et jusqu'aux années difficiles de la Guerre froide, puis bien sûr le 11 septembre." | GPT-2 English translation <br> In a conférence between the United States and London, Secretary of State John Kerry said: "It is indeniable that the President, myself and others of the government have been aware of certain certain choices that have been made in the past in order to be able to do certain things in a more automated way." |

Table 15. GPT-2가 생성한 영어-프랑스어 및 프랑스어-영어 번역 결과.

Context (passage and previous question/answer pairs)

2008년 하계 올림픽 성화 봉송은 2008년 하계 올림픽에 앞서 2008년 3월 24일부터 8월 8일까지 "하나의 세계, 하나의 꿈(one world, one dream)"이라는 주제로 진행되었다. 봉송 계획은 2007년 4월 26일 중국 베이징에서 발표되었다. 조직위가 "화합의 여정(Journey of Harmony)"이라고도 부른 이 봉송은 129일 동안 진행되었으며, 1936년 하계 올림픽 이전에 전통이 시작된 이래 **가장 긴 거리인 137,000km(85,000마일)**를 성화가 운반되었다.

3월 24일 그리스 올림피아의 올림픽 발상지에서 점화된 성화는 아테네의 파나티나이코 스타디움으로 이동한 후 베이징으로 향하여 3월 31일에 도착했다. 베이징에서 성화는 6개 대륙을 통과하는 경로를 따랐다. 성화는 실크로드를 따라 도시들을 방문하며 중국과 세계 다른 지역 간의 고대 연결을 상징했다. 봉송에는 네팔과 중국 티베트 국경에 있는 에베레스트 산 정상까지 불꽃을 가지고 등반하는 일정도 포함되었는데, 이 등반은 행사를 위해 특별히 중국 측에서 폐쇄되었다.

Q: What was the theme A: "one world, one dream". Q: What was the length of the race? A:

Q: Was it larger than previous ones? A: No Q: Where did the race begin? A: Olympia, Greece Q: Is there anything notable about that place? A: birthplace of Olympic Games Q: Where did they go after? A: Athens

Q: How many days was the race? A: seven

Q: Did they visit any notable landmarks? A: Panathinaiko Stadium Q: And did they climb any mountains? A: Model answer: Everest Turker answers: unknown, yes, Yes, yes

Table 16. Selected CoQA completion.

Context (passage and previous question/answer pairs)

Tom은 54세 비서인 Catherine Green과 어디든 함께 다닌다. 그는 직장에서 그녀의 사무실 주변을 돌아다니고, 그녀와 함께 쇼핑을 간다. Catherine은 Tom이 훌륭하다고 생각하며 "대부분의 사람들은 Tom을 신경 쓰지 않는 것 같아요"라고 말한다. 그녀는 "그는 제 넷째 아이예요"라고 말한다. 그녀는 그를 아들처럼 생각하고 그렇게 대할 수도 있다. 그는 음식을 사고, 의료비를 내고, 세금을 내며 돌아다니지만, 사실 Tom은 개이다.

Catherine과 Tom은 스웨덴에 산다. 스웨덴은 정부가 정한 규칙에 따라 모든 사람이 질서 있는 삶을 살 것으로 기대되는 나라이며, 정부는 국민들에게 높은 수준의 복지를 제공한다. 이러한 복지 수준은 비용이 든다.

스웨덴 사람들은 모든 것에 세금을 내기 때문에, 개를 소유하는 것이 더 많은 세금을 의미한다는 사실에 놀라지 않는다. 어떤 사람들은 개를 키울 권리에 대해 연간 500 스웨덴 크로나에 달하는 세금을 내고 있으며, 이 세금은 정부가 개 병원과 때로는 아픈 개를 위한 의료비로 사용한다. 그러나 대부분의 치료는 비싸기 때문에, 주인들은 종종 개를 위한 건강 보험과 심지어 생명 보험까지 들기로 결정한다.

스웨덴에서는 개 주인이 자신의 개가 일으킨 모든 손해에 대해 비용을 지불해야 한다. 스웨덴 켄넬 클럽 관계자는 이것이 무엇을 의미하는지 설명한다: 만약 당신의 개가 도로로 뛰쳐나가 지나가는 차에 치였다면, 당신은 주인으로서 차에 발생한 모든 손해에 대해 비용을 지불해야 한다. 심지어 당신의 개가 사고로 죽었더라도 말이다.

Q: Catherine은 몇 살인가요? A: 54 Q: 그녀는 어디에 사나요? A: Model answer: Stockholm Turker answers: Sweden, Sweden, in Sweden, Sweden

Table 17. Selected CoQA completion.