VGCI: 글로벌 단서 추론을 통한 약한 지도 비디오 모멘트 검색

Weakly supervised video moment retrieval task에서 기존 mask reconstruction 기반 방법들은 불완전한 정보로 인해 재구성에 혼란을 겪는 문제가 있습니다. VGCI (Variational Global Clue Inference)는 비디오에 해당하는 전체 쿼리 집합으로부터 "global clue"를 모델링하여 이 문제를 해결합니다. 이 global clue를 Gaussian latent variable로 모델링하여 정보 유출 및 노이즈 문제를 방지하고, variational inference를 통해 재구성 과정에 명확한 가이드를 제공합니다. 결과적으로, 모델은 더 정확하고 안정적으로 비디오-쿼리 정렬을 학습하여 비디오 모멘트 검색 성능을 향상시킵니다. 논문 제목: Variational global clue inference for weakly supervised video moment retrieval

Lv, Zezhong, and Bing Su. "Variational global clue inference for weakly supervised video moment retrieval." Knowledge-Based Systems 311 (2025): 113071.

Variational global clue inference for weakly supervised video moment retrieval

Zezhong Lv , Bing Su <br>Gaoling School of Artificial Intelligence, Renmin University of China, No. 59, Zhongguancun Street, Beijing, 100872, China

ARTICLE INFO

Keywords:

비디오 순간 검색 (Video moment retrieval) 변분 추론 (Variational inference) 마스크 재구성 (Mask reconstruction)

Abstract

Weakly supervised video moment retrieval은 비디오-쿼리 쌍 어노테이션만을 사용하여 fine-grained cross-modality alignment를 모델링하는 것을 목표로 하는 도전적인 비디오 이해 task이다. 최근 mask reconstruction 기반 연구들은 유망한 성능을 달성했는데, 이들은 마스킹된 쿼리 및 비디오 세그먼트와 상호작용하여 쿼리를 재구성하고, 재구성 정확도를 기반으로 세그먼트-쿼리 정렬을 측정한다.

그러나 이들은 중요한 문제를 간과한다: 쿼리는 비디오 내 풍부한 의미론의 선택적 요약이라는 점이다. 따라서 두 개의 불완전한 modality만을 기반으로 재구성하는 것은 재구성을 위한 참조 콘텐츠에 대한 혼란을 야기할 수 있으며, 이는 재구성 결과의 매칭 정도 측정으로서의 효과에 영향을 미친다.

이 문제를 해결하기 위해 우리는 비디오에 해당하는 모든 쿼리로 구성된 쿼리 세트(query set)를 기반으로 전역 단서(global clue)의 안내 역할을 밝히고 모델링한다. 구체적으로, 쿼리 세트가 재구성 과정에서 잠재적인 정보 유출을 야기하는 것을 방지하고 노이즈가 있는 어노테이션의 영향을 줄이기 위해, 우리는 전역 단서를 쿼리 세트에 조건화된 가우시안 잠재 변수(Gaussian latent variable)로 모델링한다.

더 나아가, 추론 시에는 쿼리 세트를 사용할 수 없으므로, 우리는 전역 단서에 조건화된 variational inference reconstruction model을 제안하고 해당 **Evidence Lower Bound (ELBO)**를 도출한다. 학습 중에 ELBO와 쿼리 세트 예측기(query set predictor)를 공동으로 최적화함으로써, 우리는 모델이 재구성 오류를 최소화하는 동시에 추론 시 전역 단서 모델링의 기반이 될 더 정확한 쿼리 세트를 생성하도록 유도한다. 광범위한 실험을 통해 우리 방법의 효과를 검증한다.

1. Introduction

Video moment retrieval [1-3]은 **자연어 쿼리(natural language query)**를 기반으로 정제되지 않은(untrimmed) 비디오에서 관련 세그먼트(segment)를 찾아내는 task이다. Fully-supervised video moment retrieval 방법들은 일반적으로 쿼리-세그먼트 수준의 어노테이션을 기반으로 세분화된 cross-modal matching 모델을 설계하며 상당한 발전을 이루었다. 그러나 이러한 정확한 moment 어노테이션은 실제 응용 분야에서 얻기 어려운 경우가 많다. 또한, 일부 연구 [4]에서는 세분화된 moment 어노테이션이 종종 편향(bias)을 포함하여, 이러한 어노테이션에 의존하는 fully supervised 패러다임을 방해할 수 있음을 지적한다. 따라서 비디오-쿼리 페어링 수준의 coarse-grained 학습 데이터만 요구하는 weakly supervised video moment retrieval [5-10]이 제안되었고, 점차 연구의 핵심 주제가 되고 있다.

그러나 정확한 시간적 어노테이션의 부족으로 인해, weakly supervised 환경에서 세그먼트 localization을 위한 세분화된 비디오-쿼리 매칭을 확립하는 것은 weakly supervised video moment retrieval에서 중요한 도전 과제가 된다. fully supervised 환경에서 비디오와 쿼리를 정렬하는 가장 널리 사용되는 패러다임을 상기해보자: **타겟 moment의 시작 및 끝 경계(boundary)를 회귀(regress)**하고, 일련의 후보 세그먼트(candidate segments)를 생성한 다음, 후보 세그먼트와 쿼리 간의 의미론적 관련성(semantic relevance)을 측정하여 타겟 비디오 세그먼트를 결정하는 방식이다. 분명히 weakly supervised 환경에서는 이 패러다임이 더 이상 실현 가능하지 않으며, 특정 시작 및 끝 시간이 없으면 후보 세그먼트와 쿼리 간의 의미론적 관련성을 직접 모델링할 수 없다. 이 문제를 해결하기 위해, weakly supervised video moment retrieval의 최신 연구는 비디오 내에서 hard negative sample [5,6]을 탐색하여 세분화된 contrastive learning을 구축하려고 시도한다. 이는 비디오를 쿼리 관련 부분과 쿼리 비관련 부분으로 나누고, 쿼리 의미 재구성(query semantic reconstruction)을 통해 이러한 비디오 세그먼트와 쿼리 내용 간의 연관성을 측정하는 것을 포함한다: 마스킹된 쿼리가 비디오 세그먼트에 의해 더 정확하게 재구성될수록, 해당 세그먼트는 쿼리와 더 잘 일치하며, 그 반대도 마찬가지이다.

이러한 패러다임이 인상적인 발전을 이루었음에도 불구하고, 다음과 같은 중요한 문제점들을 가지고 있다: 전체 비디오에 대한 설명(여러 쿼리를 포함할 수 있음)은 풍부한 비디오 콘텐츠의 선택적 요약이다. 그러나 intra-sample self-supervised learning 프레임워크에서는 부분적인 비디오(후보 세그먼트)와 문맥 정보가 없는 개별 마스킹된 쿼리를 인식함으로써, 모델은 쿼리에 해당하는 주의 깊은 스토리라인을 거의 포착할 수 없으며, 따라서 쿼리 재구성을 위한 참조 비디오 콘텐츠를 선택할 때 혼란을 겪게 된다.

Fig. 1. 상단: global clue가 모델이 주의를 기울이는 내용을 수정하도록 안내하는 과정을 보여주는 다이어그램. 이 과정에서 'mascot' 및 'show'와 같은 로컬 시각 콘텐츠는 추가 쿼리에 의해 더 이상 초점이 맞춰지지 않는 반면, global clue 'dance'와 관련된 콘텐츠는 여러 번 나타나므로(파란색 삼각형 'dance'로 표시), 관심 영역은 joint space 다이어그램에서 주황색 영역에서 파란색 영역으로 보정되어 "dancing"이라는 단어를 올바르게 재구성할 가능성이 높아진다. 하단: 현재 쿼리 내에서 동일 비디오의 다른 쿼리에서 반복되는 단어(즉, clue semantics)의 비율은 두 데이터셋 모두에서 높은 빈도 분포를 보여, 우리가 제안하는 global clue의 광범위한 존재를 검증한다.

Fig. 1. 상단: global clue가 모델이 주의를 기울이는 내용을 수정하도록 안내하는 과정을 보여주는 다이어그램. 이 과정에서 'mascot' 및 'show'와 같은 로컬 시각 콘텐츠는 추가 쿼리에 의해 더 이상 초점이 맞춰지지 않는 반면, global clue 'dance'와 관련된 콘텐츠는 여러 번 나타나므로(파란색 삼각형 'dance'로 표시), 관심 영역은 joint space 다이어그램에서 주황색 영역에서 파란색 영역으로 보정되어 "dancing"이라는 단어를 올바르게 재구성할 가능성이 높아진다. 하단: 현재 쿼리 내에서 동일 비디오의 다른 쿼리에서 반복되는 단어(즉, clue semantics)의 비율은 두 데이터셋 모두에서 높은 빈도 분포를 보여, 우리가 제안하는 global clue의 광범위한 존재를 검증한다.

Fig. 1에 나타난 바와 같이, 예시 비디오는 파티, 달리기 경주, 치어리더, 군중과 같은 여러 구성 요소를 포함하며, 로컬 세그먼트에는 여러 잠재적인 주의 대상(attentive objects)이 있을 수 있다. 이러한 복잡한 비디오-텍스트 매칭 시나리오에서, 모델이 단순히 로컬 비디오 클립만으로는 마스킹된 쿼리에 해당하는 중요한 콘텐츠를 필터링하기 어렵다. Fig. 1의 예시처럼, 재구성할 쿼리가 "People are <mask> and having fun at a <mask>"일 때, 후보 세그먼트가 실제 정답에 가깝더라도, 모델의 주의 영역은 춤과 파티 관련 콘텐츠에 집중하지 않고, 대신 세그먼트에 나타나는 다른 콘텐츠(예: 이 예시의 쇼와 마스코트)에 의해 방해받을 수 있다.

우리는 이러한 혼란스러운 재구성을 비디오가 제시하는 중복 정보(redundant information) 때문이라고 본다. 쿼리가 제공하는 추상적인 개념들은 이러한 정보를 필터링하여 스토리라인을 형성할 수 있으며, 본 논문에서는 이를 global clue라고 명명한다. 이는 주의를 기울이는 콘텐츠를 더 명확하게 이해하기 위함이다 (반드시 주요 콘텐츠일 필요는 없지만, 쿼리에 의해 도입된 콘텐츠). 이 예시에서 "dance"와 "party"와 관련된 단어들은 다른 쿼리에서도 나타나며, 이는 쿼리 세트가 이러한 콘텐츠를 비디오의 global clue의 일부로 추출한다는 것을 나타낸다. 한편, 'mascot'과 같은 로컬 시각 콘텐츠는 다른 쿼리에 의해 더 이상 초점이 맞춰지지 않으므로, 모델이 인식하는 관심 영역은 "dance" 관련 영역으로 보정되어 "dancing"이라는 단어를 올바르게 재구성할 가능성이 높아진다. 우리는 하나의 비디오에 해당하는 모든 쿼리에서 반복되는 동일한 의미(단어)의 비율을 계산했으며, 이는 Fig. 1의 하단 부분에 나타나 있다. 두 데이터셋 모두에서 이러한 반복이 자주 발생하며, 이는 이러한 "global clue"의 광범위한 존재를 보여준다.

이러한 global clue를 모델링하고 쿼리 재구성의 기반으로 도입하기 위해, 우리는 Variational Global Clue Inference (VGCI) 모델을 제안한다. 구체적으로, 우리는 마스킹된 쿼리 재구성의 self-supervised task를 인과적 관점(causal perspective)에서 재구성하여, global clue가 재구성 결과에 미치는 잠재적 영향을 탐색한다. 이를 위해 우리는 전체 비디오에 대한 쿼리 세트를 예측하고 이 예측을 기반으로 global clue를 근사화하도록 학습하는 cross-modality interaction 모듈을 설계한다. 더 나아가, global clue가 잠재적 어노테이션 노이즈와 일관성을 유지하고, 쿼리 세트에 의해 유도되는 정보 유출(information leaking)을 방지하기 위해, 우리는 global clue를 잠재 가우시안 변수(latent Gaussian variable)로 모델링할 것을 제안한다.

우리는 우리의 동기가 대부분의 최신 연구를 뒷받침하는 재구성 기반 self-supervised learning 프레임워크를 개선하여, 비디오 세그먼트와 쿼리 간의 정렬을 더 정확하게 측정하는 데 있음을 강조한다. 우리의 목표는 단순히 재구성 정확도를 높이는 것이 아니라, 쿼리와 높은 의미론적 관련성을 가진 비디오 세그먼트가 더 정확한 쿼리 재구성을 유도하고, 그 반대도 마찬가지임을 보장하는 것이다.

본 논문의 주요 기여는 다음과 같다:

-

우리는 weakly supervised video moment retrieval에서 쿼리 재구성의 self-supervised learning 기법을 새로운 인과적 관점에서 검토하고, 재구성 과정에서 global clue의 인과적 효과(causal effect)를 밝힌다.

-

포착된 global clue가 노이즈가 있는 어노테이션과 일관성을 유지하고, 쿼리 세트로부터 쿼리 재구성으로 정보가 유출되는 것을 방지하기 위해, 우리는 재구성에 대한 global clue의 인과적 효과를 가우시안 잠재 변수로 모델링할 것을 제안한다.

-

우리는 학습 중 쿼리 세트를 예측하는 능력을 최적화함으로써, 추론 단계에서 ground truth 쿼리 세트 없이 예측된 쿼리 세트를 기반으로 global clue를 효과적으로 추정할 수 있는 변분 추론(variational inference) 모델을 제안한다.

-

우리는 제안된 방법의 효과를 검증하기 위해 광범위한 실험을 수행한다.

2. Related work

2.1. Weakly supervised video moment localization

Weakly supervised video-text localization는 학습 단계에서 모델이 비디오-쿼리 수준의 coarse-grained 어노테이션만 접근 가능하고, 정확한 temporal 어노테이션은 얻을 수 없는 시나리오를 의미한다. 정확한 비디오-텍스트 정렬(alignment) 감독 신호의 부족으로 인해, 후보 비디오 세그먼트와 쿼리 간의 정렬을 모델링하는 것이 weakly supervised video-text alignment의 핵심 문제가 된다. 기존의 weakly supervised video-text localization 방법들은 cross-modal alignment를 모델링하는 접근 방식에 따라 두 가지 패러다임으로 분류할 수 있다: similarity-based와 masked reconstruction-based이다.

Similarity-based 접근 방식 [11-16]의 핵심 아이디어는 비디오와 텍스트 간의 매칭 관계를 활용하여 긍정 및 부정 샘플을 식별하는 multiple-instance learning 프레임워크를 설계하는 것이다. 궁극적으로 이는 cosine similarity 또는 학습 가능한 매칭 점수(matching scores)를 기반으로 하는 contrastive learning 프레임워크를 구축하여 잘 정렬된 cross-modality 표현 공간을 찾는 것을 목표로 한다. 예를 들어, TGA는 쿼리 기반 attention을 사용하여 전역 비디오 표현을 학습하고, 시각 및 텍스트 feature를 공동 표현 공간(joint representation space)으로 투영한다. 그런 다음, 긍정 샘플의 매칭 점수를 최대화하고 부정 샘플의 매칭 점수를 최소화함으로써 비디오 수준의 시각-텍스트 정렬을 학습한다. 이러한 coarse-grained 정렬 모델링 접근 방식은 WSTAN [12] 및 LoGAN [13]과 같은 연구에서 더욱 정교하게 다듬어졌다. 이들 접근 방식은 비디오와 쿼리의 내용 및 그 관계를 더 완벽하게 탐색하기 위해 finer-grained cross-modal interaction 방법을 제안한다. CRM [14]은 비디오-텍스트 유사성 방법론을 기반으로 하는 가장 대표적인 연구 중 하나이다. 이 연구는 동일한 비디오에 해당하는 단락 내 쿼리들 간의 관계를 명시적으로 모델링하고, 비디오 내에서 서로 다른 의미 정보를 포함하는 세그먼트들 간의 시간적 관계를 탐색한다. 우리 방법과 CRM의 주요 차이점은, 우리 연구는 비디오에 해당하는 여러 쿼리의 시퀀스를 요구하지 않는다는 점이다. 대신, 이러한 쿼리들을 전체(whole)로 간주하여 비디오-텍스트 상호작용을 안내하는 전역 단서(global clues)로 활용함으로써, 쿼리를 보다 포괄적으로 재구성한다.

Similarity-based 방법들은 주로 비디오와 텍스트 간의 유사성을 기반으로 모델이 cross-modal alignment를 구축하도록 돕는 보조 task를 설계하는 데 중점을 둔다. 그러나 서로 다른 modality의 표현 간 유사성을 측정할 때, 유사성은 필연적으로 modality 간의 내재적인 간극(inherent gap)에 의해 영향을 받는다.

2.2. Query mask reconstruction based weakly supervised methods

유사도 기반 방법의 단점을 해결하기 위해 masked reconstruction 기반 방법들이 제안되었다. 이러한 방법들 [5-10]은 비디오 세그먼트와 쿼리 간의 매칭 정도를 cross-modal alignment 모델링의 근본적인 목적에 부합하는 방식으로 암묵적으로 측정한다. 이 방법들의 핵심 패러다임은 쿼리 내용의 일부를 마스킹한 다음, 비디오 후보 세그먼트와 마스킹된 쿼리 간의 상호작용을 통해 마스킹된 쿼리를 재구성하고, 재구성 손실(reconstruction loss)을 사용하여 후보 비디오 세그먼트와 쿼리 간의 유사도를 측정하는 것이다.

**SCN [17]**은 이 아이디어를 비디오-텍스트 localization task에 처음 적용했다. **CNM [6]**과 **CPL [5]**은 masked reconstruction 패러다임을 사용하는 가장 대표적인 연구로, end-to-end 학습 방법과 더 어려운 negative sample 탐색을 처음으로 제안했다. **IRON [7]**은 사전학습된 vision-language model을 기반으로 후보 세그먼트를 반복적으로 업데이트하는 모듈을 제안한다. **PPS [10]**는 학습 가능한 proposal fusion 모듈을 도입하여 후보 비디오 proposal 생성 전략을 개선한다. **UGS [9]**는 데이터 증강(data augmentation) 기반의 teacher-student 상호 학습 프레임워크를 설계한다. **SCANet [8]**은 동일한 비디오에 해당하는 여러 쿼리를 검토하여 비디오 장면의 다양성을 측정하고, 이 장면 다양성을 기반으로 생성되는 후보 세그먼트의 수를 안내하는 방식을 제안한다.

장면 복잡도에 대한 휴리스틱한 명시적 측정(heuristic explicit measures)을 직접 설계하는 SCANet과 달리, 우리의 방법은 여러 쿼리를 학습 가능한 암묵적인 전역 단서(implicit global clues)로 모델링하여 쿼리 재구성을 안내한다.

2.3. Causal modeling for multi-modality learning

다양한 멀티모달 학습 task에서 **인과 모델링(causal modeling)**은 데이터셋 내의 불균등한 어노테이션 분포로 인해 발생하는 편향된 추론(biased inference) 문제를 완화하고, 여러 모달리티와 단계에 걸쳐 더 안정적인 추론 관계를 구축하는 데 도움을 준다. Visual Question Answering (VQA) task에서 **CFVQA [18]**는 **반사실적 지식 융합(counterfactual knowledge fusion)**을 설계하여 데이터셋의 편향된 질문-답변 패턴이 질문-답변 추론에 미치는 영향을 줄인다. **VIC [19]**는 설명(explanation)에서 답변(answer)으로 이어지는 front-door path를 추가하여 더 일관된 설명-답변 추론을 확립한다. **IVG [20]**는 **인과적 개입(causal intervention)**을 통해 비디오 모먼트 검색(video moment retrieval) 데이터셋에서 객체 이름 어노테이션의 불균등한 분포가 타겟 세그먼트 지역화(target segment localization)에 미치는 영향을 줄인다. **CCL [15]**은 미니 배치 내에 휴리스틱 메모리 뱅크(heuristic memory bank)를 설계하여 **후보 세그먼트 생성(candidate segment generation)을 위한 반사실적 대조 학습(counterfactual contrastive learning)**을 제안한다. 이러한 연구들과 달리, 우리가 제안하는 방법은 이전에 간과되었던 완전한 비디오와 텍스트가 쿼리 재구성(query reconstruction)에 미치는 영향을 탐색하고, 이를 기반으로 더욱 견고한 쿼리 재구성을 구축하는 것을 목표로 한다.

3. Method

이 섹션에서는 먼저 인과 관계(causality)의 새로운 관점에서 query mask reconstruction task를 검토하여, 소위 global clue가 query reconstruction에 미치는 숨겨진 **인과적 효과(causal effects)**를 밝혀낸다. 그런 다음, global clue의 모델링을 상세히 설명하고, 새롭게 제안된 variational global clue aware query reconstruction process를 위한 **최적화 목표(optimization objectives)**를 도출한다. 마지막으로, variational global clue inference를 query reconstruction 기반 self-supervised learning framework에 통합하여 비디오와 텍스트 간의 더욱 정확한 alignment를 촉진한다.

3.1. Causal view of query mask-reconstruction

Masked reconstruction of queries는 weakly supervised video moment retrieval [5, 17]에서 비디오와 텍스트 간의 fine-grained alignment를 효과적으로 모델링하는 self-supervised learning 방법이다. 본 논문에서는 이를 structural causal model (SCM) [21] 관점에서 재검토하고자 한다.

Fig. 2(a)에서 보듯이, 기존 연구에서의 query reconstruction 과정은 비디오 와 쿼리 , 그리고 각각의 **마스크 와 **를 cross-modal interaction model에 입력하여 쿼리를 재구성하는 방식으로 설명될 수 있다. 비디오와 쿼리에 대한 마스크의 역할은 각각 비디오 후보 세그먼트 생성과 쿼리 내 단어 마스킹이다. 따라서 query reconstruction에는 부분적인 비디오 및 텍스트 정보만 실제로 관여하게 되며, 이는 모델이 완전한 비디오와 그에 상응하는 여러 쿼리에 내재된 전역적인 의미 단서(global semantic clues)를 인지하지 못하게 하여, query reconstruction 과정에서 혼란을 겪게 만든다.

이 문제를 해결하는 가장 간단한 방법은 Fig. 2(b)에 나타난 것처럼 query set을 재구성 과정에 직접 도입하는 것이다. Section 1에서 분석했듯이, 이 방식의 근거는 query set이 어느 정도 비디오 내의 완전한 스토리라인을 나타낸다는 점이다. 따라서 query set은 재구성 과정을 안내하는 전역 단서(global clue)의 프록시(proxy)로 간주될 수 있으며, 이는 재구성의 안정성을 높여 self-supervised learning의 효과를 증진시킨다.

그러나 query set을 query reconstruction의 조건으로 직접 도입하는 방식은 다음과 같은 세 가지 문제를 가지고 있다:

- 정보 유출 위험 (Information leakage risk): query set은 재구성될 쿼리의 내용을 포함하고 있으므로, 이를 재구성 과정에 직접 도입하면 정보 유출의 위험이 있어 self-supervised learning의 효율성을 저해한다.

- 노이즈에 민감 (Sensitive to noise): 데이터셋에는 특정 순간에 대한 반복적인 어노테이션과 같은 문제가 널리 퍼져 있으며, 이는 query set이 전역 단서를 직접적으로 표현하는 능력을 약화시킨다.

Fig. 2. 쿼리 마스크 재구성의 다양한 방식에 대한 SCM과 그 최적화 목적 함수 가능도.

(a) 기존 연구에서의 쿼리 재구성. 비디오 , 비디오 마스크 (후보 제안을 나타냄), 쿼리 , 쿼리 마스크 가 cross-modality 모델에 입력되어 재구성된 쿼리 를 생성한다. 이 SCM에서는 두 modality 모두에서 제한된 receptive field로 인해 모델이 비디오 내의 attentive content에 대해 혼란을 겪을 수 있다.

(b) 한 가지 직접적인 방법은 특정 비디오의 모든 쿼리로 구성된 query set 를 재구성 과정의 새로운 조건으로 도입하는 것이다. 그러나 이 모델은 쿼리 어노테이션의 노이즈에 민감하며 정보 유출의 위험을 초래한다. 또한, 추론 시에는 query set을 사용할 수 없다.

(c) 이러한 문제들을 극복하기 위해, 우리는 query set으로부터 파생된 Gaussian 잠재 변수 로 전역 단서(global clue)를 모델링한다. 또한, cross-modality interaction 모듈을 최적화하여 query set 를 예측하고, 이를 추론 시 전역 단서의 사후 분포를 근사하는 데 사용한다.

Fig. 2. 쿼리 마스크 재구성의 다양한 방식에 대한 SCM과 그 최적화 목적 함수 가능도.

(a) 기존 연구에서의 쿼리 재구성. 비디오 , 비디오 마스크 (후보 제안을 나타냄), 쿼리 , 쿼리 마스크 가 cross-modality 모델에 입력되어 재구성된 쿼리 를 생성한다. 이 SCM에서는 두 modality 모두에서 제한된 receptive field로 인해 모델이 비디오 내의 attentive content에 대해 혼란을 겪을 수 있다.

(b) 한 가지 직접적인 방법은 특정 비디오의 모든 쿼리로 구성된 query set 를 재구성 과정의 새로운 조건으로 도입하는 것이다. 그러나 이 모델은 쿼리 어노테이션의 노이즈에 민감하며 정보 유출의 위험을 초래한다. 또한, 추론 시에는 query set을 사용할 수 없다.

(c) 이러한 문제들을 극복하기 위해, 우리는 query set으로부터 파생된 Gaussian 잠재 변수 로 전역 단서(global clue)를 모델링한다. 또한, cross-modality interaction 모듈을 최적화하여 query set 를 예측하고, 이를 추론 시 전역 단서의 사후 분포를 근사하는 데 사용한다.

- 추론 시 사용 불가 (Not available in inference): query set은 추론 시 접근할 수 없다.

이러한 문제들을 해결하기 위해, 우리는 전역 단서(global clue)에 대한 다음 세 가지 모델링 원칙을 각각 설계한다:

- 잠재 형태 (Latent form): 전역 단서가 잠재 공간에서 재구성에 개입하여, query reconstruction 과정에서 query set으로부터의 정보 유출을 방지하고자 한다. 따라서 우리는 전역 단서를 잠재 변수(latent variable)로 모델링한다.

- 간결성 (Conciseness): query set이 관심을 갖는 비디오 콘텐츠의 가장 고수준 의미를 표현하여, 학습 시 레이블된 query set의 노이즈로부터 직접적인 영향을 피하는 것을 목표로 한다. 따라서 우리는 전역 단서를 Gaussian 기반의 학습 가능한 토큰(learnable token)으로 모델링한다.

- 변분 추론 기반 (Variational inference based): 학습 단계에서는 ground truth 에 따라 query set predictor를 최적화한다. 따라서 추론 단계에서는 예측된 query set 를 통해 전역 단서 를 추정할 수 있다.

이러한 원칙들을 바탕으로, 우리는 Fig. 2(c)에 제시된 **변분 전역 단서 추론 모델(variational global clue inference model)**을 제안한다.

요약하자면, 우리는 query reconstruction에 간결하고 견고한 고수준 가이드를 제공하기 위해 query set 어노테이션이 필요 없는 전역 단서 추론 모델을 제안한다.

3.2. Optimization for global clue aware reconstruction

Section 3.1에서 논의했듯이, 우리는 **전역 단서(global clue)**를 다변량 가우시안 분포를 따르는 잠재 변수 로 모델링할 것을 제안한다.

이는 Figure 2(b)에서처럼 쿼리 세트를 재구성 과정에 직접 통합하는 대신, 쿼리 세트로부터 파생된 분포이다. 여기서 이고 는 항등 행렬이다. 이 접근 방식은 정보 유출을 효과적으로 방지하고, 쿼리 세트 어노테이션에 포함될 수 있는 잠재적 노이즈가 모델에 미치는 영향을 줄인다. 쿼리 재구성 과정에 의 인과적 효과를 도입함으로써, 우리는 제안하는 global clue aware reconstruction model의 Evidence Lower Bound (ELBO) [22]를 다음과 같이 유도할 수 있다.

여기서 와 는 각각 **global clue의 근사된 사후 분포(approximated posterior distribution)**와 **실제 사후 분포(true posterior distribution)**를 나타낸다.

Figure 1의 예시를 다시 상기해보면, (2)의 첫 번째 항은 쿼리 내의 "dance"가 마스킹되었을 때, dance-dominant global clue를 통합하여 비디오-쿼리 융합 지식 재구성을 유도함을 나타낸다. KLD 항의 경우, 는 본 논문에서 쿼리 세트 가 global clue를 암시한다는 가정에 따라 특정 쿼리-비디오 쌍이 주어졌을 때 결정된다.

여기서 는 특정 비디오-쿼리 쌍이 주어졌을 때 쿼리 세트가 일 사후 확률을 나타내며, 일 때 1이고 다른 에 대해서는 0이다. Figure 1의 예시에서 제시된 바와 같이, 이 비디오의 모든 쿼리로 구성된 쿼리 세트에는 "dance"라는 단서가 있으며, 이는 쿼리에 따라 비디오의 주의 깊은 내용에 해당한다. (3)의 원리는 쿼리 세트를 기반으로 dance-dominant global clue를 포착하는 것을 목표로 한다. 유사하게, 학습 단계에서는 특정 비디오-쿼리 쌍을 기반으로 예측된 쿼리 세트로부터 dance-dominant global clue가 추출된다. 결과적으로 는 다음과 같이 근사된다.

여기서 는 마스킹되지 않은 비디오와 쿼리를 기반으로 cross-modality decoder에 의해 예측된 쿼리 세트이다.

Fig. 3. 학습 및 추론 중 데이터 흐름 및 출력 변수 다이어그램. 먼저, 쿼리 세트 예측기는 주어진 비디오의 쿼리 세트를 예측하고 예측 손실을 최소화한다. 학습 중, global clue 생성기는 ground truth 및 예측된 쿼리 세트로부터 global clue를 동시에 추출하며, 우리는 전자를 쿼리 재구성에 통합한다. 또한, 우리는 이들의 분포 간 KLD와 재구성 손실을 최소화한다. 추론 단계에서는 예측된 쿼리 세트만 사용하여 global clue를 추출하고, 이를 재구성을 유도하는 데 활용한다.

Fig. 3. 학습 및 추론 중 데이터 흐름 및 출력 변수 다이어그램. 먼저, 쿼리 세트 예측기는 주어진 비디오의 쿼리 세트를 예측하고 예측 손실을 최소화한다. 학습 중, global clue 생성기는 ground truth 및 예측된 쿼리 세트로부터 global clue를 동시에 추출하며, 우리는 전자를 쿼리 재구성에 통합한다. 또한, 우리는 이들의 분포 간 KLD와 재구성 손실을 최소화한다. 추론 단계에서는 예측된 쿼리 세트만 사용하여 global clue를 추출하고, 이를 재구성을 유도하는 데 활용한다.

(3)과 (4)를 (2)에 통합하면, 우리의 변분 global clue aware reconstruction 에 대한 최적화 목표를 다음과 같이 유도할 수 있다.

(5)에서 나타난 바와 같이, global clue에 추가적으로 조건화된 재구성 손실을 최소화하는 것 외에도, 우리는 ground truth 쿼리 세트와 예측된 쿼리 세트로부터 얻은 global clue 분포 간의 Kullback-Leibler Divergence (KLD)도 최소화한다.

Figure 2(c)에 설명된 SCM을 상기하면, 우리는 쿼리 재구성(query reconstruction)과 쿼리 세트 예측(query set prediction)을 공동으로 최적화한다. 따라서 우리는 주어진 쿼리와 해당 전체 비디오를 기반으로 쿼리 세트를 예측하기 위해 cross-modality prediction model도 최적화한다.

마지막으로, (5)와 (6)을 기반으로 우리의 변분 global clue aware reconstruction에 대한 전체 학습 목표를 얻을 수 있다.

제안하는 모델의 방법론에 대한 보다 직관적인 이해를 돕기 위해, Figure 3에 학습 및 추론 중 데이터 흐름 다이어그램을 제시한다. 이 그림에서 우리는 VGCI 모델에 의해 최적화되는 중요한 목표들의 방법론을 설명하고, 학습 및 추론 단계 간의 데이터 흐름과 출력 변수를 구분하여 보여준다.

3.3. Variational global clue inference model

이 하위 섹션에서는 제안된 변분 전역 단서 추론 모델(variational global clue inference model) 의 구현을 자세히 설명한다. Fig. 4에 나타난 바와 같이, 비디오와 쿼리 쌍이 주어졌을 때, 사전학습된 모델을 통해 비디오(후보 제안 및 전체 비디오 포함) 및 쿼리 feature가 추출되고, 이어서 두 개의 선형 레이어 와 에 의해 공동 표현 공간(joint representation space) 인 및 로 각각 투영된다. 여기서 은 feature 시퀀스의 길이이고, 는 hidden dimension이다.

우리는 쿼리가 주어졌을 때, 쿼리가 초점을 맞추는 전체 비디오 내의 스토리라인을 추론할 수 있으며, 이 스토리라인은 쿼리 집합과 어느 정도 관련이 있다고 가정한다. 이 가정을 바탕으로, 우리는 비디오와 현재 쿼리를 입력으로 받아 비디오에 대한 해당 쿼리 집합을 예측하는 cross-modal autoregressive decoder (CMDecoder) 를 제안한다.

여기서 는 hidden feature를 어휘 공간으로 다시 매핑하는 데 사용되는 선형 레이어이다. 우리는 실제로 CMDecoder를 구현하기 위해 여러 방식을 시도한다. 자세한 내용과 해당 평가는 Section 4.3에 있다. 학습 중에는 CMDecoder가 생성한 예측을 감독하기 위해 ground truth 쿼리 집합 를 활용하며, 이는 (6)의 에 따라 수행된다.

여기서 는 cross entropy loss를 나타낸다.

원래 쿼리 집합 와 예측된 쿼리 집합 를 기반으로 Gaussian global clue의 평균과 분산을 포착하기 위해, 우리는 다음과 같은 Global Clue Mining Module을 설계한다.

여기서 이고, 는 연결(concatenation) 을 나타내며, 는 클래스 토큰(class token) 이다. 는 쿼리 집합을 문맥화(contextualizing)하기 위한 Transformer [23]이며, 와 는 Gaussian 분포 파라미터 선형 예측기이다. gradient가 역전파될 수 있도록 보장하기 위해, 우리는 학습 중에 재매개변수화 기법(reparametrization technique) 을 사용하여 global clue 의 최종 표현을 얻는다.

쿼리 재구성 과정에 global clue를 도입하기 위해, 우리는 중간 재구성 결과와 중복된 global clue를 주입하고, 프로젝터 를 활용하여 정류된 재구성(rectified reconstruction) 을 수행한다.

여기서 마스킹된 쿼리 feature 는 쿼리이고, 비디오 제안 feature 는 cross-attention reconstruction Transformer 에서 key와 value 모두에 해당하며, 는 어휘의 크기이다. 결과적으로, 우리는 (7)에서 global clue를 인지하는 재구성 손실(global clue aware reconstruction loss) 을 다음과 같이 분석적으로 계산할 수 있다.

여기서 는 행렬의 trace를 나타내고, 및 이다. 이 닫힌 형식 해(closed-form solution) 의 자세한 유도는 Appendix에 제공된다.

red.

red.

3.4. Training and inference

우리가 제안하는 방법은 기존의 모든 query reconstruction 기반 접근 방식에 통합되어 더욱 신뢰할 수 있고 해석 가능한 video-query alignment를 달성할 수 있다. 본 논문에서는 기성(off-the-shelf) 모델인 PPS [10]를 선택하고, 공식 저장소 [24]에 따라 재현하여 우리의 baseline으로 사용하였다.

PPS는 먼저 Gaussian mixture 기반의 후보 proposal들을 긍정 샘플(positive samples)로 예측하고, 이들의 재구성 손실(reconstruction losses)을 최소화한다. 그런 다음, 비디오 내에서 어려운 부정 샘플(difficult negative samples)을 발굴하고, 긍정 및 부정 샘플 모두의 재구성 오류에 hinge loss를 적용한다.

PPS의 주요 학습 손실은 다음과 같다:

- 긍정 샘플 재구성 손실

- 긍정-부정 샘플 contrastive loss

- 후보 세그먼트에 대한 제약

우리의 방법을 통합하더라도 baseline에서 사용되는 원래 학습 손실의 공식화에는 영향을 미치지 않는다. 이는 우리의 손실 함수가 긍정 proposal에 의해 생성된 재구성 손실만을 수정하기 때문이다.

요약하면, 우리의 학습 손실은 **global clue aware reconstruction loss (13)**와 **query set prediction loss (9)**를 baseline의 손실에 통합하여 다음과 같이 공식화된다:

본 논문의 주요 평가 실험에서, 는 파라미터 탐색 실험(Section 4.3 참조) 후 0.5로 설정되었으며, 다른 가중치들은 baseline과 동일하다. 학습 및 추론에 사용되는 query set의 길이는 최대 60이며, 이들은 순서가 없다(unordered). PPS에 대한 더 자세한 내용은 해당 논문 [10]과 공식 저장소 [24]에서 확인할 수 있다.

추론 시, 우리는 먼저 예측된 query set 를 얻고, global clue의 평균 를 기반으로 masked query를 재구성한다. 이는 Normalized Weighted Geometric Mean (NWGM) 근사 [25]에 따라 다음과 같이 표현된다:

결과적으로, 가장 낮은 재구성 오류를 가진 후보 proposal이 목표 비디오 세그먼트의 최종 예측으로 선택된다.

4. Experiment

4.1. Datasets and evaluation metrics

이전 연구들 [5,6]에 따라, 우리는 제안하는 방법을 Charades-STA [34]와 ActivityNet-Captions [35] 데이터셋에서 " " 지표를 사용하여 평가한다. 여기서 이고, 값은 Charades-STA의 경우 , ActivityNet-Captions의 경우 이다.

ActivityNet-Captions. ActivityNet-Captions 데이터셋 [35]은 19,209개의 비디오로 구성되어 있으며, 평균 비디오 길이는 117.6초이다. [5,6]의 방식을 따라, 우리는 이 데이터셋을 학습, 검증, 테스트 세트로 나누었으며, 각각 37,417개, 17,505개, 17,031개의 비디오-쿼리 쌍을 포함한다.

Charades-STA. Charades-STA 데이터셋 [34]은 6672개의 비디오에서 파생된 16,128개의 비디오-쿼리 쌍으로 구성되어 있으며, 평균 비디오 길이는 29.96초이다. [5,6]의 방식에 따라, 우리 모델은 12,408개의 비디오-쿼리 쌍을 포함하는 학습 세트로 훈련되었고, 3720개의 비디오-쿼리 쌍으로 구성된 테스트 세트에서 성능이 평가되었다.

4.2. Comparison with state-of-the-arts

우리는 최신 mask reconstruction 기반 SOTA 방법인 PPS [24]를 baseline으로 재현하고 동일한 하이퍼파라미터를 유지하였다. Table 1과 2에서 볼 수 있듯이, 우리의 방법은 다양한 metric에서 baseline보다 크게 향상된 성능을 보인다.

약지도 비디오 모먼트 검색(weakly supervised video moment retrieval)에서 제안된 VGCI 방법론의 적용 가능성을 추가로 검증하기 위해, 추가적인 데이터 증강(data augmentation) 또는 사전학습된 모델을 활용하여 성능을 향상시킨 최신 SOTA 방법들 [7, 9]을 비교 결과에 참고 자료로 포함하였다. Table 1과 2에서 볼 수 있듯이, 우리의 VGCI는 데이터 증강 [9] 및 대규모 사전학습된 vision-language model [7]을 활용하는 이러한 SOTA 방법들과 비교할 만한 수준에 도달한다.

Table 1 Charades-STA에서의 성능 비교. 가장 좋은 결과는 굵게 표시되어 있다.

| Methods | R@1 | R@5 | ||||

|---|---|---|---|---|---|---|

| TGA [11] | 32.14 | 19.94 | 8.84 | 86.58 | 65.52 | 33.51 |

| CTF [26] | 39.8 | 27.3 | 12.9 | - | - | - |

| SCN [17] | 42.96 | 23.58 | 9.97 | 95.56 | 71.8 | 38.87 |

| WSTAN [12] | 43.39 | 29.35 | 12.28 | 93.04 | 76.13 | 41.53 |

| VLANet [27] | 45.24 | 31.83 | 14.17 | 95.7 | 82.85 | 33.09 |

| LoGAN [13] | 48.04 | 31.74 | 13.71 | 89.01 | 72.17 | 37.58 |

| MARN [28] | 48.55 | 31.94 | 14.81 | 90.70 | 70.00 | 37.40 |

| WSRA [29] | 50.13 | 31.20 | 11.01 | 86.75 | 70.50 | 39.02 |

| CCL [15] | - | 33.21 | 15.68 | - | 73.50 | 41.87 |

| CRM [14] | 53.66 | 34.76 | 16.37 | - | - | - |

| VCA [30] | 58.58 | 38.13 | 19.57 | 98.08 | 78.75 | 37.75 |

| LCNet [16] | 59.60 | 39.19 | 18.87 | 94.78 | 80.56 | 45.24 |

| RTBPN [31] | 60.04 | 32.36 | 13.24 | 97.48 | 71.85 | 41.18 |

| CNM [6] | 60.39 | 35.43 | 15.45 | - | - | - |

| CPL [5] | 65.99 | 49.05 | 22.61 | 96.99 | 84.71 | 52.37 |

| SCANet [8] | 68.04 | 50.85 | 24.07 | 98.24 | 86.32 | 53.28 |

| IRON [7] | 70.71 | 51.84 | 25.01 | 98.96 | 86.80 | 54.99 |

| UGS [9] | 69.16 | 52.18 | 23.94 | - | - | - |

| Baseline [24] | 67.95 | 49.46 | 25.52 | 98.54 | 86.26 | 51.55 |

| Ours |

cross-modal alignment를 용이하게 하기 위해 사전학습된 대규모 vision-language model을 사용한다. teacher-student 상호 학습을 달성하기 위해 weak-strong data augmentation을 활용한다.

Table 2 ActivityNet Captions에서의 성능 비교. 가장 좋은 결과는 굵게 표시되어 있다.

| Methods | R@1 | R@5 | ||||

|---|---|---|---|---|---|---|

| CTF [26] | 74.2 | 44.3 | 23.6 | - | - | - |

| WS-DEC [32] | 62.71 | 41.98 | 23.34 | - | - | - |

| MARN [28] | - | 47.01 | 29.95 | - | 72.02 | 57.49 |

| SCN [17] | 71.48 | 47.23 | 29.22 | 90.88 | 71.56 | 55.69 |

| RTBPN [31] | 73.73 | 49.77 | 29.63 | 93.89 | 79.89 | 60.56 |

| WSLLN [33] | 75.4 | 42.8 | 22.7 | - | - | - |

| CCL [15] | 50.12 | 31.07 | - | 77.36 | 61.29 | |

| WSTAN [12] | 79.78 | 52.45 | 30.01 | 93.15 | 79.38 | 63.42 |

| CRM [14] | 81.61 | 55.26 | 32.19 | - | - | - |

| CNM [6] | 78.13 | 55.68 | 33.33 | - | - | - |

| VCA [30] | 67.96 | 50.45 | 31.00 | 92.14 | 71.79 | 53.83 |

| LCNet [16] | 78.58 | 48.49 | 26.33 | 93.95 | 82.51 | 62.66 |

| CPL [5] | 82.55 | 55.73 | 31.37 | 87.24 | 63.05 | 43.13 |

| SCANet [8] | 83.62 | 56.07 | 31.52 | 94.36 | 82.34 | 64.09 |

| IRON [7] | 84.42 | 58.95 | 36.27 | 96.74 | 85.60 | 68.52 |

| UGS [9] | 82.10 | 58.07 | 36.91 | - | - | - |

| Baseline [24] | 82.34 | 58.83 | 31.37 | 95.14 | 84.18 | 68.69 |

| Ours |

cross-modal alignment를 용이하게 하기 위해 사전학습된 대규모 vision-language model을 사용한다. teacher-student 상호 학습을 달성하기 위해 weak-strong data augmentation을 활용한다.

Table 3 다양한 query set predictor인 CMDecoder에 대한 ablation study. Recon: Reconstruction 방식, Prompt: Prompt 예측, Autoreg: Autoregressive decoder. RkIm은 R@5,IoU 을 나타내고, IT는 각 query에 대한 추론 시간(ms)을, TT는 각 epoch에 대한 학습 시간(min)을 나타낸다.

| CMDecoder | Charades-STA | ActivityNet Captions | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| R1I5 | R1I7 | IT | TT | FLOPs | R1I1 | R1I3 | IT | TT | FLOPs | |

| Baseline | 49.46 | 25.52 | 14 | 1.3 | 5.6e10 | 82.34 | 58.83 | 22 | 6.3 | 1.2e11 |

| Recon | 48.11 | 23.90 | 16 | 1.4 | 6.2e10 | 80.74 | 56.52 | 29 | 6.5 | 1.4e11 |

| Prompt | 47.96 | 24.01 | 31 | 2.1 | 1.5e11 | 81.87 | 57.19 | 53 | 8.8 | 2.9e11 |

| Autoreg | 50.71 | 25.84 | 26 | 1.9 | 1.2e11 | 83.95 | 58.92 | 45 | 8.1 | 2.7e11 |

4.3. Ablation study

4.3.1. Different query set prediction models

우리는 query set prediction 모델을 학습하고 구현하는 세 가지 방식을 설계했으며, 해당 평가 결과는 Table 3에 제시되어 있다.

A. Reconstruction 방식. query mask reconstruction 방법론과 유사하게, 우리는 query 내 단어의 2/3를 query set에서 샘플링된 무작위 단어로 대체하고, 다른 query들의 단어를 마스킹하여 이를 기반으로 global clue를 도출하도록 재구성한다. 이 방식은 "query set"을 한 단계에서 예측하므로 가장 빠른 추론 속도를 달성한다. 그러나 예상했던 대로 성능은 가장 좋지 않았다. 가능한 이유는 무작위 대체가 query의 원래 의미와 문맥 정보를 방해했기 때문일 수 있다.

Table 4 query set의 최대 시퀀스 길이(Max Length)에 대한 Ablation. ms/Q는 각 query에 대한 추론 시간을 나타낸다. 가장 좋은 결과는 굵게 표시되어 있다.

| Max length | Charades-STA | Activitynet Captions | ||||||

|---|---|---|---|---|---|---|---|---|

| ms/Q | R1I3 | R1I5 | R1I7 | ms/Q | R1I1 | R1I3 | R1I5 | |

| 20 | 19 | 68.40 | 49.51 | 25.61 | 30 | 82.67 | 58.85 | 31.41 |

| 40 | 23 | 68.65 | 49.76 | 25.68 | 37 | 83.20 | 58.89 | 31.52 |

| 60 | 26 | 69.15 | 50.71 | 25.84 | 45 | 83.95 | 58.92 | 31.55 |

| 80 | 31 | 68.89 | 49.83 | 25.75 | 58 | 83.49 | 58.84 | 31.54 |

B. Autoregressive decoder. 이 구현에서는 완전한 비디오 및 query feature를 연결하고, 이를 autoregressive decoder에 입력하여 query set을 단어별로 예측한다.

C. Prompt prediction. B를 기반으로, 우리는 현재 query를 query set의 prefix로 사용하여 query set의 복잡한 분포를 학습하는 어려움을 줄이려고 시도했다. 불행히도, 이는 성능 저하로 이어졌다. 우리의 분석에 따르면, 이는 global clue의 정의에 따라 동일한 비디오에 해당하는 다른 query들로부터 모델링될 때 global clue가 일관되어야 하기 때문이다. 이 구현은 그 원칙을 위반한다.

또한, 우리는 NVIDIA A40 GPU에서 이러한 방법들을 수행할 때의 추론 속도(ms/query), 학습 속도(min/epoch) 및 FLOPs를 보고한다. Table 3에서 보듯이, autoregressive decoder는 허용 가능한 학습 및 추론 속도를 유지하면서 최고의 성능을 달성한다. Charades-STA의 경우 epoch당 2분, FLOPs는 이며, ActivityNet Captions의 경우 epoch당 8분, FLOPs는 이다. 결과적으로, 본 논문의 모든 다른 실험에서는 autoregressive decoder를 CMDecoder로 활용한다.

4.3.2. Ablation on the effect of the length and collection method of query set

우리는 **query set의 최대 길이(모델이 학습 시 인지하고 추론 시 예측할 수 있는 최대 단어 수)**에 대한 ablation study를 수행했다. Table 4에서 보듯이, 최대 길이를 60으로 설정했을 때 전반적으로 가장 좋은 성능을 보였다. Charades-STA에서는 query set 길이가 평균 13.7로 상대적으로 짧기 때문에 성능 차이가 미미하다. 그러나 평균 query set 길이가 50.4인 ActivityNet Captions에서는 성능 우위가 더욱 두드러진다.

또한, 우리는 query set을 수집하는 세 가지 방법에 대한 ablation 실험을 수행했다: 원본 query의 무순서(unordered) 연결, 모든 구두점 제거 후 연결, 순서(ordered) 연결. 결과는 Table 5에 제시되어 있다. Charades-STA에서는 정렬된(sorted) 방식과 원본(original) 방식 간의 성능 차이가 미미하다는 것을 발견했다. 이는 Charades-STA의 query set이 동일한 비디오 세그먼트에 대해 다른 표현을 사용하는 여러 주석을 포함하는 경우가 많기 때문에, 정렬 여부가 전역적인 단서(global clue) 추출에 거의 영향을 미치지 않기 때문이다. 반면, ActivityNet Captions에서는 query set이 더 다양한 내용을 포함하는 경우가 많아, 모델이 국소적으로 고정된 패턴보다는 전역적인 단서를 포착하는 데 무순서 query set이 더 유리하다. 따라서 Table 5에서 보듯이, ActivityNet Captions에서는 원본 수집 전략이 정렬된 전략보다 상당한 성능 우위를 보인다. 구두점은 전역적인 단서를 인지할 때 문장을 분할하는 데 중요한 역할을 하므로, query set 수집 시 구두점을 제거하면 두 데이터셋 모두에서 성능이 크게 하락한다. 결과적으로, 원본 query의 무순서 연결 방식이 전반적으로 가장 좋은 성능을 달성한다.

4.3.3. Ablation on the weight of the query set prediction loss

우리는 (14)의 다양한 가중치 가 성능에 미치는 영향을 평가한다. Table 6에서 보듯이, 가 0.5로 설정되었을 때 가장 좋은 성능을 보였으며, 1에서는 약간의 하락이, 0.25와 2에서는 상당한 성능 저하가 나타났다. 우리는 이를 다음과 같은 이유로 설명한다:

- Query set prediction은 우리 모델에 있어 중요한 보조 task 역할을 하므로, 그 손실에 너무 작은 가중치를 부여하면 학습 과정에서 무시될 수 있다.

- 반면에, 이 task는 어렵고 주된 학습 목표가 아니기 때문에, 너무 높은 가중치를 부여하면 학습 과정이 잘못 유도될 수 있다.

따라서, 손실 가중치는 query reconstruction loss의 가중치(1)보다 약간 작게 설정되어야 한다.

4.4. Quantitative results and limitations

우리는 global clue, masked query, query set, 비디오 표현에 대해 t-SNE 분석을 수행하여 재구성 과정에서 global clue의 안내 역할을 추가로 입증한다. Fig. 5에서 볼 수 있듯이, 이 두 예시에서 query 내 global clue와 관련된 내용이 나머지 부분에 비해 outlier이고 masked되어 있음에도 불구하고, global clue가 효과적으로 모델링된다. 또한, global clue의 표현이 명시적인 패턴을 따르지 않아, query set으로부터 사소한 방법(예: 가중합)으로 모델링하기 어렵다는 것을 관찰할 수 있다.

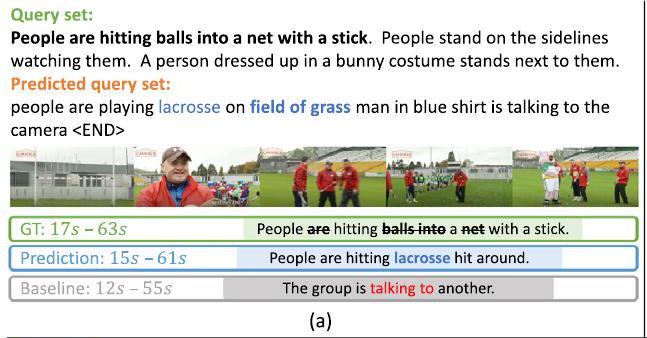

Fig. 6에서는 우리가 제안하는 방법이 query set의 예측을 완료하고, global clue를 추출하며, 이 clue를 활용하여 재구성 프로세스를 안내하는 방식을 보여준다. 처음 세 가지 예시(a, b, c)에서, 우리는 제안된 모델이 현재 query와 비디오를 기반으로 전체 query set을 정확하게 예측하여, (a)의 "lacrosse", (b)의 "skateboard", (c)의 "throwing"과 같은 합리적인 global clue를 포착하는 것을 볼 수 있다. Global clue를 기반으로, 우리 모델은 baseline보다 비디오 콘텐츠를 더 효과적으로 이해하고 더 견고한 재구성을 수행할 수 있다. 이 예시들을 통해, 비디오 콘텐츠가 query set에 따라 중요한 주요 스토리라인을 가질 때, 우리 모델이 관련 정보를 효과적으로 포착하고 이를 재구성 모델에 중요한 지침을 제공하는 global clue로 추출한다는 것을 알 수 있다.

우리는 또한 Fig. 6(d)에 나타난 것처럼 우리의 VGCI가 baseline의 성능을 향상시키지 못하는 예시도 제공한다. 이 경우, 우리가 제안한 VGCI는 query set이 초점을 맞추는 비디오 내 시각적 콘텐츠를 정확하게 인지했으며, 이는 예측된 query set인 "camera pans all around lake with several shots of people riding down river"로 확인된다. 그러나 최종 재구성 결과는 baseline보다 개선되지 않았는데, 이는 두 가지 이유 때문일 수 있다. 첫째, 이 비디오에서는 "people talks"와 "shots of rafters"와 관련된 시각적 콘텐츠가 자주 번갈아 나타나, 모델이 포착된 global clue인 "camera"와 로컬 시각적 콘텐츠 사이에 견고한 종속성을 확립하기 어렵게 만든다. 또한, 핵심 시각적 콘텐츠가 global clue인 카메라가 포착하는 내용임에도 불구하고, 카메라 자체가 비디오에 개체로 나타나지 않는다. 이는 모델이 **global clue가 구체적인 개체인지 추상적인 개념인지(이 "camera"의 경우 자기 참조적)**를 파악하기 위해 **더 높은 수준의 지능(예: 대규모 vision-language model에서 얻은 global clue에 대한 사전 지식)**이 필요할 수 있음을 시사하며, 이를 통해 global clue를 재구성 안내에 더 잘 활용할 수 있을 것이다.

5. Conclusion

본 논문에서는 query reconstruction 기반의 weakly supervised video moment retrieval에서 발생하는 혼란스러운 재구성(confusing reconstruction) 문제를 해결하기 위해 인과적 관점(causal perspective)에서 Variational Global Clue Inference (VGCI) network를 제안한다. 전체 비디오에 해당하는 query set은 비디오 내의 추상적인 global clue를 표현하는 데 근본적인 역할을 하며, 개별 query reconstruction을 본질적으로 안내하지만, 기존 연구에서는 이러한 점이 간과되었다. 이를 위해 우리는 학습 중에 query와 전체 비디오를 기반으로 query set을 예측하는 cross-modality 모듈을 설계하여, 이 global clue를 Gaussian latent variable로 모델링할 것을 제안한다. 따라서 추론 시에는 ground truth query set에 접근하지 않고도 global clue의 사후 추정(posterior estimation)을 수행할 수 있으며, 더욱 견고한 reconstruction 기반의 cross-modality alignment 측정을 달성할 수 있다. 그러나 제안된 VGCI는 다음과 같은 방식으로 여전히 개선될 수 있다: 첫째, local context 내에서 global clue와 비디오 콘텐츠 간의 불일치를 감지하고, 이것이 후속 재구성에 미치는 영향을 완화하는 것이다. 한 가지 잠재적인 접근 방식은 global clue의 기반으로 query set에 의존하는 대신, 사전학습된 대규모 video-language model을 통해 비디오에 간략한 캡션을 주석하는 것이다. 또한, 더 다양한 비디오 유형을 포함하는 데이터셋으로 테스트하고, 더 강력한 multi-modal 사전학습 모델을 visual 및 text encoder로 사용하는 것도 weakly supervised video moment retrieval 분야의 추가 연구를 위한 잠재적인 방향이다.

Table 5 학습 중 query set 수집 방식에 대한 ablation. 가장 좋은 결과는 굵게 표시되었다.

| Collection | Charades-STA | ActivityNet Captions | |||||

|---|---|---|---|---|---|---|---|

| Sorted | 68.81 | 50.44 | 25.79 | 82.92 | 58.85 | 31.07 | |

| No punctuation | 67.60 | 49.31 | 24.53 | 81.32 | 57.28 | 30.19 | |

| Original |

Fig. 5. global clue guided reconstruction의 t-SNE 시각화 분석. 왼쪽 예시에서 "shoes"가 마스킹되었을 때, 다른 시각적 콘텐츠(예: 사람, 가방, 장소 등)가 잠재적인 관심 지점이 된다. global clue는 "shoes"에 가깝게 효과적으로 모델링되며, 이는 다른 query token들과 상대적으로 거리가 멀다. 오른쪽 예시에서는 "eat"과 관련된 global clue도 추출된다. 이 예시들에서 global clue가 query set의 평균이 아니라는 점은, global clue의 학습 가능한 모델링 방법론의 효과를 더욱 잘 보여준다.

Fig. 5. global clue guided reconstruction의 t-SNE 시각화 분석. 왼쪽 예시에서 "shoes"가 마스킹되었을 때, 다른 시각적 콘텐츠(예: 사람, 가방, 장소 등)가 잠재적인 관심 지점이 된다. global clue는 "shoes"에 가깝게 효과적으로 모델링되며, 이는 다른 query token들과 상대적으로 거리가 멀다. 오른쪽 예시에서는 "eat"과 관련된 global clue도 추출된다. 이 예시들에서 global clue가 query set의 평균이 아니라는 점은, global clue의 학습 가능한 모델링 방법론의 효과를 더욱 잘 보여준다.

Query set:

An animated logo appears. A young person stands in the street with their skateboard and performs some simple tricks. An advertisement about mastering skateboarding is shown. Predicted query set: young man is seen sitting on skateboard and speaking to the camera the man then begins performing various tricks on skateboard the man continues

(b)

(b)

Query set: person sits in a chair. person sits down on a chair. person throwing a blanket onto the vacuum. person they throw their clothes on to a nearby desk. Predicted query set: person throwing a blanket onto the floor person throwing a blanket on the chair <END>

Query set:

Query set:

Group of rafters are going through turbulent waters. Woman talks to the camera between shots of the rafters. They use their paddles as they go over the falls Predicted query set:

camera pans all around lake with several shots of people riding down river and leads into shots of people riding the river the river the people continue to speak to the camera <END>

| GT: | Woman talks to the camera between shots of the rafters. |

|---|---|

| Prediction: | The woman are sitting beer one hands |

| Baseline: | The are are sitting beer one hands |

(d)

Fig. 6. query set 예측, query reconstruction, 그리고 video moment localization에 대한 정량적 결과. 현재 query는 query set 내에서 굵게 표시되어 있다. (a), (b), (c)의 결과는 우리 방법이 query set을 정확하게 예측하고 global clue(예: 파란색 굵은 글씨)를 효과적으로 추출할 수 있음을 보여준다. 그러나 (d)에서는 우리 방법이 카메라 중심의 global clue를 식별했음에도 불구하고, 해당 query를 재구성하는 데 실패한다. 이에 대한 가능한 이유는 이 비디오 세그먼트에서 "talks to the camera"와 "rafters"가 자주 번갈아 나타나 global clue와 local content 사이에 불일치가 발생하여 재구성이 어려워지기 때문이다.

Table 6 query set prediction loss 의 가중치에 대한 ablation. 가장 좋은 결과는 굵게 표시되었다.

| Charades-STA R@1 | ActivityNet Captions R@1 | ||||||

|---|---|---|---|---|---|---|---|

| IoU | IoU | IoU | IoU | IoU | IoU | ||

| 0.25 | 68.44 | 49.70 | 24.92 | 83.05 | 57.26 | 30.53 | |

| 0.5 | |||||||

| 1 | 68.79 | 50.28 | 25.61 | 83.14 | 58.66 | 31.27 | |

| 2 | 66.48 | 49.67 | 23.97 | 81.08 | 57.30 | 29.89 |

CRediT authorship contribution statement

Zezhong Lv: Writing - review & editing, Writing - original draft, Visualization, Validation, Software, Methodology, Investigation, Formal analysis, Data curation. Bing Su: Writing - review & editing, Supervision, Project administration, Methodology, Funding acquisition, Conceptualization.

Declaration of competing interest

저자들은 본 논문에 보고된 연구에 영향을 미쳤을 수 있는 어떠한 경쟁적인 재정적 이해관계나 개인적인 관계도 없음을 밝힌다.

Acknowledgments

본 연구는 중국 국가자연과학기금(National Natural Science Foundation of China) No. 62376277 및 No. 61976206, 그리고 Doubao large model fund의 지원을 받아 수행되었다.

Appendix. Analytical solution of KLD between true and approximated posterior distributions of global clue

(13)의 손실 함수를 효율적으로 최적화하기 위해, 우리는 샘플링 대신 수치적 해법을 사용하여 주어진 평균과 분산을 가진 두 다변량 가우시안 분포 사이의 두 번째 항을 계산할 수 있다.

유도를 단순화하기 위해, 먼저 다음 보조정리(lemma)를 제시한다.

보조정리 1. 가우시안 분포 를 따르는 변수 와 행렬 가 주어졌을 때, 다음이 성립한다:

여기서 은 행렬의 trace를 나타낸다.

Proof.

true posterior 와 근사된 posterior 를 사용하여, (13)의 KLD (Kullback-Leibler Divergence) 항을 다음과 같이 다시 작성할 수 있다:

Data availability

데이터는 요청 시 제공될 예정이다.